标签:批处理 内存 查询 pac 作业 行数据 数据库 处理 正则

处理实时的大数据流最常用的就是分布式计算系统,下面分别介绍Apache中处理大数据流的三大框架:

这是一个分布式实时大数据处理系统。Storm设计用于在容错和水平可扩展方法中处理大量数据。他是一个流数据框架,具有最高的社区率。虽然Storm是无状态的,它通过ApacheZooKeeper管理分布式环境和鸡群状态。使用起来非常简单,并且还支持并行地对实时数据执行各种操作。

Apache Storm继续成为实时数据分析的领导者是因为它的易于操作和设置,并且它保证每个消息将通过拓扑至少处理一次。使用storm时常常会设计一个用于实时计算的土状结构,称之为拓扑(topplogy)。将这个拓扑提交给集群之后,集群中的主控节点(master node)将分发代码,将任务分配给工作节点(worker node)。拓扑结构中履行职能的角色有两种:spout和bolt,其中spout发送消息,负责将数据流以tuple元组(不可变数组,固定的键值对)的形式发送出去;bolt则负责转换这些数据流,在bolt中可以完成计算、过滤等操作,bolt之间也可以随机互相发送消息。

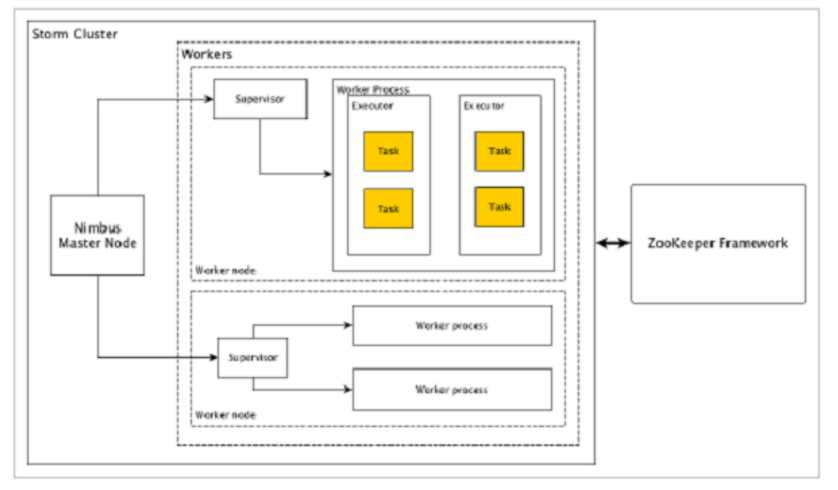

下面是Storm的集群设计和其内部架构。

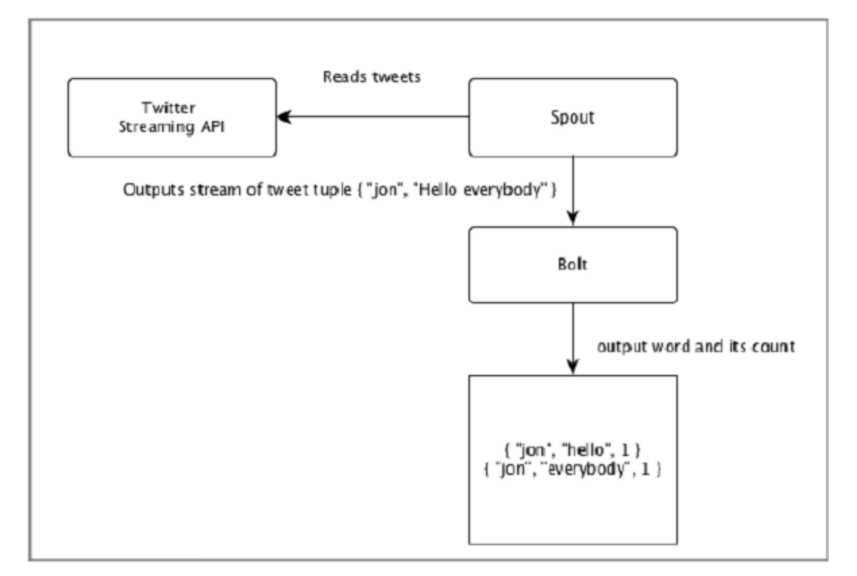

Twitter使用Storm框架处理流式大数据的应用场景:

Twitter分析的输入来自Twitter Streaming API。Spout将使用Twitter Streaming API读取用户的tweets,并作为元组流输出。来自spout的单个元组将具有twitter用户名和单个tweet作为逗号分隔值。然后,这个元组的蒸汽将被转发到Bolt,并且Bolt将tweet拆分成单个字,计算字数,并将信息保存到配置的数据源。现在,我们可以通过查询数据源轻松获得结果。

Apache Storm vs Hadoop

基本上Hadoop和Storm框架用于分析大数据。两者互补,在某些方面有所不同。Apache Storm执行除持久性之外的所有操作,而Hadoop在所有方面都很好,但滞后于实时计算。下表比较了Storm和Hadoop的属性。

| Storm | Hadoop |

|---|

| 实时流处理 |

批量处理 |

| 无状态 |

有状态 |

| 主/从架构与基于ZooKeeper的协调。主节点称为nimbus,从属节点是主管。 |

具有/不具有基于ZooKeeper的协调的主 - 从结构。主节点是作业跟踪器,从节点是任务跟踪器。 |

| Storm流过程在集群上每秒可以访问数万条消息。 |

Hadoop分布式文件系统(HDFS)使用MapReduce框架来处理大量的数据,需要几分钟或几小时。 |

| Storm拓扑运行直到用户关闭或意外的不可恢复故障。 |

MapReduce作业按顺序执行并最终完成。 |

| 两者都是分布式和容错的 |

| 如果nimbus / supervisor死机,重新启动使它从它停止的地方继续,因此没有什么受到影响。 |

如果JobTracker死机,所有正在运行的作业都会丢失。 |

使用Apache Storm的例子

Apache Storm对于实时大数据流处理非常有名。因此,大多数公司都将Storm用作其系统的一个组成部分。一些值得注意的例子如下 -

Twitter - Twitter正在使用Apache Storm作为其“发布商分析产品”。 “发布商分析产品”处理Twitter平台中的每个tweets和点击。 Apache Storm与Twitter基础架构深度集成。

NaviSite - NaviSite正在使用Storm进行事件日志监控/审计系统。系统中生成的每个日志都将通过Storm。Storm将根据配置的正则表达式集检查消息,如果存在匹配,那么该特定消息将保存到数据库。

Wego - Wego是位于新加坡的旅行元搜索引擎。旅行相关数据来自世界各地的许多来源,时间不同。Storm帮助Wego搜索实时数据,解决并发问题,并为最终用户找到最佳匹配。

Apache Storm优势

Storm优势就在于Storm是实时的连续性的分布式计算框架,一旦运行起来,除非你将它杀掉,否则将一直Strom一直处于处理计算或者等

待计算的状态,这一点Spark和hadoop都做不到。但是这些框架各有各的优点,每种框架都有自己的最佳应用场景。Storm是最佳的流式计算框架,Storm由Java和Clojure写成,Storm的优点是全内存计算,所以它的定位是分布式实时计算系统,按照Storm作者的说法,Storm对于实时计算的意义类似于Hadoop对于批处理的意义。

Storm的适用场景:

1)流数据处理

Storm可以用来处理源源不断流进来的消息,处理之后将结果写入到某个存储中去。

2)分布式RPC。由于Storm的处理组件是分布式的,而且处理延迟极低,所以可以作为一个通用的分布式RPC框架来使用。

Spark Streaming是核心Spark API的一个扩展,它并不会像Storm那样一次一个地处理数据流,而是在处理前按时间间隔预先将其切分为一段一段的批处理作业。Spark针对持续性数据流的抽象称为DStream(DiscretizedStream),一个DStream是一个微批处理(micro-batching)的RDD(弹性分布式数据集);而RDD则是一种分布式数据集,能够以两种方式并行运作,分别是任意函数和滑动窗口数据的转换。

Spark提交作业的方式有两种:

Samza处理数据流时,会分别按次处理每条收到的消息。Samza的流单位既不是元组,也不是Dstream,而是一条条消息。在Samza中,数据流被切分开来,每个部分都由一组只读消息的有序数列构成,而这些消息每条都有一个特定的ID(offset)。该系统还支持批处理,即逐次处理同一个数据流分区的多条消息。Samza的执行与数据流模块都是可插拔式的,尽管Samza的特色是依赖Hadoop的Yarn(另一种资源调度器)和Apache Kafka。

共同之处:

以上三种实时计算系统都是开源的分布式系统,具有低延迟、可扩展和容错性诸多优点,它们的共同特色在于:允许你在运行数据流代码时,将任务分配到一系列具有容错能力的计算机上并行运行。此外,它们都提供了简单的API来简化底层实现的复杂程度。

不同之处:

从应用的角度来分析,:

如果你想要的是一个允许增量计算的高速事件处理系统,Storm会是最佳选择。它可以应对你在客户端等待结果的同时,进一步进行分布式计算的需求,使用开箱即用的分布式RPC(DRPC)就可以了。最后但同样重要的原因:Storm使用Apache Thrift,你可以用任何编程语言来编写拓扑结构。

如果你需要状态持续,同时/或者达到恰好一次的传递效果,应当看看更高层面的Trdent API,它同时也提供了微批处理的方式。

处理大数据流常用的三种Apache框架:Storm、Spark和Samza。(主要介绍Storm)

标签:批处理 内存 查询 pac 作业 行数据 数据库 处理 正则

原文地址:http://www.cnblogs.com/myinspire/p/7273125.html