【中文翻译】

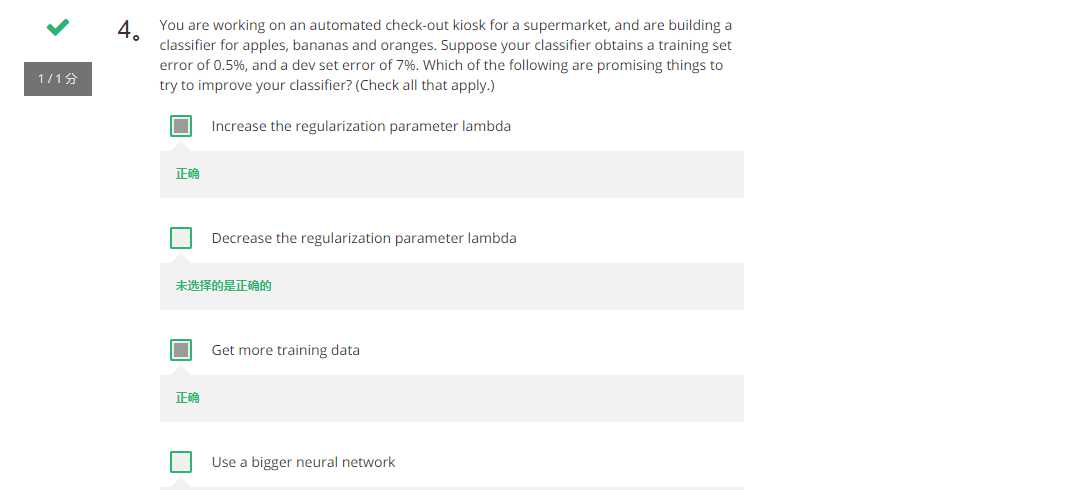

4、你正在一个超市的自动退房亭工作, 并正在建设一个苹果, 香蕉和桔子分类器。假设您的分类器训练集误差是 0.5%, 并且验证集误差为7%。下面哪些是有希望改进分类器的?(检查所有适用的)(A,C)

(A)增加正则化参数 lambda

(B)降低正则化参数 lambda

(C)获取更多训练数据

(D)使用更大的神经网络

【解释】

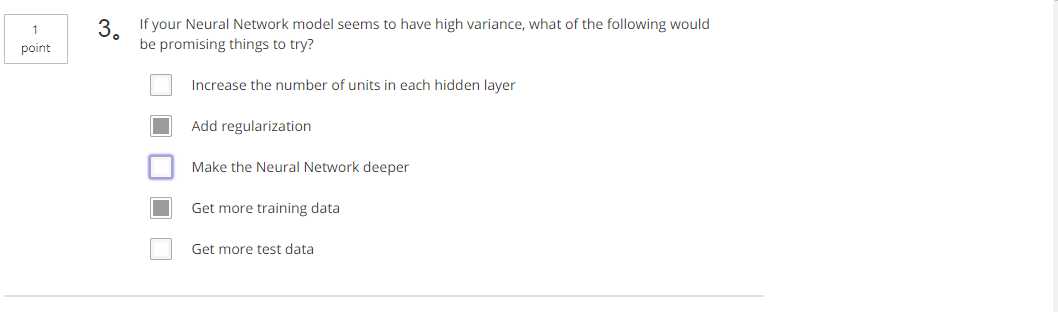

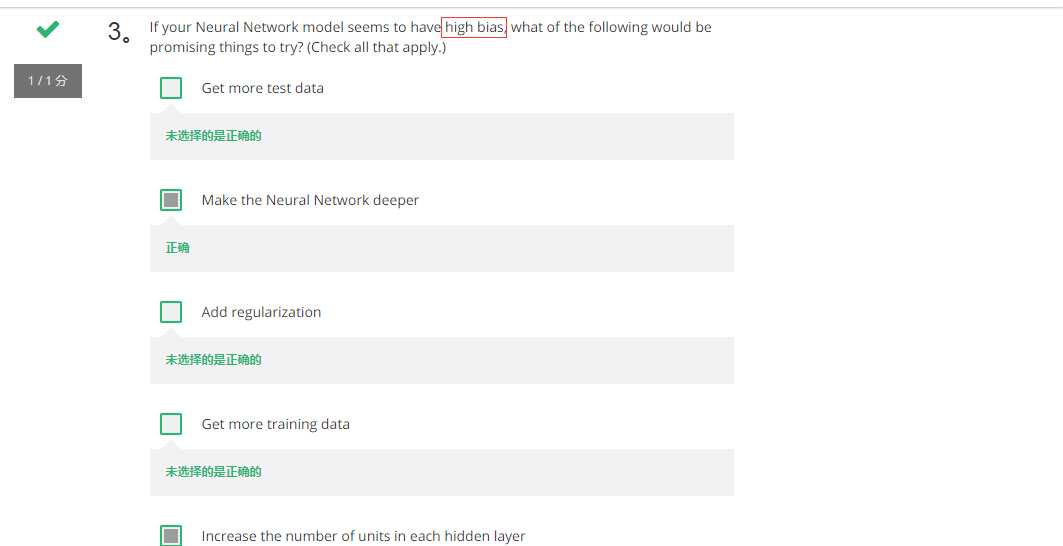

只要正则适度,通常构建一个更大的网络便可以,在不影响方差的同时减少偏差,而采用更多数据通常可以在不过多影响偏差的同时减少方差

【中文翻译】

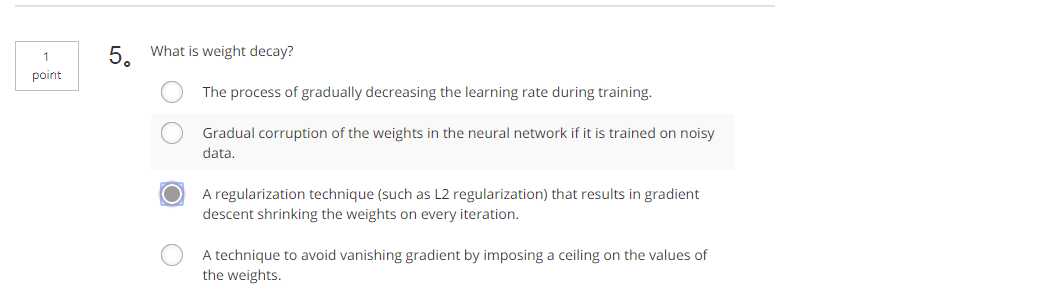

5.什么是权重衰减?

(1)在训练过程中逐渐降低学习速度。

(2)如果对噪声数据进行训练, 就会逐渐损坏神经网络中的权重。

(3)一种正则化技术 (如 L2 正规化), 导致梯度下降在每次迭代中收缩权重。

(4)通过对权重值施加上限来避免梯度消失的技术。

【中文翻译】

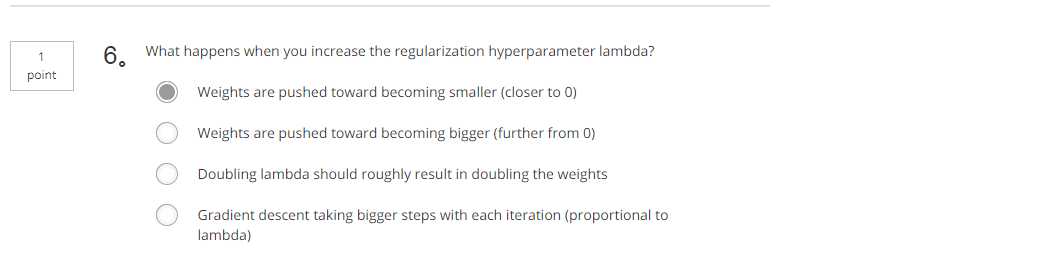

6、当你增加正则化的超参数 lambda 时会发生什么?

(1)权重变小 (接近 0)

(2)重量变得更大 (远离 0)

(3)加倍的λ导致加倍的权重

(4)每次迭代,梯度下降采取更大的步距 (与 lambda 成正比)

【解释】

-------------------------------------------------------------------------------------------------------------------------

答案仅供参考