云地址:https://pan.baidu.com/s/1CmBAJMdcwCxLGuCwSTcJNw 密码:qocw

前提条件:启动集群 ,配置好JDK和hadoop环境变量 有必要删除 虚拟机中的output文件 使用

[root@master sbin]# hadoop fs -rm -r /output

Deleted /output

[root@master sbin]# ll

给hadoop文件权限

[root@master sbin]# hadoop fs -chmod 777 /

1.打开eclopse的安装包

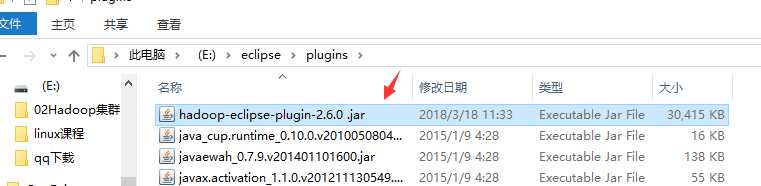

把下载好的hadoop插件 hadoop-eclipse-plugin-2.6.0.jar放到如上的目录下重启ecliplse

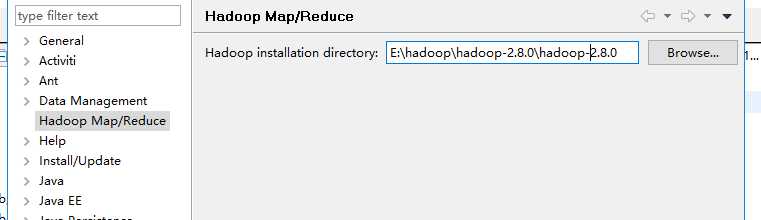

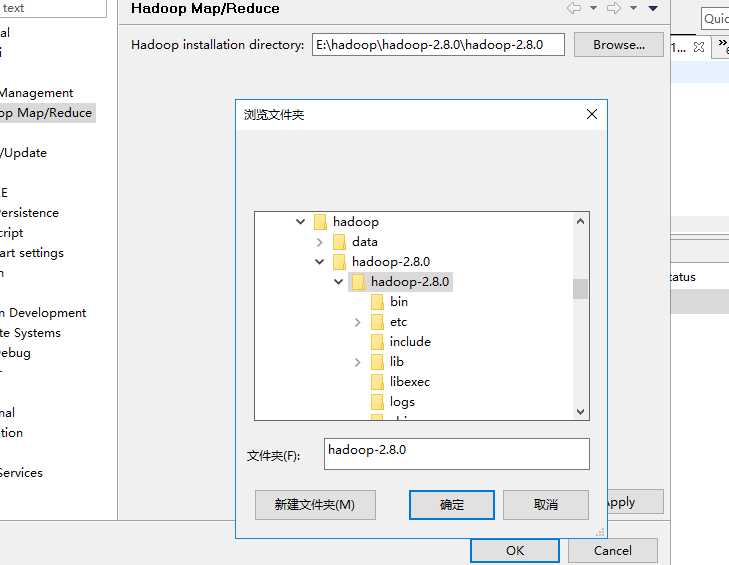

配置hadoop安装路径

选择 window-preferences-hadoop Map/Reduce - hadoop installation directory 命令选择hadoop的安装目录

注意安装目录是你配置环境变量的hadoop不然当你创建wordCount项目的时候会缺少jar包导致不能运行

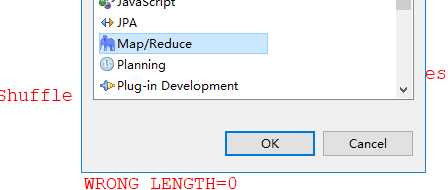

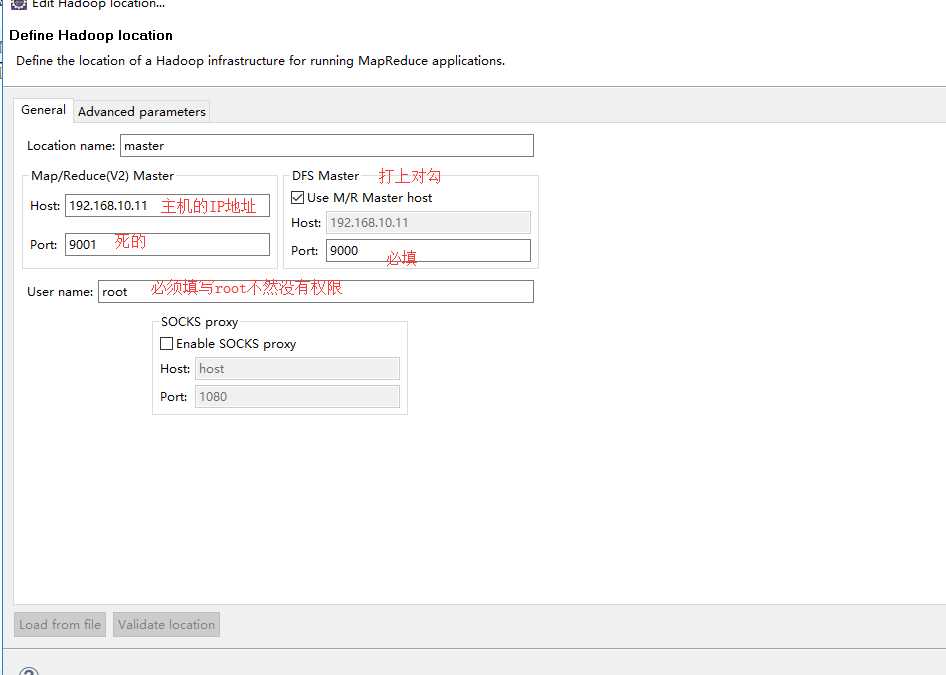

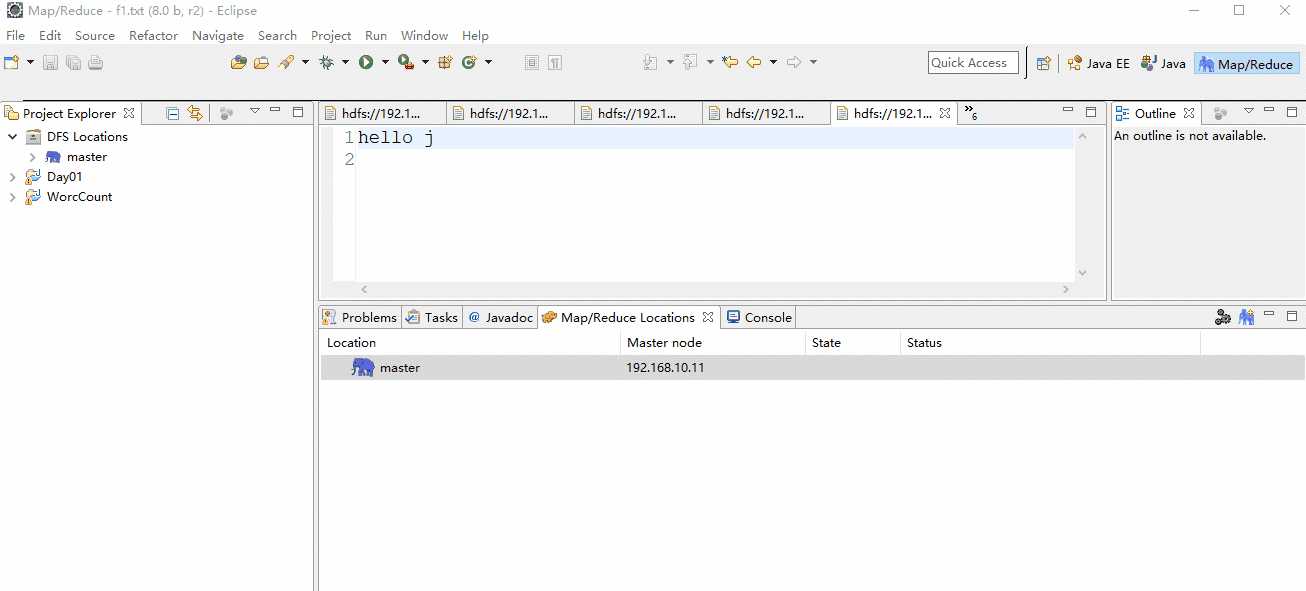

配置Map/reduce

单击 window-show Perspective--other-Map/Reduce-ok 按钮配置 Map/Reduce视图

单机 window-show View-other-Map/reduce-ok按钮显示 Map/Reduce Locations 选项卡

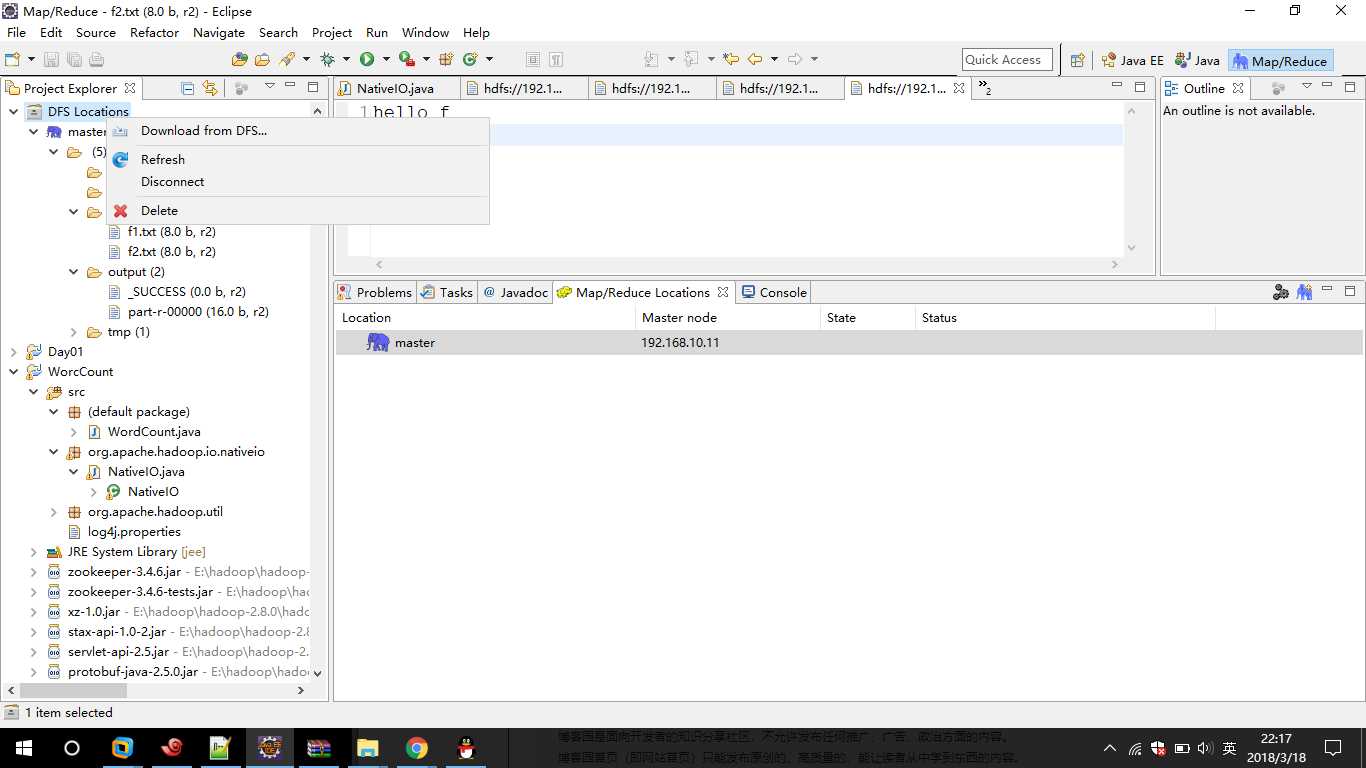

如图所示配置主机对应

如果你的集群配置成功的话

[root@master sbin]# jps

14036 NameNode

19319 Jps

14570 ResourceManager

14302 SecondaryNameNode

这四个配置文件都有的化

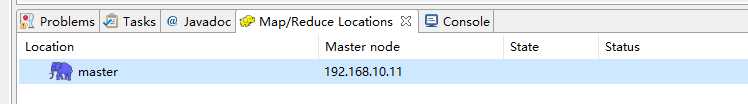

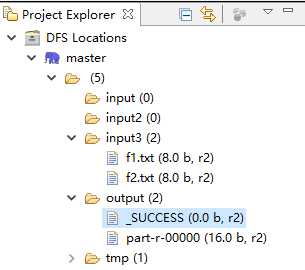

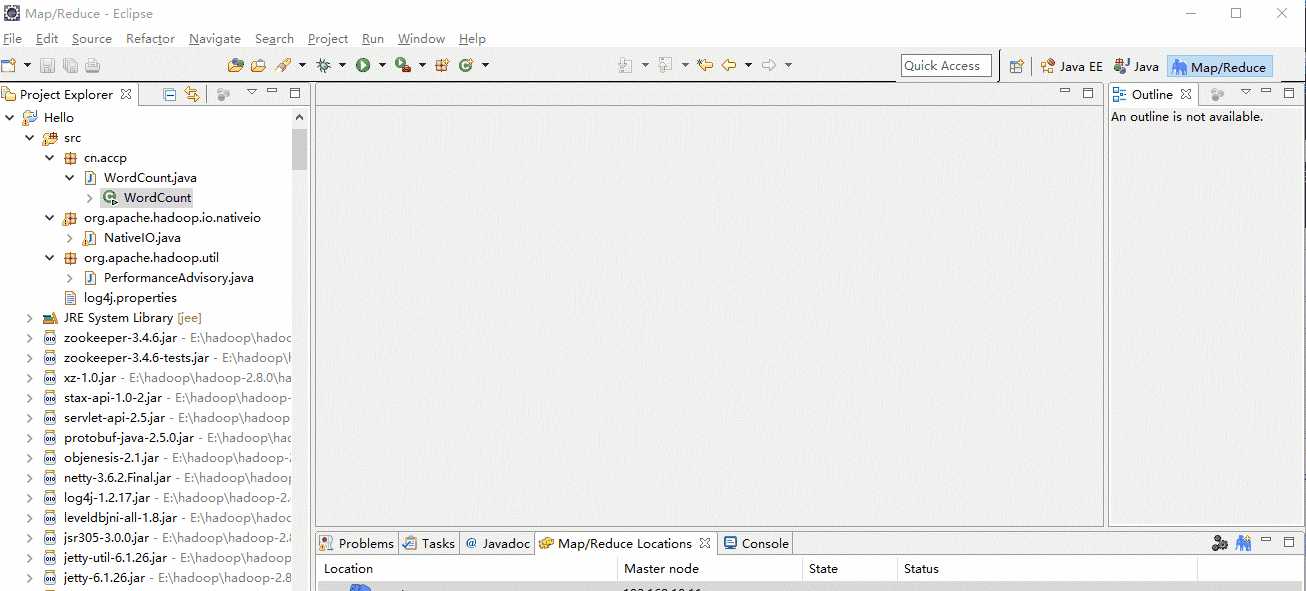

出现如下界面说明连接成功 否侧会包一个

刷新项目

如果到这里啦恭喜成功一半了

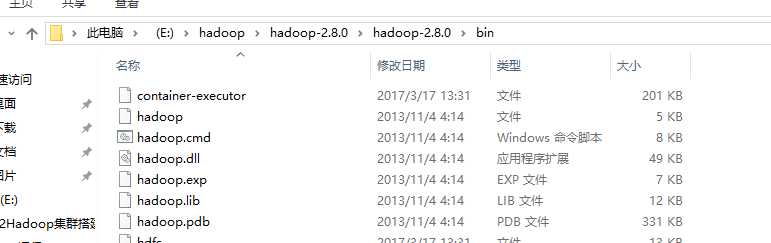

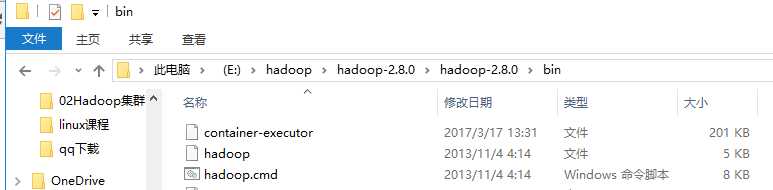

接下来需要更改hadoop的bin下的文件

如图打开目录

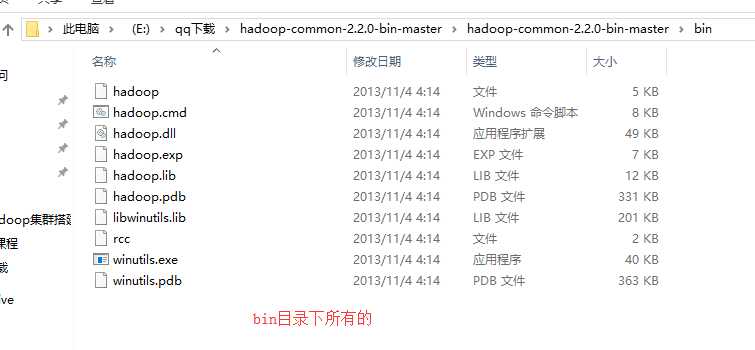

复制我的百度云里面的jar包hadoop-common-2.2.0-bin-master 不同的eclipse版本可能不同

把这个目录下的所有文件copy到hadoop的bin目录下 替换并增加

回到开发环境

新建woredCount项目

正如上图描述hadoop如果配置成功这些jar包一个也不会少尤其是hadoop的jar

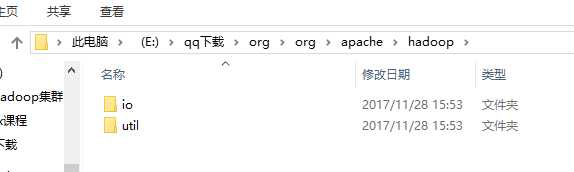

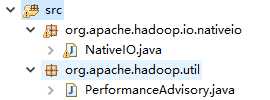

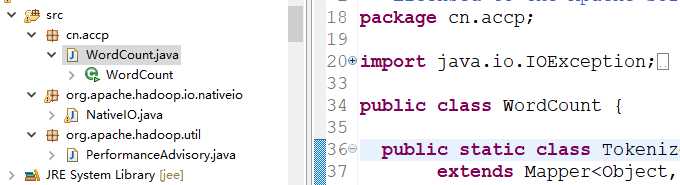

接下来需要我们下载的org包里面的类复制到src目录下为了防止报错

直接copy org整个目录到hello项目的src目录下

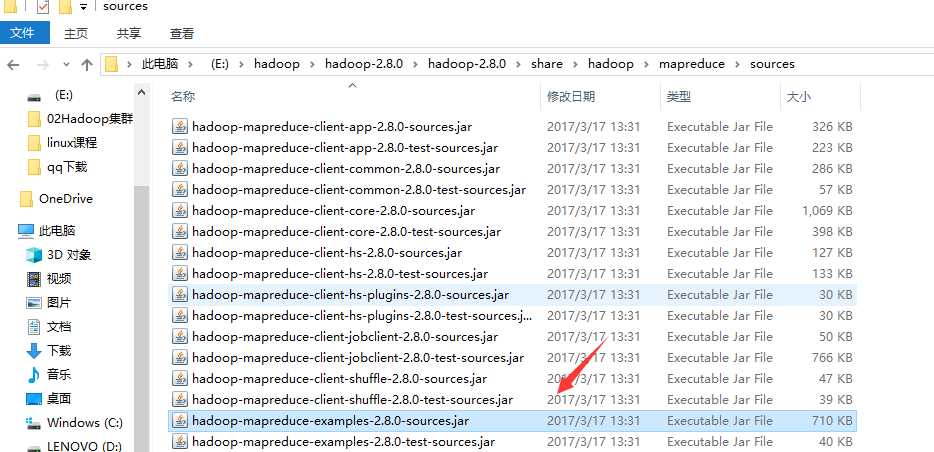

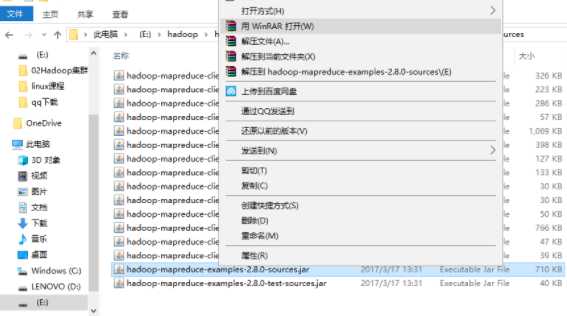

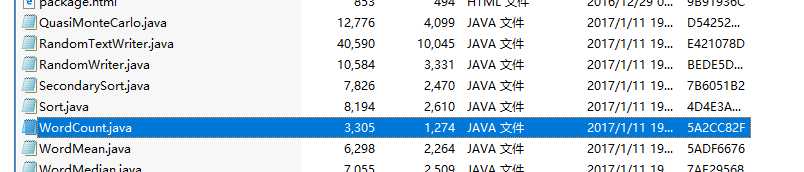

接着找到hadoop自带的提供WordCount示例wordCount.java类

改一下包明

就行了

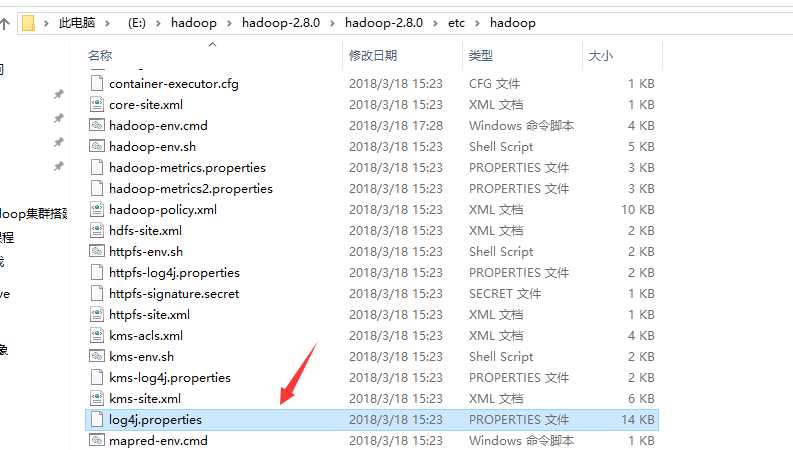

由于文件没有输出所以到hadoop目录下copy一个日志文件

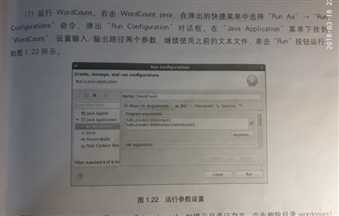

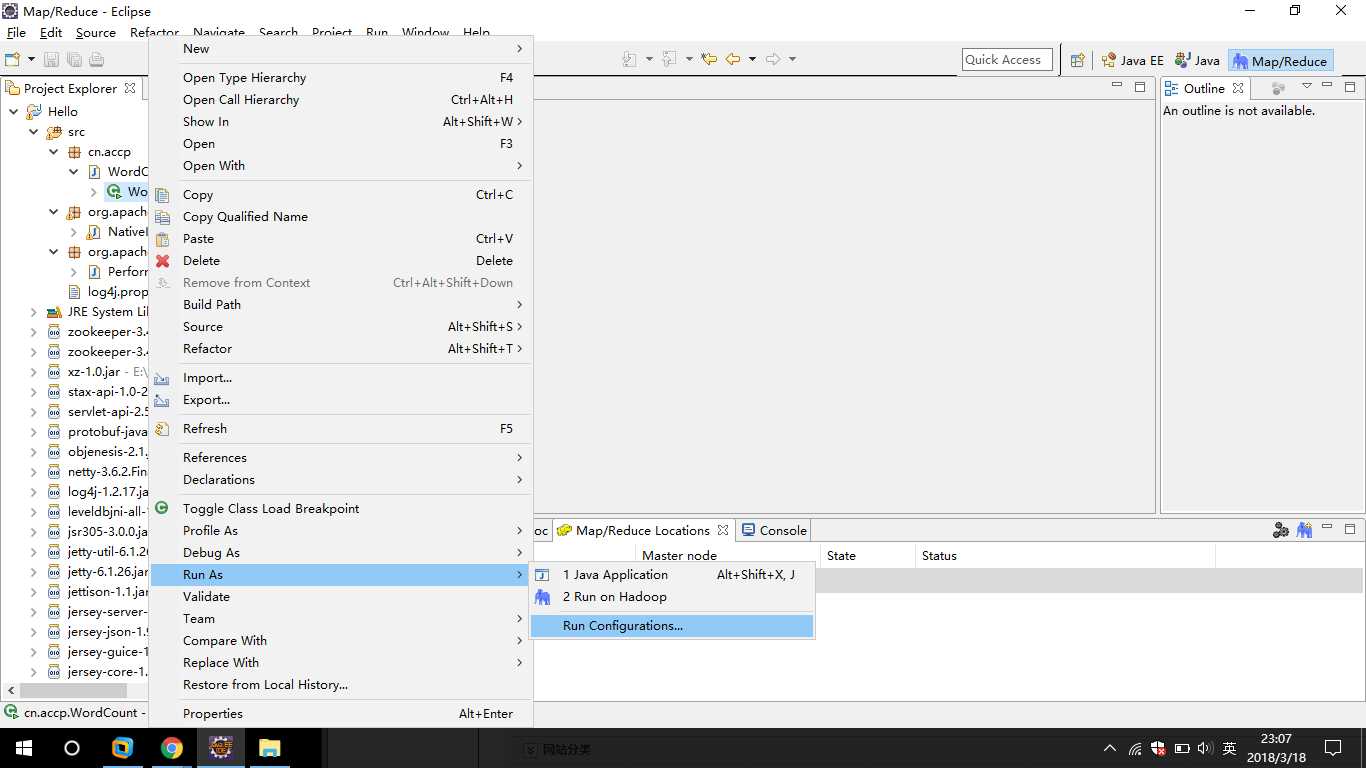

最后一步

hdfs://192.168.10.11:9000/input3

hdfs://192.168.10.11:9000/output/wordcount

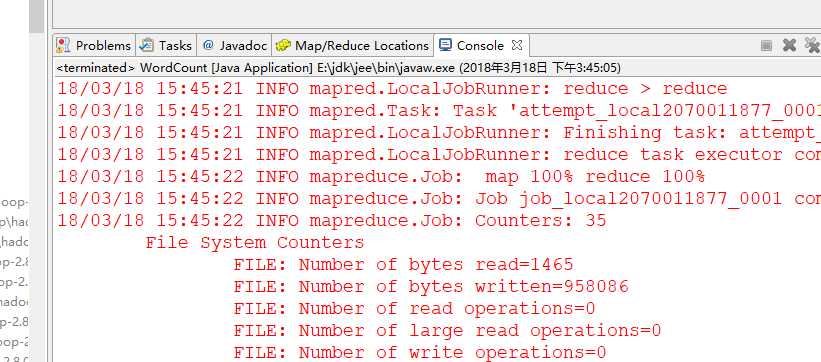

直至控制台打印输出

成功