标签:新版本 java 通过 target 结果 配置 hadoop html 下载地址

Spark 版本:spark-2.4.0-bin-without-hadoop.tgz

下载地址:http://spark.apache.org/downloads.html

下载的时候注意一下,需要下的是最新版本的无 hadoop 版本,因为我们已经在之前装过 hadoop 了。

安装 Spark

sudo tar -zxf ~/Downloads/spark-2.4.0-bin-without-hadoop.tgz -C /usr/local/ cd /usr/local sudo mv ./spark-2.4.0-bin-without-hadoop/ ./spark sudo chown -R hadoop:hadoop ./spark

修改 Spark 的配置文件:spark-env.sh

cd /usr/local/spark cp ./conf/spark-env.sh.template ./conf/spark-env.sh

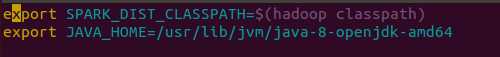

编辑文件 spark-env.sh ( vim ./conf/spark-env.sh ),在第一行添加 hadoop 配置信息:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

保存退出就可以直接使用,同时我也配置了我的 Java 路径(可选)。

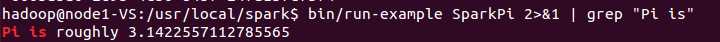

运行 Spark 自带的示例,验证 Spark 是否安装成功:

cd /usr/local/spark bin/run-example SparkPi

行时会输出非常多的运行信息,输出结果不容易找到,可以通过 grep 命令进行过滤(命令中的 2>&1 可以将所有的信息都输出到 stdout 中,否则由于输出日志的性质,还是会输出到屏幕中):

bin/run-example SparkPi 2>&1 | grep "Pi is"

可以看到 Spark 成功安装。

标签:新版本 java 通过 target 结果 配置 hadoop html 下载地址

原文地址:https://www.cnblogs.com/guangluwutu/p/9971853.html