标签:详细 通过 序列 重点 点击 history core mode 二次开发

搜索QQ号直接加群获取其它学习资料:517432778

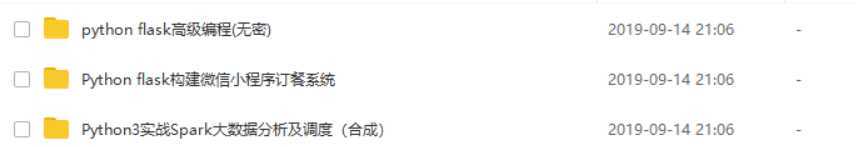

部分课程截图:

链接:https://pan.baidu.com/s/1YMmswv47fOUlt-z2A6691A

提取码:z5xv

PS:免费分享,若点击链接无法获取到资料,若如若链接失效请加群

其它资源在群里,私聊管理员即可免费领取;群——517432778,点击加群,或扫描二维码

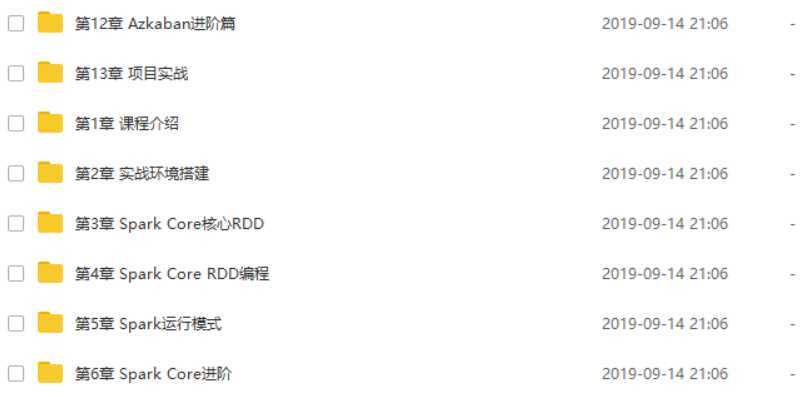

课程介绍

工欲善其事必先利其器,本章讲述JDK、Scala、Hadoop、Maven、Python3以及Spark源码编译及部署

本章详细讲解RDD是什么以及特性(面试常考)、Spark中两个核心类SparkContext和SparkConf、pyspark启动脚本分析、RDD的创建方式以及如何使用IDE开发Python Spark应用程序并提交到服务器上运行

本章将针对RDD中常用的算子进行详细案例讲解,并进行综合案例实战

本章将介绍Spark的几种运行模式,需要重点掌握on YARN模式

本章将介绍Spark中的核心术语、运行架构、并对比Spark和MapReduce的概念区分、存储策略及选择方式、宽窄依赖及Shuffle

本章将从Spark作业性能指标、序列化、内存管理、广播变量及数据本地化这几个方面来介绍Spark作业的调优

本章将讲解Spark SQL的架构、DataFrame&Dataset、以及如何使用Python API来对DataFrame进行编程

本章将讲解Spark Streaming的核心概念、执行原理、以及如何Python API来对Spark Streaming进行编程

本章将讲解Azkaban的特性、架构、运行模式、源码编译及部署、快速入门

本章将讲解如何使用Azkaban来完成HDFS、MapReduce、Hive作业的调度、定时作业调度以及邮件告警

本章将讲解Azkaban在生产上的部署、权限管理、Ajax API、Plugin、以及短信和调度框架的二次开发

本章将讲解在构建大数据平台的技术选型、集群升级资源评估,并使用Spark对气象数据进行分析,讲分析结果写入ES,并通过Kibana进行统计结果的可视化展示

标签:详细 通过 序列 重点 点击 history core mode 二次开发

原文地址:https://www.cnblogs.com/nobug123/p/11524436.html