标签:exp dsp mllib zookeeper and files 测试 mamicode 机器学习算法

生态

特点

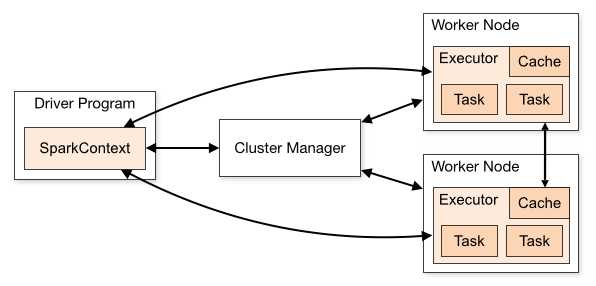

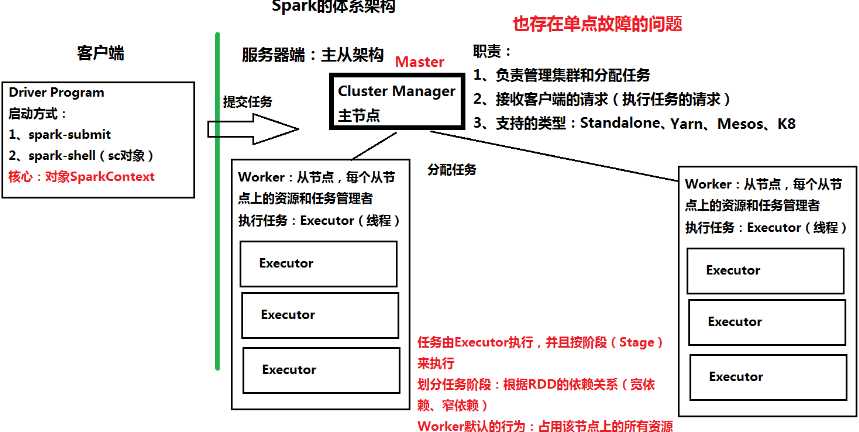

体系架构

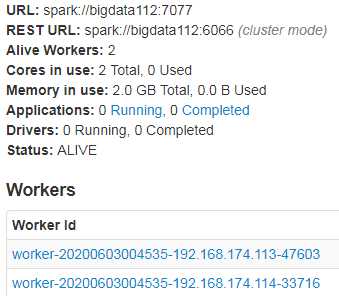

安装部署

HA

![]()

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=bigdata112:2181,bigdata113:2181,bigdata114:2181 -Dspark.deploy.zookeeper.dir=/spark"

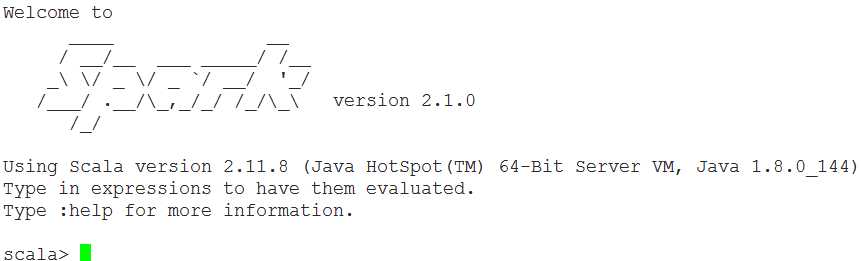

工具

参考

spark.apache.org

标签:exp dsp mllib zookeeper and files 测试 mamicode 机器学习算法

原文地址:https://www.cnblogs.com/cxc1357/p/12713187.html