标签:微软雅黑 blog 越来越大 大于 man -o origin nat lan

先来看一个例子:

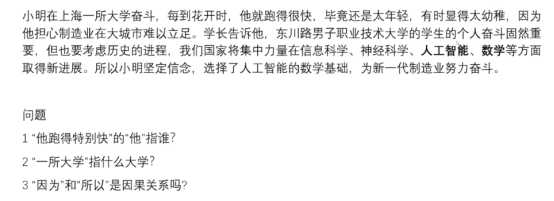

之前的全连接神经网络的结构:它的隐藏层的值只取决于输入的 x:

该结构对于上面问题只能做如下预测:

比如:可以预测:花开时——>跑得快

由此可见:通过简单的神经网络(单层的前馈神经网络)无法解决该三个问题,需要用关联的神经网络来解决。

RNN:Motivation:需要前馈信息。

当前输入+之前输入+后面的信息

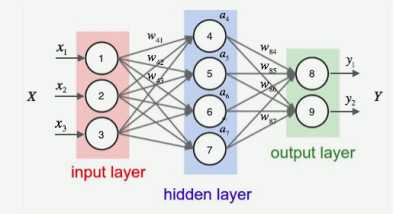

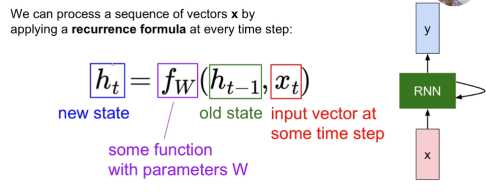

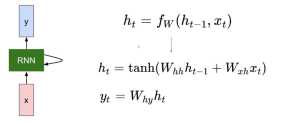

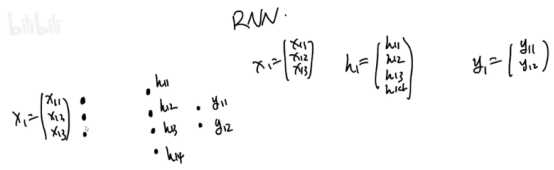

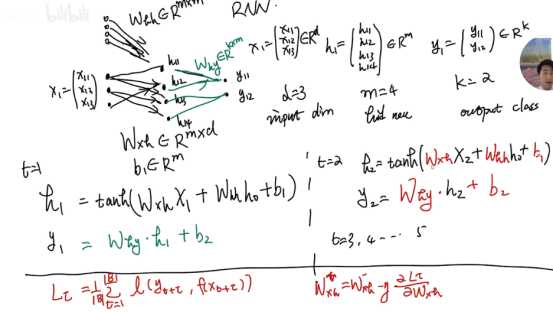

RNN 的隐藏层的值h不仅仅取决于当前这次的输入 x,还取决于上一次隐藏层的值h,其结构图如下:

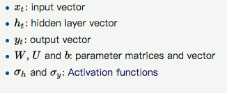

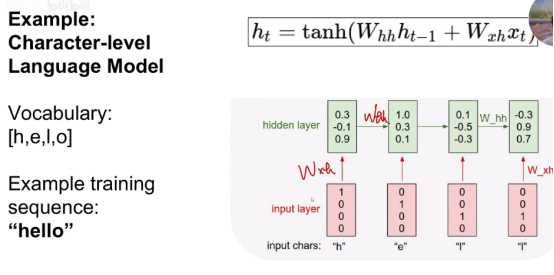

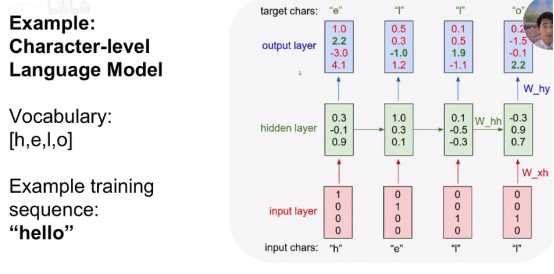

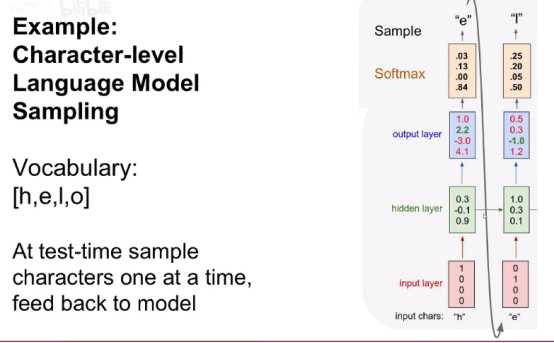

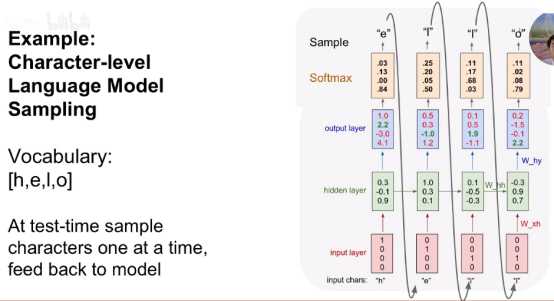

看一个计算的例子:

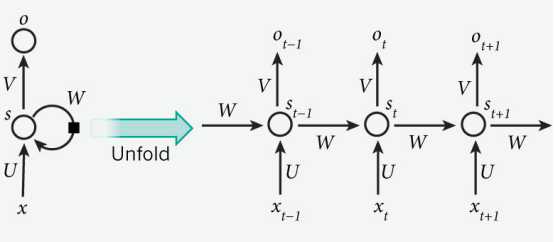

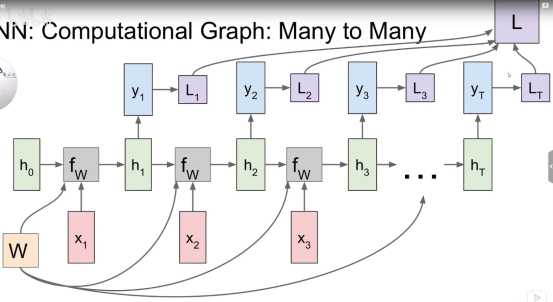

RNN的图解:对应多个输出

举一个预测的例子:

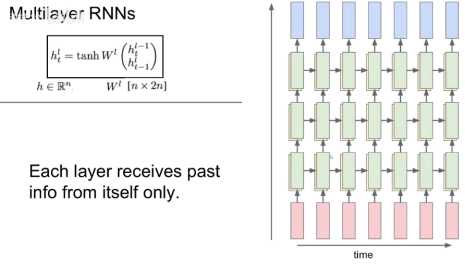

# 多个层的RNN结构:

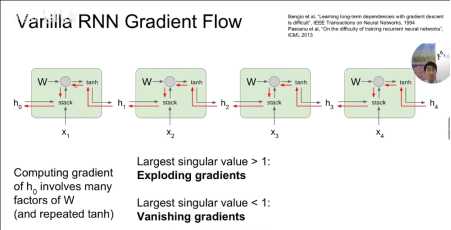

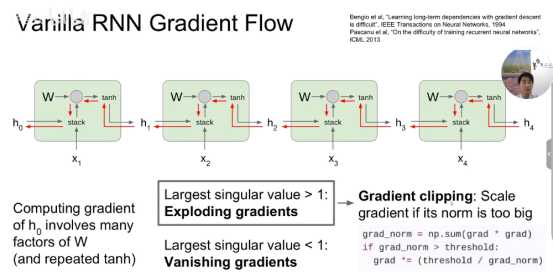

#RNN存在的问题:

序列比较长的关联难以预测,难以抓住太长的关联。

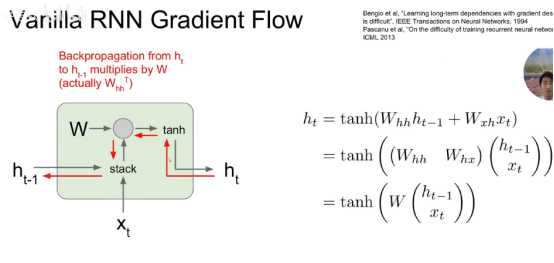

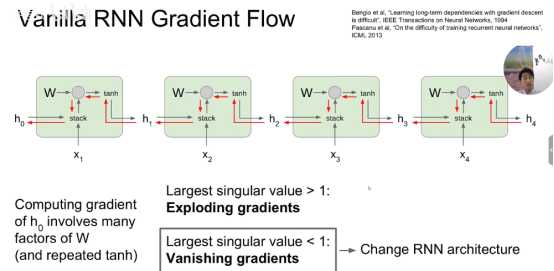

# 梯度消失与梯度爆炸

当序列很长的时候,RNN梯度往回传每一步都要经过Whh,特别是计算h0的梯度,需要经过N个Whh和N个重复的tanh函数,因此在这种情况下,当设置的值大于1,则会产生N个Whh相乘的情况,导致whh的N次方值越来越大,最后梯度爆炸。当设置的值小于1,则会产生梯度消失(改变网络的结构,LSTM解决)。

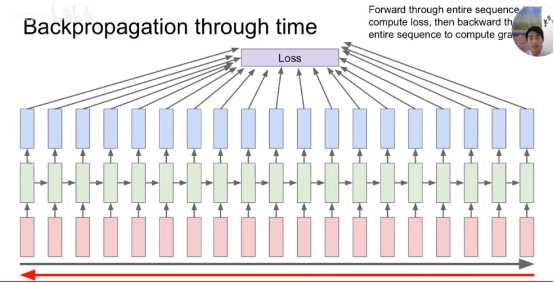

RNN 的训练算法为:BPTT

BPTT 的基本原理和 BP 算法是一样的,同样是三步:

(1)前向计算每个神经元的输出值;

(2)反向计算每个神经元的误差项值,它是误差函数E对神经元j的加权输入的偏导数;

(3)计算每个权重的梯度。

最后再用随机梯度下降算法更新权重。

BPTT手写推导:http://www.jianshu.com/p/9e217cfd8a49

参考链接:

[3]RNN_了不起的赵队-CSDN博客_rnn https://blog.csdn.net/zhaojc1995/article/details/80572098

深度学习算法-循环神经网络(Recurrent Neural Network)讲解学习

标签:微软雅黑 blog 越来越大 大于 man -o origin nat lan

原文地址:https://www.cnblogs.com/gcter/p/13218396.html