标签:sqoop mic 数据 img java tab sele 数据仓库 rmi

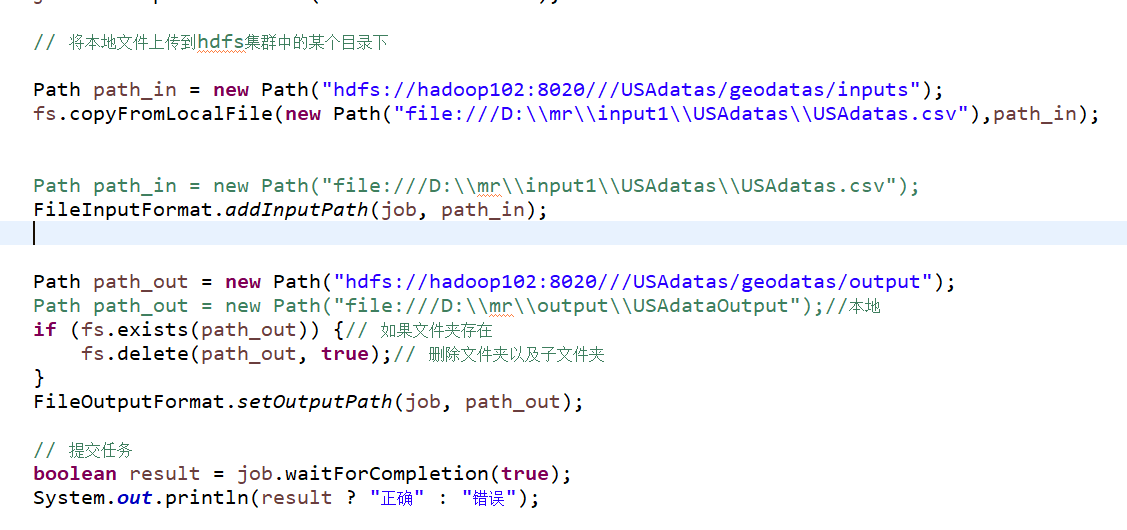

java程序启动前先在hdfs上建立相应文件夹,用于上传本地数据和处理后的数据

[root@hadoop102 ~]# hdfs dfs -mkdir -p /USAdatas/geodatas/inputs

[root@hadoop102 ~]# hdfs dfs -mkdir -p /USAdatas/geodatas/output

将结果上传到hdfs上新建目录/USAdatas/geodatas/inputs下

[root@hadoop102 hive-1.2]# bin/hive

hive> create database db_usa;

hive> use db_usa;

create table t_usaCovid19(

state String,

tot_cases String,

new_case String,

tot_death String,

new_death String,

data String

)

row format delimited

fields terminated by ‘,‘

;

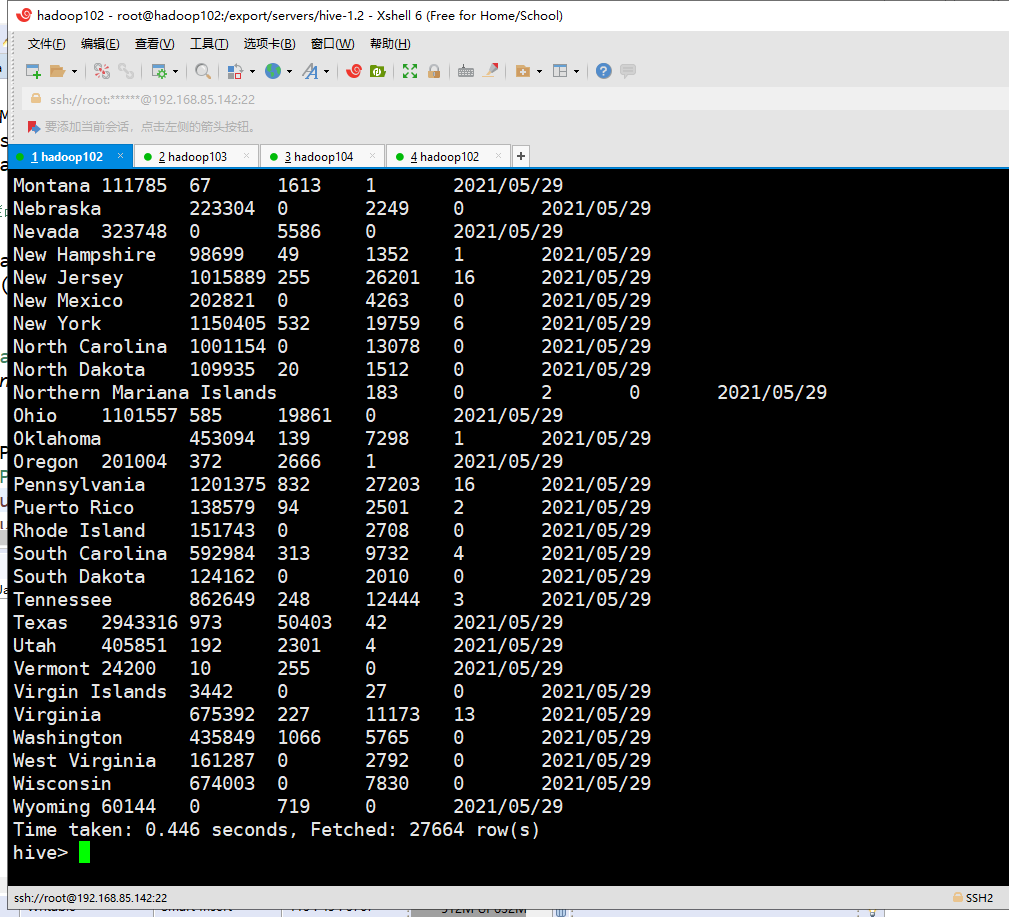

从hdfs上/USAdatas/geodatas/output目录下将处理好的数据加载到新建表t_usaCovid19中

hive> load data inpath ‘/USAdatas/geodatas/output/part-r-00000‘ into table t_usaCovid19;

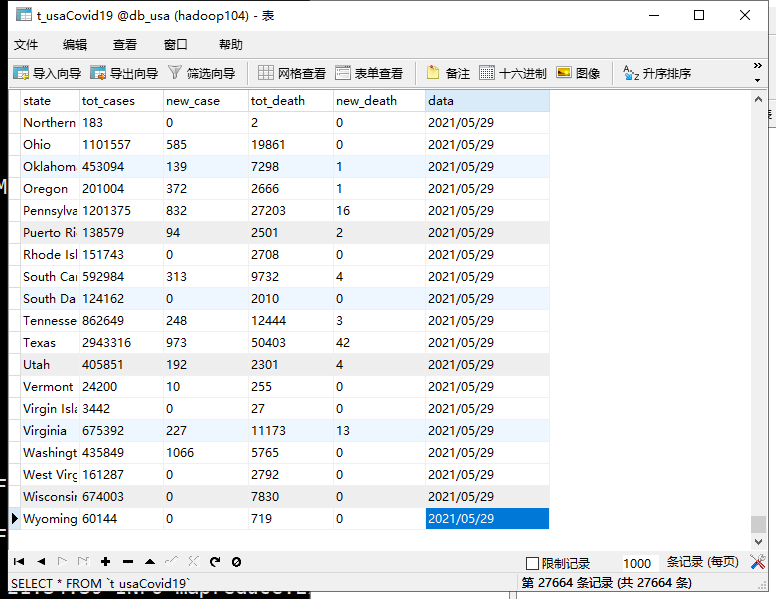

查询表,验证数据是否加载成功

hive> select * from t_usaCovid19;

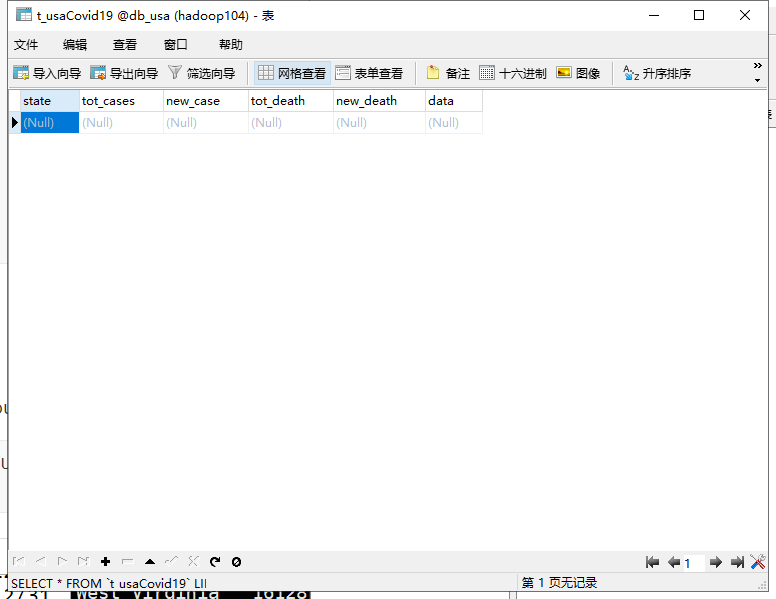

./sqoop export --connect "jdbc:mysql://hadoop104:3306/db_usa?useUnicode=true&characterEncoding=UTF-8" --username root --password 123456 --table t_usaCovid19 --export-dir /user/hive/warehouse/db_usa.db/t_usacovid19 --input-fields-terminated-by ‘,‘ --num-mappers 1

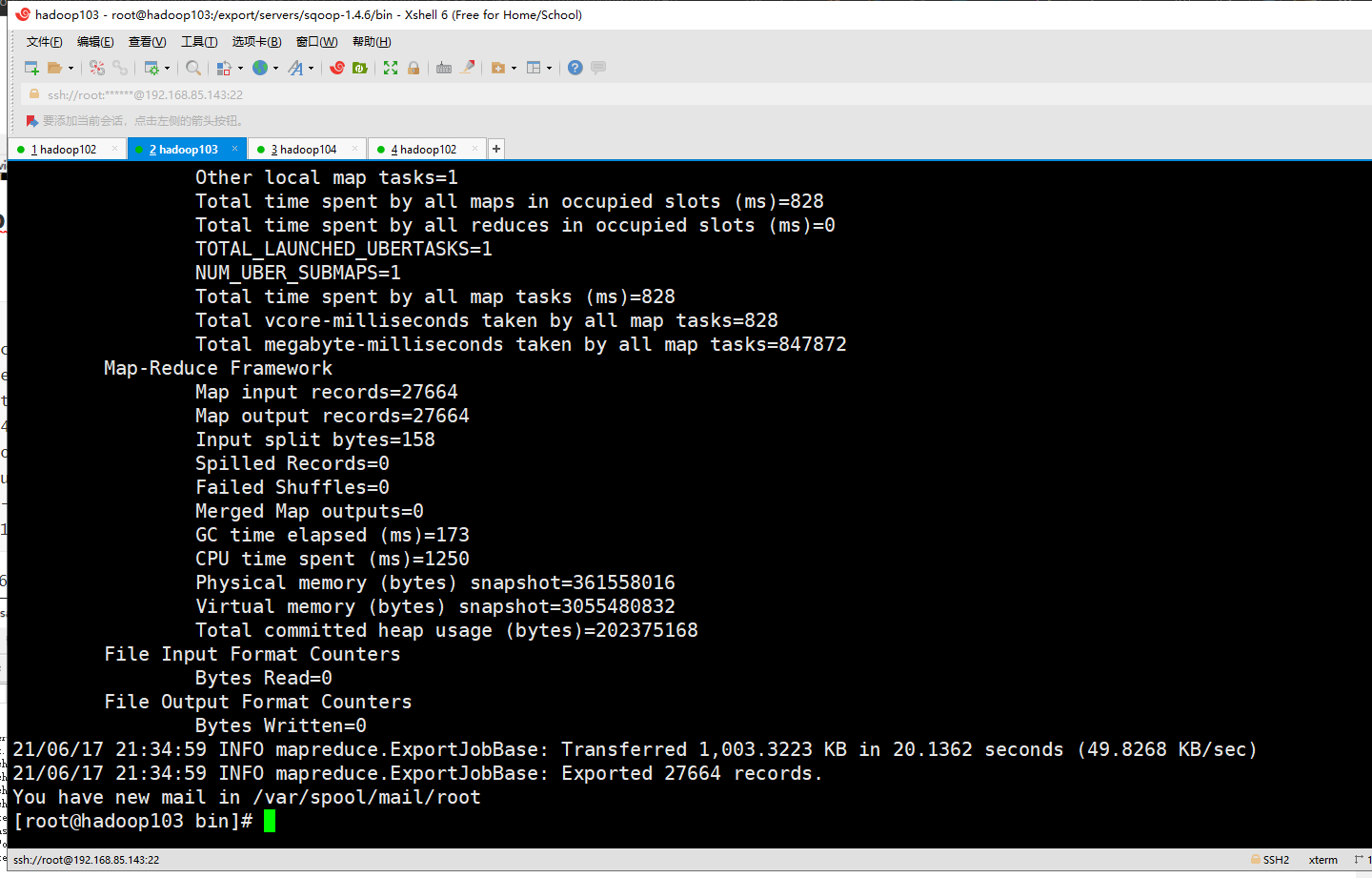

导出成功如下:

标签:sqoop mic 数据 img java tab sele 数据仓库 rmi

原文地址:https://www.cnblogs.com/destiny-2015/p/14897425.html