标签:

6 HDFS安装过程

1)解压安装包

root@master:/usr/local# tar -zxvf hadoop-2.4.0.tar.gz

如果不是使用root用户解压,建议使用chown修改文件夹属性(比如当前用户为xiaoming)

xiaoming@master:/usr/local# sudo chown -R xiaoming:xiaoming hadoop

如果集群是64位操作系统,需要替换lib/native文件夹,否则会出现警告提示

2)修改配置文件

主要涉及的配置文件有7个:

/usr/local/hadoop/etc/hadoop/hadoop-env.sh /usr/local/hadoop/etc/hadoop/yarn-env.sh /usr/local/hadoop/etc/hadoop/slaves /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hadoop/etc/hadoop/hdfs-site.xml /usr/local/hadoop/etc/hadoop/mapred-site.xml /usr/local/hadoop/etc/hadoop/yarn-site.xml

分两步安装,首先配置HDFS,然后配置YARN

配置HDFS需要修改文件包括hadoop-env.sh、slaves、core-site.xml和hdfs-site.xml

2.1)修改hadoop-env.sh

在文件底部添加

export JAVA_HOME=/usr/local/java/jdk1.7.0_79

2.2)修改slaves

slaves文件主要是设置从节点的名称

slave1

slave2

slave3

slave4

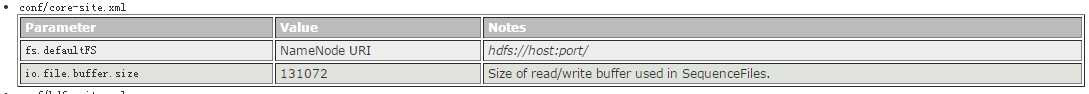

2.3)修改core-site.xml

参考官网文档在<Configuration></Configuration>中添加设置

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:8020</value>

<final>true</final>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

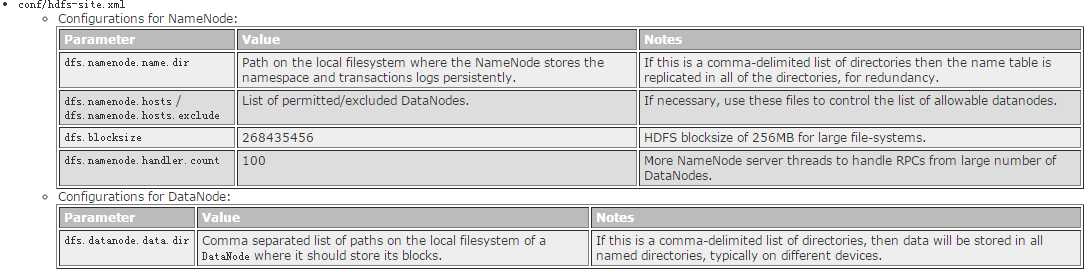

2.4)修改hdfs-site.xml

参考官网文档在<Configuration></Configuration>中添加设置

在NameNode中添加

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>67108864</value>

</property>

<property>

<name>dfs.namenode.handler.count</name>

<value>100</value>

</property>

<property>

<name>dfs.namenode.hosts</name>

<value>slave1,slave2,slave3,slave4</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>master:9001</value>

</property>

在DataNode中添加

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop/dfs/data</value>

</property>

2.5)格式化HDFS

root@master:/usr/local/hadoop# hdfs namenode -format

2.6)启动集群

可以通过~/sbin/start-dfs.sh启动集群,也可以通过hadoop-daemon.sh start datanode单独启动各个节点

root@master:/usr/local/hadoop# start-dfs.sh

NameNode上jps命令

root@master:/usr/local/hadoop/sbin# jps 4760 NameNode 5103 SecondaryNameNode 13518 Jps

DataNode上jps命令

root@slave1:/usr/local/hadoop/sbin# jps 7258 Jps 3042 DataNode

2.7)上传文件

新建两个文本文件

root@master:/usr/local/hadoop# echo "hello world" >> file1

root@master:/usr/local/hadoop# echo "hello hadoop" >> file2

上传到HDFS

root@master:/usr/local/hadoop# hdfs dfs -put file* /

显示文件信息

root@master:/usr/local/hadoop# hdfs dfs -ls / Found 2 items -rw-r--r-- 3 root supergroup 12 2016-06-02 20:02 /file1 -rw-r--r-- 3 root supergroup 13 2016-06-02 20:02 /file2

标签:

原文地址:http://www.cnblogs.com/lalaxiaoming/p/5554266.html