标签:apach 本地 hadoop imp div 3.2 pre 变量 tar.gz

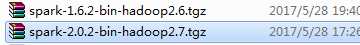

spark是基于hadoop运算的,两者有依赖关系,见下图:

前言:

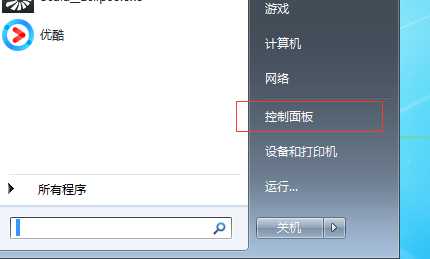

1.1 打开“控制面板”选项

1.2.找到“系统”选项卡

1.3.点击“高级系统设置”

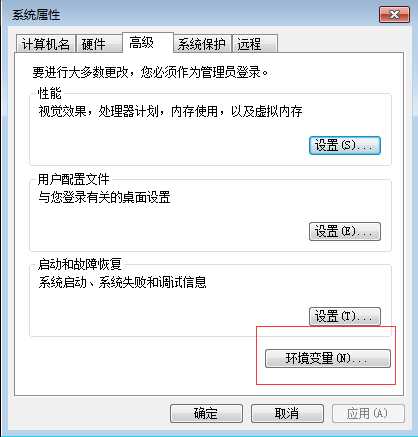

1.4.点击“环境变量”

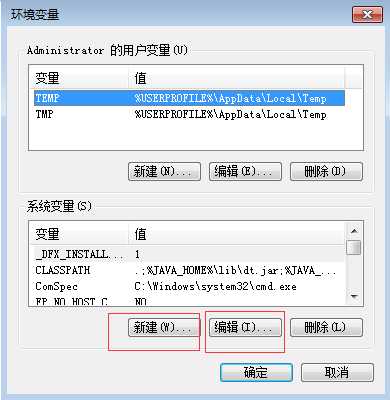

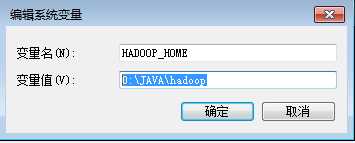

1.1 新建环境变量上配置

HADOOP_HOME

D:\JAVA\hadoop

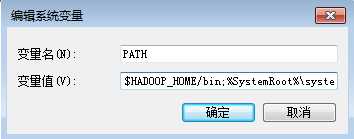

1.2 修改PATH路径

$HADOOP_HOME/bin;

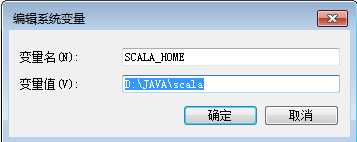

2.1 新建环境变量上配置

SCALA_HOME

D:\JAVA\scala

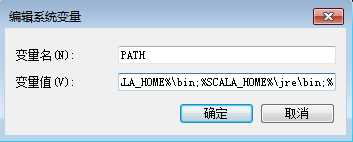

2.2 修改PATH路径

%SCALA_HOME%\bin;%SCALA_HOME%\jre\bin;

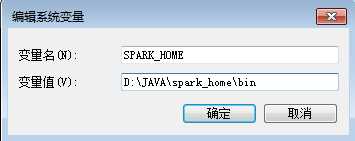

3.1 新建环境变量上配置

SPARK_HOME

D:\JAVA\spark_home\bin

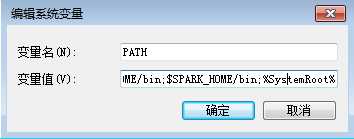

3.2 修改PATH路径

PATH

$SPARK_HOME/bin;

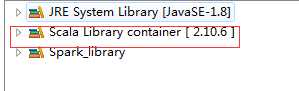

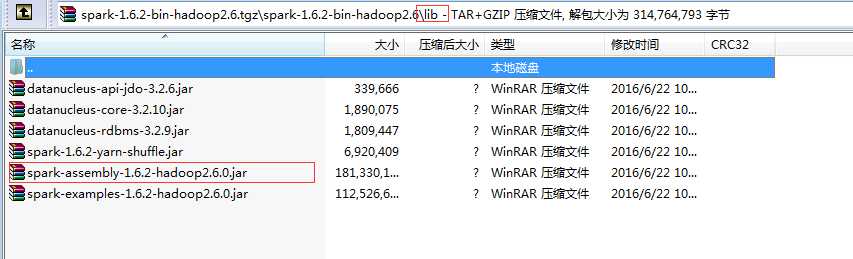

新建一个工程,修改library:

Scala library一定要是:2.10.X

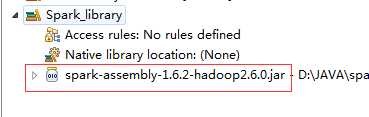

新建一个自己的library:添加一个Jar文件(${spark_home}/lib)

下跟Word Count代码

package com import org.apache.spark.SparkConf import org.apache.spark.api.java.JavaSparkContext import org.apache.spark.SparkContext /** * 统计字符出现次数 */ object WordCount { def main(args: Array[String]): Unit = { System.setProperty("hadoop.home.dir", "D:\\JAVA\\hadoop"); val sc = new SparkContext("local", "My App") val line = sc.textFile("/srv/1.txt") line.map((_, 1)).reduceByKey(_+_).collect().foreach(println) sc.stop() println(111111) } }

hadoop下载点击这里

spark下载点击这里

scala安装包,scala IDE下载点击这里

标签:apach 本地 hadoop imp div 3.2 pre 变量 tar.gz

原文地址:http://www.cnblogs.com/wuxiaolong4/p/6916962.html