标签:href pypi 长江 .com 适合 最大的 strong hmm 第三方

英文分词的第三方库NLTK不错,中文分词工具也有很多(盘古分词、Yaha分词、Jieba分词等)。但是从加载自定义字典、多线程、自动匹配新词等方面来看。

大jieba确实是中文分词中的战斗机。

请随意观看表演

py -3 -m pip install jieba / pip install jiba(windows下推荐第一种,可以分别安装python2和3对应jieba)

jieba.cut(sen)jieba.cut(sen,cut_all=True)jieba.cut_for_search(sen)import jieba

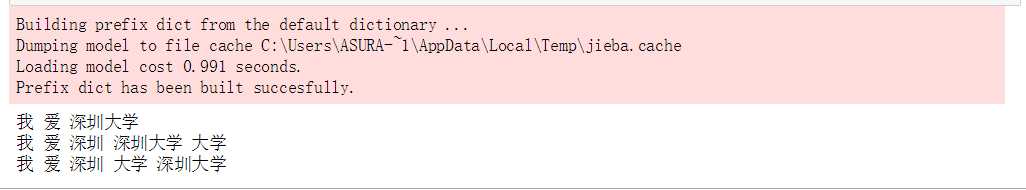

sen = "我爱深圳大学"

sen_list = jieba.cut(sen)

sen_list_all = jieba.cut(sen,cut_all=True)

sen_list_search = jieba.cut_for_search(sen)

for i in sen_list:

print(i,end=" ")

print()

for i in sen_list_all:

print(i,end=" ")

print()

for i in sen_list_search:

print(i,end=" ")

print()结果:附截图

jieba.load_userdict(txtFile)

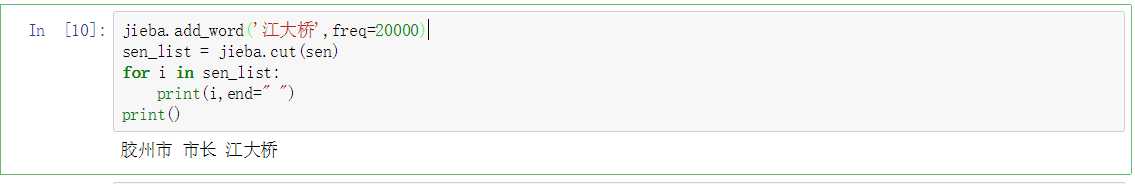

添加词:jieba.add_word(word,freq=None,tag=None)

删除词:jieba.del_word(word)

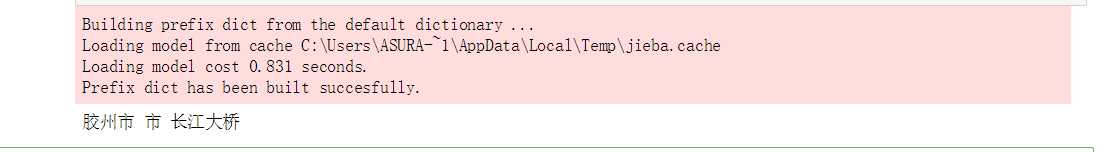

import jieba

sen = "胶州市市长江大桥"

sen_list = jieba.cut(sen)

for i in sen_list:

print(i,end=" ")

print()胶州市 市 长江大桥jieba.add_word(‘江大桥‘,freq=20000)

sen_list = jieba.cut(sen)

for i in sen_list:

print(i,end=" ")

print()结果附截图

jieba.set_dictionary(‘data/dict.txt.big‘)

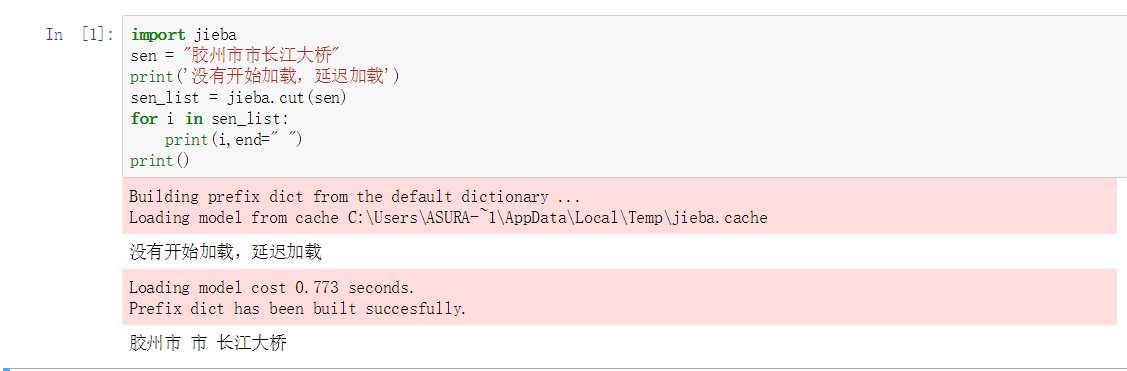

之前发现,词典不是一次性加载的,说明它采用的是延迟加载。即:当遇到应用的时候才会加载。有点类似于python高级特性中的

yield(节省内存)

效果图如下:

jieba.initialize()

jieba.analyse.extract_tags(sentence,topK=20):返回topK个TF/IDF权重最大的词语

import jieba.analyse

sen_ana = jieba.analyse.extract_tags(sen,3)

for i in sen_ana:

print(i)江大桥

胶州市

市长

jieba.posseg.cut(sen):返回的每个迭代对象有两个属性-> word 词语 + flag 词性

import jieba.posseg

words = jieba.posseg.cut(sen)

for word in words:

print(word.flag," ",word.word)ns 胶州市

n 市长

x 江大桥

jieba.tokenize(sen,mode):mode可以设置为search,开启搜索模式

index= jieba.tokenize(sen)

for i in index:

print(i[0],"from",i[1],"to",i[2])胶州市 from 0 to 3

市长 from 3 to 5

江大桥 from 5 to 8

标签:href pypi 长江 .com 适合 最大的 strong hmm 第三方

原文地址:http://www.cnblogs.com/zhangyubao/p/7003529.html