标签:app tab etc mode range arch int table source

1.结构化:

2.转换成pandas的数据结构DataFrame

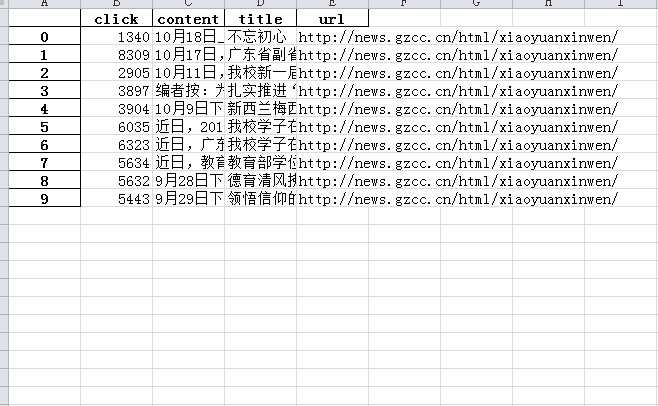

3.从DataFrame保存到excel

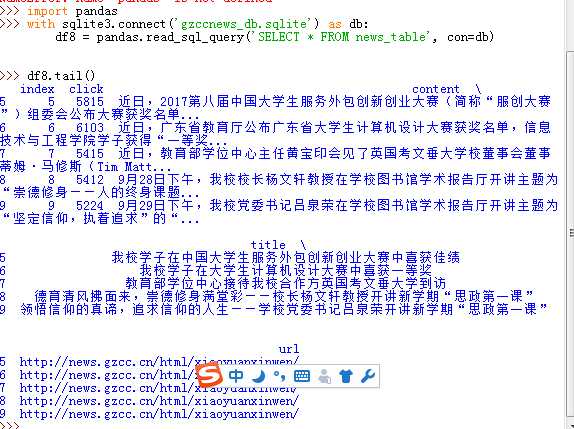

4.从DataFrame保存到sqlite3数据库

import requests import re import pandas from bs4 import BeautifulSoup import sqlite3 url = ‘http://news.gzcc.cn/html/xiaoyuanxinwen/‘ res = requests.get(url) res.encoding = ‘utf-8‘ soup = BeautifulSoup(res.text, ‘html.parser‘) def getclick(newurl): id = re.search(‘_(.*).html‘, newurl).group(1).split(‘/‘)[1] clickurl = ‘http://oa.gzcc.cn/api.php?op=count&id={}&modelid=80‘.format(id) click = int(requests.get(clickurl).text.split(".")[-1].lstrip("html(‘").rstrip("‘);")) return click def getdetail(listurl): res = requests.get(listurl) res.encoding = ‘utf-8‘ soup = BeautifulSoup(res.text, ‘html.parser‘) news={} news[‘url‘]=url news[‘title‘]=soup.select(‘.show-title‘)[0].text info = soup.select(‘.show-info‘)[0].text #news[‘dt‘]=datetime.strptime(info.lstrip(‘发布时间‘)[0:19],‘%Y-%m-%d %H:%M:‘) #news[‘source‘]=re.search(‘来源:(.*)点击‘,info).group(1).strip() news[‘content‘]=soup.select(‘.show-content‘)[0].text.strip() news[‘click‘]=getclick(listurl) return (news) def onepage(pageurl): res = requests.get(pageurl) res.encoding = ‘utf-8‘ soup = BeautifulSoup(res.text, ‘html.parser‘) newsls=[] for news in soup.select(‘li‘): if len(news.select(‘.news-list-title‘)) > 0: newsls.append(getdetail(news.select(‘a‘)[0][‘href‘])) return(newsls) newstotal=[] for i in range(2,3): listurl=‘http://news.gzcc.cn/html/xiaoyuanxinwen/‘ newstotal.extend(onepage(listurl)) df =pandas.DataFrame(newstotal) df.to_excel(‘gzccnews.xlsx‘) with sqlite3.connect(‘gzccnews_db.sqlite‘) as db: df.to_sql(‘news_table‘,con = db)

标签:app tab etc mode range arch int table source

原文地址:http://www.cnblogs.com/a939833950/p/7691462.html