集成学习实践部分也分成三块来讲解:

sklearn官方文档:http://scikit-learn.org/stable/modules/ensemble.html#ensemble

1、GBDT

2、XGBoost

3、Adaboost

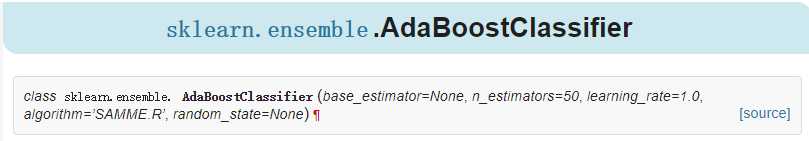

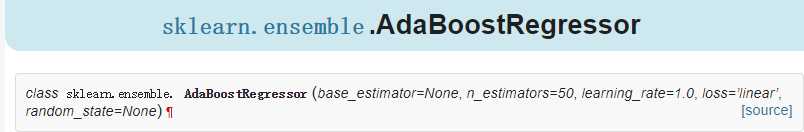

在sklearn中Adaboost库分成两个,分别是分类和回归AdaBoostClassifier和AdaBoostRegressor

对于集成学习我们参数部分也分成框架跟基学习器的参数两种

1、框架部分:

AdaBoostClassifier:http://scikit-learn.org/stable/modules/generated/sklearn.ensemble.AdaBoostClassifier.html#sklearn.ensemble.AdaBoostClassifier

AdaBoostRegressor:http://scikit-learn.org/stable/modules/generated/sklearn.ensemble.AdaBoostRegressor.html#sklearn.ensemble.AdaBoostRegressor

参数说明:

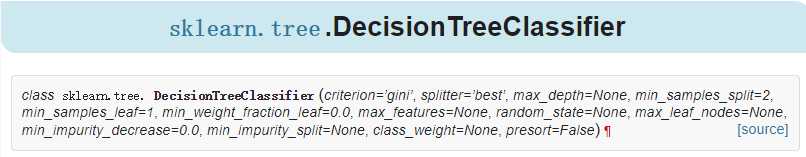

base_estimator:弱学习器是什么,default=DecisionTreeClassifier,

algorithm:这个参数只有AdaBoostClassifier有。主要原因是scikit-learn实现了两种Adaboost分类算法,SAMME和SAMME.R。两者的主要区别是弱学习器权重的度量,SAMME使用了和我们的原理篇里二元分类Adaboost算法的扩展,即用对样本集分类效果作为弱学习器权重,而SAMME.R使用了对样本集分类的预测概率大小来作为弱学习器权重。由于SAMME.R使用了概率度量的连续值,迭代一般比SAMME快,因此AdaBoostClassifier的默认算法algorithm的值也是SAMME.R。我们一般使用默认的SAMME.R就够了,但是要注意的是使用了SAMME.R, 则弱分类学习器参数base_estimator必须限制使用支持概率预测的分类器。SAMME算法则没有这个限制。

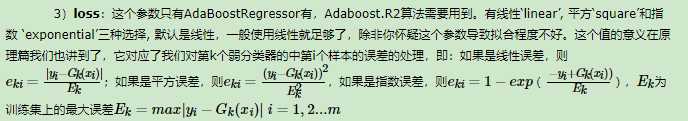

loss:只有AdaBoostRegressor有,代表使用的损失是那种损失

n_estimators:弱学习器个数

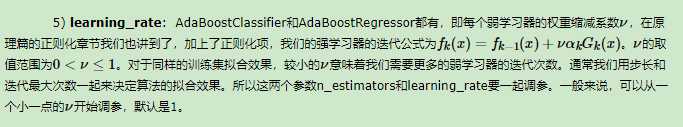

learning_rate:学习率,也就是我们前面理论部分有讲到正则化里面的参数

2、基学习器

基学习器可选的有很多种,这里举例CART树

与决策树的参数一样,可选择的有很多,更多参考决策树那篇

3、实战