标签:观察 .com 停止 png oca tail 优先 id3 方法

整理自:

https://blog.csdn.net/woaidapaopao/article/details/77806273?locationnum=9&fps=1

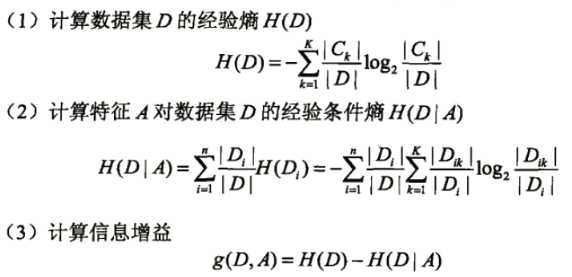

1.各种熵的计算

熵、联合熵、条件熵、交叉熵、KL散度(相对熵)

2.常用的树搭建方法

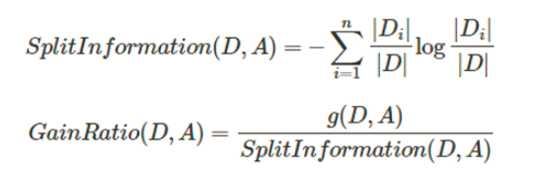

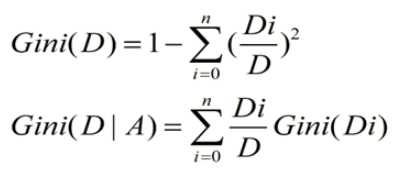

ID3、C4.5、CART分别利用信息增益、信息增益率、Gini指数作为数据分割标准。

3.防止过拟合—剪枝

剪枝分为前剪枝和后剪枝,前剪枝本质就是早停止,后剪枝通常是通过衡量剪枝后损失函数变化来决定是否剪枝。后剪枝有:错误率降低剪枝、悲观剪枝、代价复杂度剪枝

4.前剪枝的几种停止条件

标签:观察 .com 停止 png oca tail 优先 id3 方法

原文地址:https://www.cnblogs.com/helloworld0604/p/9015704.html