标签:height 如何 集中 ati 抽样 .com 顺序 ack 并行

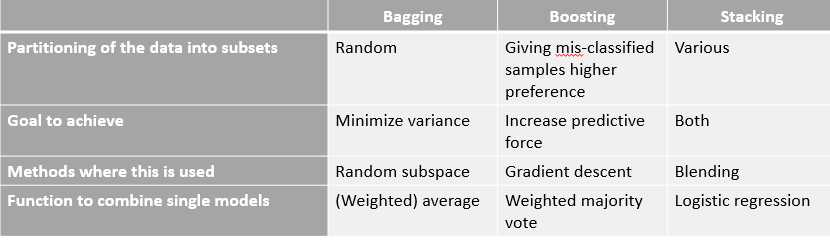

本文主要总结Bagging 和 Boosting 和 Stacking思想的异同点。这三种算法都可以称作为“meta-algorithms”,就是将多个机器学习方法集成到一个模型里面去降低方差,偏差,或者改善模型预测能力。通常bagging可以降低variance,boosting可以降低bias,stacking可以改善模型预测能力。

这三种算法都包含以下两个步骤:

在多分类问题当中,常用到两大类的方法:Ensemble methods 和 Hybrid methods。Ensemble methods:主要是指将多个相同的学习模型集成到一起。最常见的方法里面有Bagging 和 Boosting,它们可以使弱分类器组成强分类器。Hybrid methods:主要是指将不同的学习模型集成到一起组成一个新的学习模型。最常见的方法里面有Stacking (or stacked generation)

下面着重总结bagging 和 boosting 的异同点。

1.Bagging (booststrap aggregating)

具体算法过程如下:

a> 先从原始样本集中抽取训练集。有放回的抽样n个训练样本,其中某些样本可能被多次抽到,而有些样本也可能一次没有抽到。共进行k轮抽取,得到k个训练集。(大约有1/3不会被抽到)

b>每次使用一个训练集得到一个模型,k个训练集共得到k个模型。

c>对于分类模型:最后结果采取k个模型投票的方式得到分类结果;对于回归问题:计算上述模型的均值得到最好的结果。(所有模型的重要性相同)

>>bagging只是通过增大训练集合的个数来降低预测的方差。(仅仅改变训练数据,不改变模型)

2.Boosting

最主要的思想是将弱分类器组装成一个强分类器,在PCA(概率近似正确)框架下,则一定可以将弱分类器组成一个强分类器。

boosting两个核心问题:

a>在每一轮如何改变训练数据的权值或概率分布?

boosting中每个模型的更新都是和上一个模型相关的。通过提高那些在前一轮被弱分类器分错样例的权值,来使分类器对误分的数据有较好的效果。

b>通过什么方式来组合弱分类器?

通过加法模型使弱分类器线性组合。增大错误率小的分类器的权值,同时减小错误率较大的分类器的权值。

>>每一个新的训练子集合包含着上一个模型误分类的数据。

Stacking:

stacking类似于boosting。

3.Bagging 和 Boosting二者之间的区别

a>在样本选择上:

Bagging:训练集是在原始集中有放回的选取,从原始数据集中选出的各轮训练集之间是相互独立的。

Boosting:每一轮的训练集不变,只是训练集中每个样例在分类器中的权值发生变化。而权值是根据上一轮的分类结果进行调整。

b>样例权重:

Bagging:使用均匀抽样,每个样例的权重相等。

Boosting:根据错误率不断调整样例的权值,错误率越大则权重越大。

c>预测函数:

Bagging:所以预测函数的权重相等。

Boosting:每个弱分类器都有相应的权重,对于分类误差小的分类器会有更大的权重。

d>并行计算:

Bagging:各预测函数可以并行生成。

Boosting:各个预测函数只能顺序生成,因为后一个模型参数需要前一轮模型的结果。

e>作用和目标:

Bagging:目标是降低variance,而不是bias。适合高方差低偏差模型,也就是复杂模型。

Boosting:目标是降低bias,而不是variacne,适合低方差高偏差模型。

4.总结

Bagging 和Boosting 方法都是将多个分类器集成到一个分类器,只是集成的方法不一样。最后集成模型提高了单一分类器的效果,同时增大了计算量。

常用的算法组合:

Bagging +决策树=随机森林

AdaBoost+决策树=提升树

Gradient Boosting+决策树=GBDT

5.reference

1. http://www.cnblogs.com/liuwu265/p/4690486.html

2.https://stats.stackexchange.com/questions/18891/bagging-boosting-and-stacking-in-machine-learning

3.https://people.cs.pitt.edu/~milos/courses/cs2750-Spring04/lectures/class23.pdf

4.http://quantdare.com/dream-team-combining-classifiers-2/

5.https://quantdare.com/what-is-the-difference-between-bagging-and-boosting/

标签:height 如何 集中 ati 抽样 .com 顺序 ack 并行

原文地址:https://www.cnblogs.com/makino/p/9670216.html