标签:训练 alt 输入 style 误差 img 效果 ima 特征

一、流程

基函数线性加权和得到最终的强分类器。每轮迭代得到一个弱分类器,这个分类器是在上一轮的残差基础上得到的。本轮就是要找一个cart树,使得本轮的损失函数值更加的小。

二、如何选择特征(就是如何生成cart树)

回归树:平方误差和最小化,对于特征A=a时,集合D的误差最小时,就选择这个特征值最为切分点。

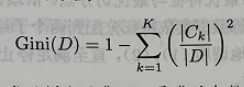

分类树:使用基尼系数,计算对于特征A=a时,集合D的基尼指数最小时,就选择这个特征最为切分点。

三、如何构建特征?

GBDT本身不能产生特征的,产生的是特征的组合。

例如用gbdt生成两颗子树(cart回归树),一共5个叶子节点,那么将一个样本放入到这两个子树中,肯定会在这两个子树的某一个叶子节点输出,最后有两个输出。令输出的叶子节点为1,否则为0,那么组成的向量就是[0,1,1,0,0],这就是特征的组合后的向量,再将这个和原来的特征一起输入的逻辑回归函数中进行训练,最后的效果得到了提升,而不用全都是人工设定的特征了。

四、损失函数拟合?

用损失函数的负梯度去拟合本轮损失值(残差)的近似值,进而去拟合一颗cart回归树

标签:训练 alt 输入 style 误差 img 效果 ima 特征

原文地址:https://www.cnblogs.com/pacino12134/p/11337014.html