标签:this 死机 oss 使用方法 var 很多 运维监控 三方 智能运维

随着大数据时代的来临,运维工作的难度越来越大,每个运维人员都要面临不计其数的服务器和海量的数据,如何保证众多服务器和业务系统稳定高效地运行并尽量减少死机时间,成为考核运维工作的重要指标,而要实现大规模的运维,必须要有一套行之有效的智能运维监控管理系统,本章就详细介绍下如何构建一套完善的运维监控报警平台。

运维的核心工作可以分为运行监控和故障处理两个方面,对业务系统进行精确、完善的监控,保证能够在第一时间发现故障并迅速通知运维人员处理故障是运维监控系统要实现的基础功能;一个功能完善的智能监控系统,不但可以自动处理一些简单故障,减少运维工作量,还应该在应用可能出现故障时预先发出报警,预防故障的发生。因此,构建一个智能的运维监控平台,必须以运行监控和故障报警这两个方面为重点,将所有业务系统中涉及的网络资源、硬件资源、软件资源、数据库资源等纳入统一的运维监控平台中,并通过消除管理软件的差别,数据采集手段的差别,对各种不同的数据来源实现统一管理、统一规范、统一处理、统一展现、统一用户登录、统一权限控制,最终实现运维规范化、自动化、智能化的大运维管理。

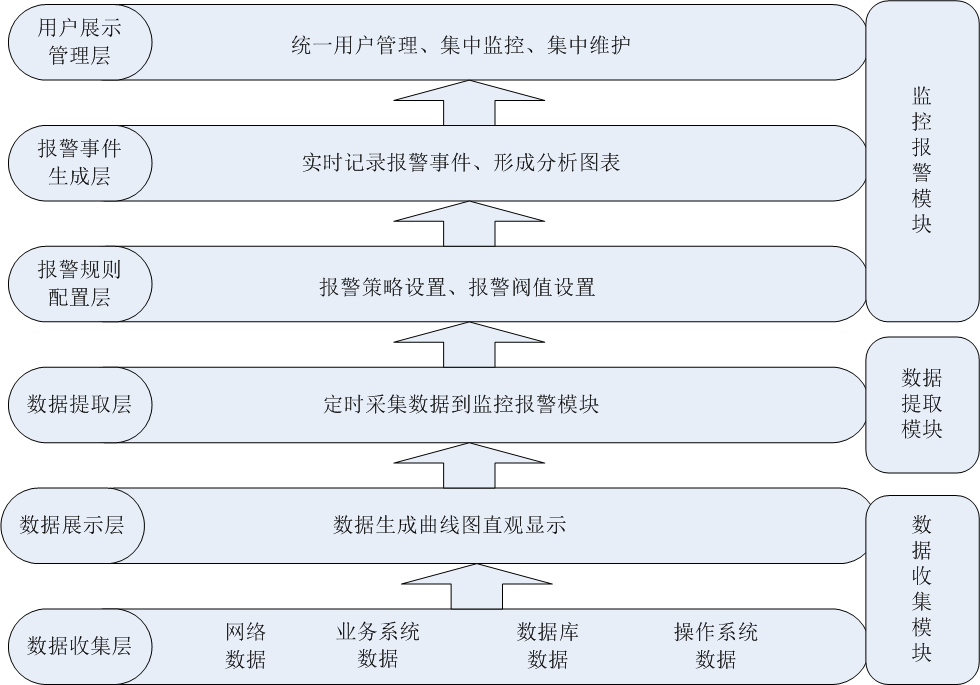

一个智能的运维监控平台,一般的设计架构从低到高可以分为6层,三大模块,如下图所示。

其中:

? 数据收集层:位于最底层,主要收集网络数据、业务系统数据、数据库数据、操作系统数据等,然后将收集到的数据进行规范化并进行存储。

? 数据展示层:位于第二层,是一个Web展示界面,主要是将数据收集层获取到的数据进行统一展示,展示的方式可以是曲线图、柱状图、饼状态等,通过将数据图形化,可以帮助运维人员了解一段时间内主机或网络的运行状态和运行趋势,并作为运维人员排查问题或解决问题的依据。

? 数据提取层:位于第三层,主要是对从数据收集层获取到的数据进行规格化和过滤处理,提取需要的数据到监控报警模块,这个部分是监控和报警两个模块的衔接点。

? 报警规则配置层:位于第四层,主要是根据第三层获取到的数据进行报警规则设置、报警阀值设置、报警联系人设置和报警方式设置等。

? 报警事件生成层:位于第五层,主要是对报警事件进行实时记录,将报警结果存入数据库以备调用,并将报警结果形成分析报表,以统计一段时间内的故障率和故障发生趋势。

? 用户展示管理层:位于最顶层,是一个Web展示界面,主要是将监控统计结果、报警故障结果进行统一展示,并实现多用户、多权限管理,实现统一用户和统一权限控制。

在这6层中,从功能实现划分,又分为三个模块,分别是数据收集模块、数据提取模块和监控报警模块,每个模块完成的功能如下:

? 数据收集模块:此模块主要完成基础数据的收集与图形展示。数据收集的方式有很多种,可以通过SNMP实现,也可以通过代理模块实现,还可以通过自定义脚本实现。常用的数据收集工具有Cacti、Ganglia等。

? 数据提取模块:此模板主要完成数据的筛选过滤和采集,将需要的数据从数据收集模块提取到监控报警模块中。可以通过数据收集模块提供的接口或自定义脚本实现数据的提取。

? 监控报警模块:此模块主要完成监控脚本的设置、报警规则设置,报警阀值设置、报警联系人设置等,并将报警结果进行集中展现和历史记录。常见的监控报警工具有Nagios、Centreon等。

在了解了运维监控平台的一般设计思路之后,接下来详细介绍下如何通过软件实现这样一个智能运维监控系统。

上图是根据上图的设计思路形成的一个运维监控平台实现拓扑图,从图中可以看出,主要有三大部分组成,分别是数据收集模块、监控报警模块和数据提取模块,其中,数据提取模块用于其他两个模块之间的数据通信,而数据收集模块可以有一台或多台数据收集服务器组成,每个数据收集服务器可以直接从服务器群组收集各种数据指标,经过规范数据格式,最终将数据存储到数据收集服务器中。监控报警模块通过数据抽取模块从数据收集服务器获取需要的数据,然后设置报警阀值、报警联系人等,最终实现实时报警。报警方式支持手机短信报警、邮件报警等,另外,也可以通过插件或者自定义脚本来扩展报警方式。这样一整套监控报警平台就基本实现了。

关于Ganglia的基本应用,在前面章节已经详细介绍过,这里将Ganglia作为监控报警平台的数据收集模块,主要基于以下几方面的原因:

1、灵活的分布式、分层体系结构,使Ganglia支持上万个监控节点的数据收集,并且性能表现稳定,同时,Ganglia也可以根据地域环境、网络结构的不同,分地域、分层次灵活部署Ganglia数据收集点,而对于数据收集节点可以动态添加或删除,对Ganglia整体监控不产生任何影响,因此,可以灵活扩展Ganglia数据收集节点。

2、收集数据更加精确,不但可以收集实时数据,以图表的形式展示出来,而且还允许用户查看历史统计数据,因此,用户可以通过这些数据,做出性能调整、升级、扩容等决策,从而保证应用系统能够满足不断增长的业务需求。

3、可以通过组播、单播的方式收集数据。在监控的节点较多时通过组播方式收集数据可以大大降低数据收集的负载,提高监控和数据收集性能。而对于不能使用组播收集数据的网络环境,还可以通过单播的方式收集数据,因此Ganglia在数据收集方式上非常灵活。

4、可收集各种度量的数据。Ganglia默认可收集cpu、memory、disk、I/O、process、network六大方面的数据,同时还提供了C或者Python接口,用户通过这个接口可以自定义数据收集模块,并且这些模块可以被直接插入到Ganglia中以监控用户自定义的应用。

基于以上这些优点,Ganglia非常适合作为监控报警平台的数据收集模块。虽然Cacti也可以实现数据的收集和图形报表的展示,但是当监控节点越来越多时,Cacti的缺点就慢慢暴露出来了,数据收集的准确性、实时性就很难得到保障了。因此,要构建一个高性能的监控报警平台,Ganglia是首选的数据收集模块。

有了Ganglia收集数据还是不够的,运维人员不可能天天盯着数据报表,因此,还需要对收集到的数据进行监控和报警:对每个需要监控的主机或服务,设置一个报警阀值,当收集到的数据超过这个阀值时,在第一时间能自动报警并通知运维人员,而在收集到的数据没有超过指定的报警阀值时,运维人员就可以去做别的事情,而不用时刻盯着数据报表,这是构建智能监控报警平台必须要实现的一个功能。

对主机或服务的状态值进行监控,当达到指定阀值时进行报警,要实现这个功能并不是什么难的事情,写个简单的脚本就能实现,但是这样太原始了,没有层次,维护性差,并且当需要监控报警的主机或服务越来越多时,脚本的性能就变得很差,管理也非常不方便,更别说有什么可视化效果了,因此,需要有一个专业的监控报警工具来实现这个功能。

Centreon就是这样一个专业的分布式监控、报警工具,它通过第三方组件可以实现对网络、操作系统和应用程序的监控与报警。在底层,Centreon通过nagios作为监控软件;在数据层,Centreon通过ndoutil模块将监控到的数据定时写入数据库中;在展示层,Centreon提供了Web界面来配置、管理需要监控的主机或服务,并提供多种报警通知方式,同时还可以展现监控数据和报警状态,并且可查询历史报警记录。

关于Centreon的介绍和使用,在前面专栏已经做过非常详细的介绍,这里不再多说。通过对Centreon的使用可知,Centreon无论在配置、管理、可视化等方面都做得非常专业和完善,并且在多主机、多服务监控的环境下,性能表现也非常稳定,因此,将Centreon作为智能监控报警平台的监控报警模块非常适合。

通过前面的介绍,确定了以Ganglia作为数据收集模块,Centreon作为监控报警模块的方案,这样,一个智能监控报警平台两大主要功能模块已经基本实现了。但现在的问题是,如何将收集到的数据传送给监控报警模块呢,这就是数据抽取模块要完成的功能。

数据抽取模块要完成的功能是:从数据收集模块中定时采集指定的数据,然后将采集到的数据与指定的报警阀值进行比较,如果发现采集到的数据大于或小于指定的报警阀值,那么就通过监控报警模块设置的报警方式进行故障通知。在这个过程中,只有采集数据在数据收集模块中完成,其他操作,例如:采集数据时间间隔、报警阀值设置、报警方式设置、报警联系人设置等都在监控报警模块中完成。

从数据抽取模块完成的功能可以看出,此模块主要用来衔接数据收集模块和监控报警模块,进而实现Ganglia和Centreon的无缝整合。要实现数据抽取模块的功能,方法有很多,最简单最直接的方法就是编写监控脚本,这里提供几个常用的数据抽取脚本,然后将脚本添加到Centreon中,下面介绍具体的操作过程。

这里提供一个数据抽取脚本,是基于Python编写的,介绍如下。

这个脚本的原理是通过Ganglia提供的数据汇总端口来获取数据,然后将获取到的数据与指定的阀值进行对比,以判断服务是否有异常。脚本内容如下:

#!/usr/bin/env python

import sys

import getopt

import socket

import xml.parsers.expat

class GParser:

def __init__(self, host, metric):

self.inhost =0

self.inmetric = 0

self.value = None

self.host = host

self.metric = metric

def parse(self, file):

p = xml.parsers.expat.ParserCreate()

p.StartElementHandler = parser.start_element

p.EndElementHandler = parser.end_element

p.ParseFile(file)

if self.value == None:

raise Exception(‘Host/value not found‘)

return float(self.value)

def start_element(self, name, attrs):

if name == "HOST":

if attrs["NAME"]==self.host:

self.inhost=1

elif self.inhost==1 and name == "METRIC" and attrs["NAME"]==self.metric:

self.value=attrs["VAL"]

def end_element(self, name):

if name == "HOST" and self.inhost==1:

self.inhost=0

def usage():

print """Usage: check_ganglia_metric -h|--host= -m|--metric= -w|--warning= -c|--critical= """

sys.exit(3)

if __name__ == "__main__":

##############################################################

ganglia_host = ‘127.0.0.1‘

ganglia_port = 8651

host = None

metric = None

warning = None

critical = None

try:

options, args = getopt.getopt(sys.argv[1:],

"h:m:w:c:s:p:",

["host=", "metric=", "warning=", "critical=", "server=", "port="],

)

except getopt.GetoptError, err:

print "check_gmond:", str(err)

usage()

sys.exit(3)

for o, a in options:

if o in ("-h", "--host"):

host = a

elif o in ("-m", "--metric"):

metric = a

elif o in ("-w", "--warning"):

warning = float(a)

elif o in ("-c", "--critical"):

critical = float(a)

elif o in ("-p", "--port"):

ganglia_port = int(a)

elif o in ("-s", "--server"):

ganglia_host = a

if critical == None or warning == None or metric == None or host == None:

usage()

sys.exit(