标签:pen 组合 文件 lin red join() 去重 xss 一个

首先得知道SRC厂商的关键字,利用脚本搜集一波。

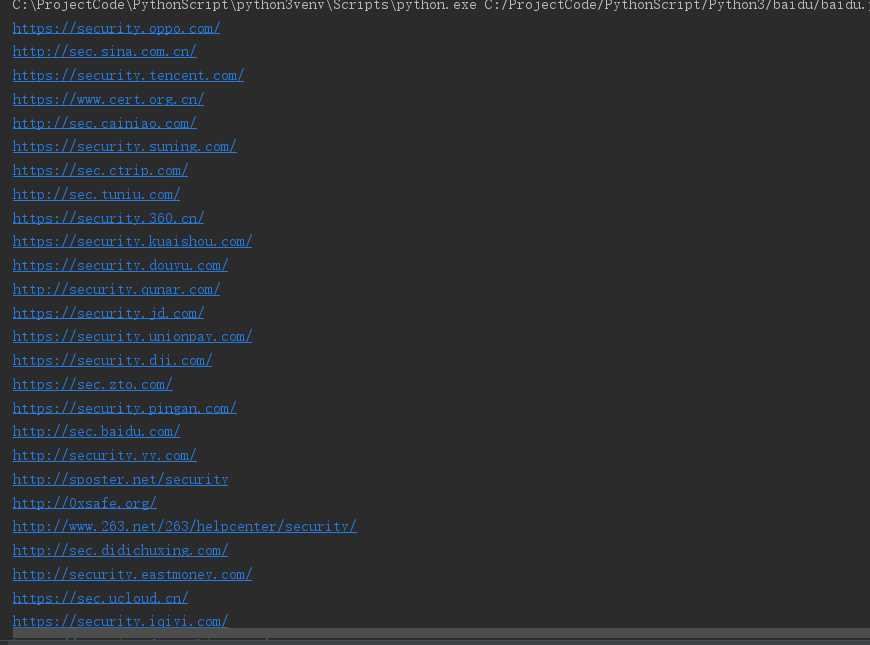

比如【应急响应中心】就可以作为一个关键字。通过搜索引擎搜索一波,去重,入库。

# -*- coding:utf-8 -*-

'''

从百度把前10页的搜索到的url爬取保存

'''

import multiprocessing # 利用pool进程池实现多进程并行

# from threading import Thread 多线程

import time

from bs4 import BeautifulSoup # 处理抓到的页面

import sys

import requests

import importlib

importlib.reload(sys) # 编码转换,python3默认utf-8,一般不用加

from urllib import request

import urllib

'''

all = open('D:\\111\\test.txt', 'a')

all.seek(0) #文件标记到初始位置

all.truncate() #清空文件

'''

headers = {

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Encoding': 'gzip, deflate, compress',

'Accept-Language': 'en-us;q=0.5,en;q=0.3',

'Cache-Control': 'max-age=0',

'Connection': 'keep-alive',

'User-Agent': 'Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:22.0) Gecko/20100101 Firefox/22.0'

} # 定义头文件,伪装成浏览器

def getfromBaidu(word):

start = time.process_time()

url = 'http://www.baidu.com.cn/s?wd=' + urllib.parse.quote(word) + '&pn=' # word为关键词,pn是百度用来分页的..

pool = multiprocessing.Pool(multiprocessing.cpu_count())

for k in range(1, 100):

result = pool.apply_async(geturl, (url, k)) # 多进程

pool.close()

pool.join()

print(time.process_time() - start)

def geturl(url, k):

path = url + str((k - 1) * 10)

response = request.urlopen(path)

page = response.read()

soup = BeautifulSoup(page, 'lxml')

tagh3 = soup.find_all('h3')

for h3 in tagh3:

href = h3.find('a').get('href')

# print(href)

baidu_url = requests.get(url=href, headers=headers, allow_redirects=False)

real_url = baidu_url.headers['Location'] # 得到网页原始地址

if real_url.startswith('http'):

print(real_url)

#urls.insert({"url": real_url})

# all.write(real_url + '\n')

if __name__ == '__main__':

getfromBaidu('应急响应中心')

微信公众号、xxsrc微信群。主要关注双倍积分活动、奖励大小、技术交流群里的信息。

在公开了漏洞标题的平台找最近活跃的漏洞类型是什么,然后找相关的实例学习。

通过某些公开了的漏洞标题找到业务系统,然后找同类型业务系统测试

不同的应急响应中心对业务漏洞的关注度不同,多提交才能知道哪些漏洞是能够高危的

1.不通过是因为写的不够详细,审核复现太麻烦,没有url,

2.教育和政府类发现xss不收,高危漏洞类型收的快

3.getshell评分高1.代码审计白盒挖掘传统漏洞

2.传统漏洞比较少(更多是业务逻辑,越权,资源耗尽导致的拒绝服务,多个漏洞的组合拳(xss+csrf))

3.需要更深层的资产搜集(比如阿里18周年,app搜集)

4.跟踪最新业务(京东618之前,上线了京东保租业务,近期上线了京东房产)

5大数据分析(采集白帽子们提交的漏洞标题,分析挖洞行为)

6.业务和漏洞威胁情报

7.app漏洞挖掘

8.c/s架构漏洞挖掘/lot设备漏洞挖掘

9.hacker0ne公开的漏洞姿势学习和twitter上的分享

标签:pen 组合 文件 lin red join() 去重 xss 一个

原文地址:https://www.cnblogs.com/17bdw/p/11816373.html