标签:大小 sid 图片 经典 因此 code 问题 应用 过滤

1、经典网络:

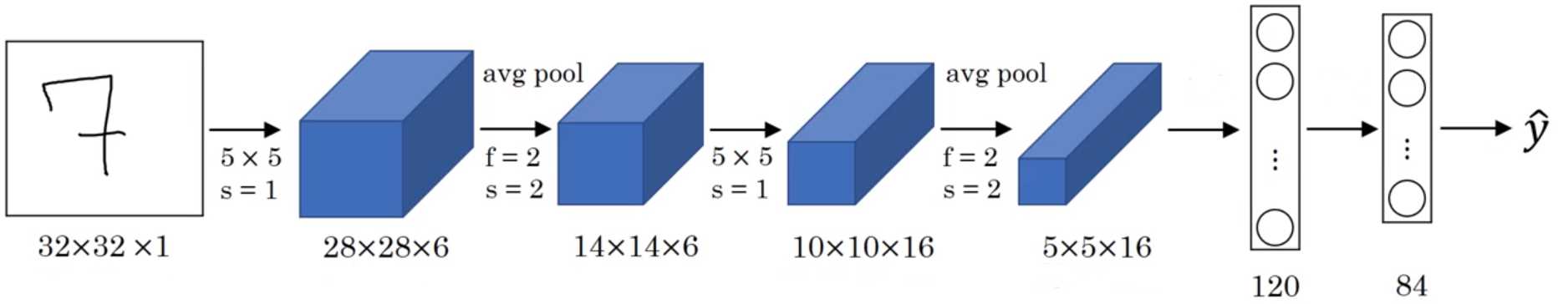

(1)LeNet-5:识别手写数字

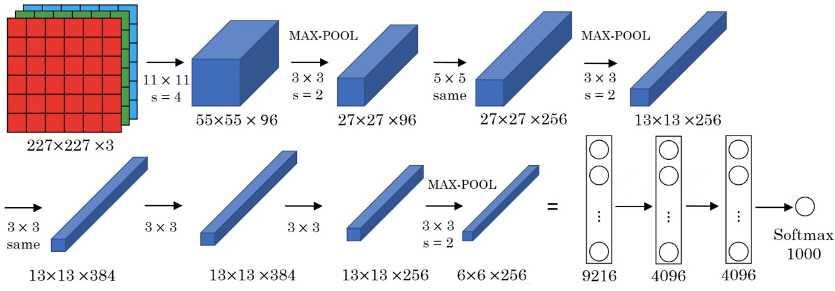

(2)AlexNet:

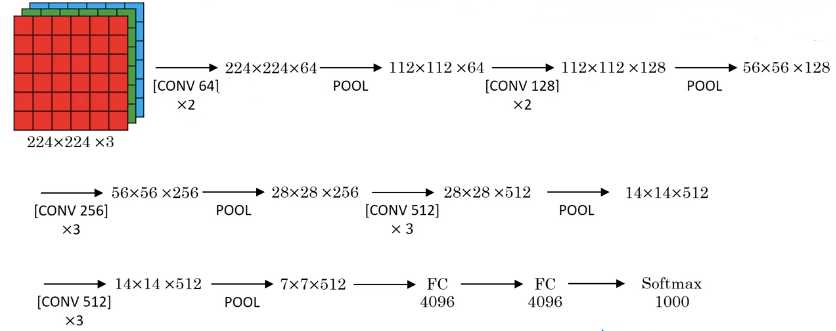

(3)VGG-16:

![]()

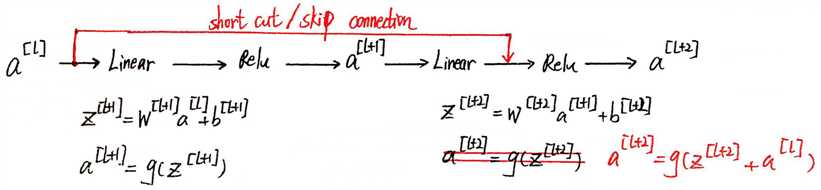

2、Residual networks(ResNets 残差网络):

(1)Residual block(残差块):

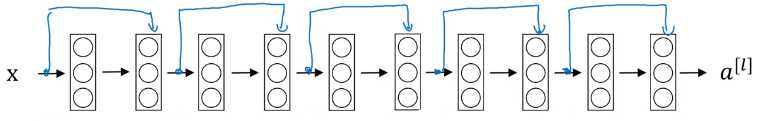

多个残差块构成一个残差网络:

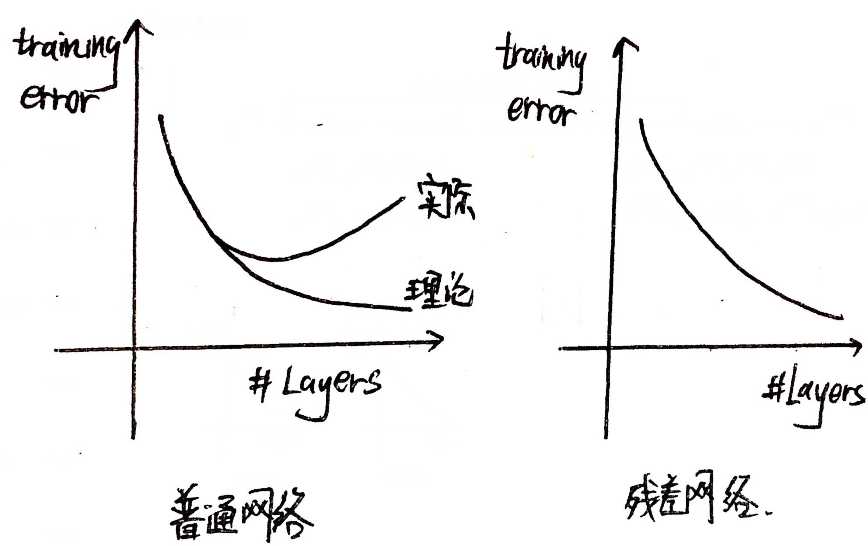

(2)残差网络的优势:

理论上,随着神经网络的深入,训练误差会越来越小,但实际上,层数越多训练的难度越大,因此层数过多误差也会增大. 但残差网络适用于深层的神经网络,误差随着层数的增多而减小.

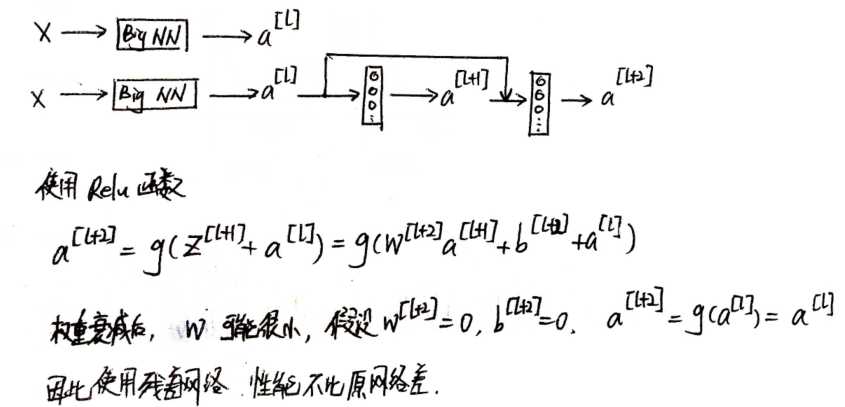

(3)为什么残差网络性能更好?

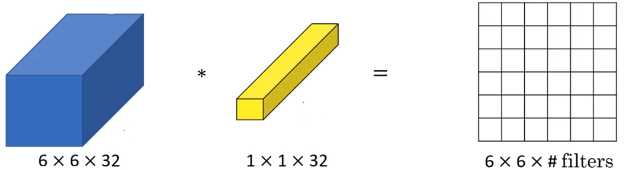

3、网络中的网络和1*1卷积:

(1)作用:

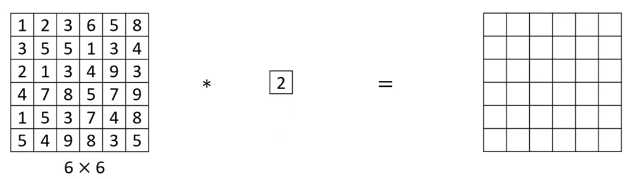

对于二维效果不佳,仅仅是矩阵乘数字:

对于三维,实现了多个通道乘积再求和的功能:

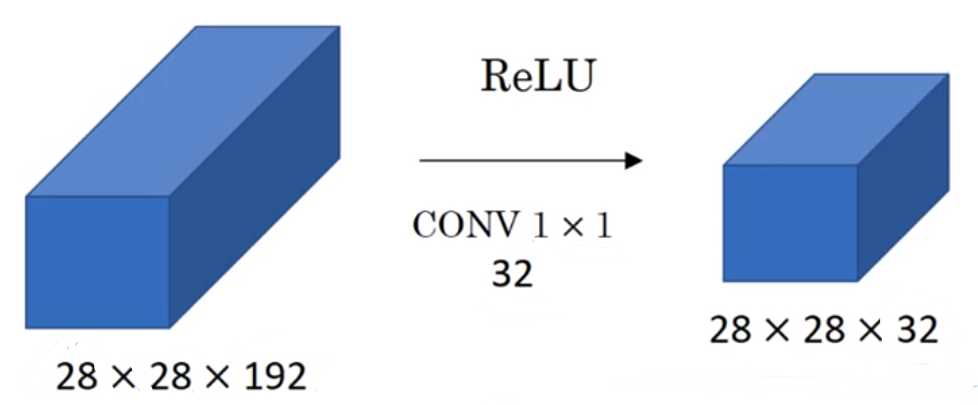

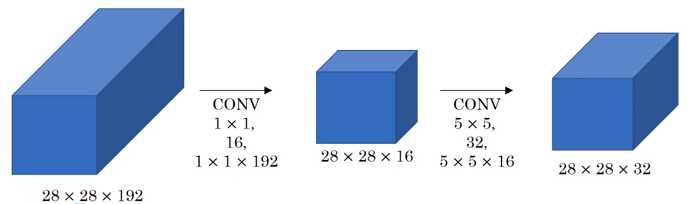

(2)应用:压缩 nC

使用32个1*1卷积,将192通道压缩为32通道.

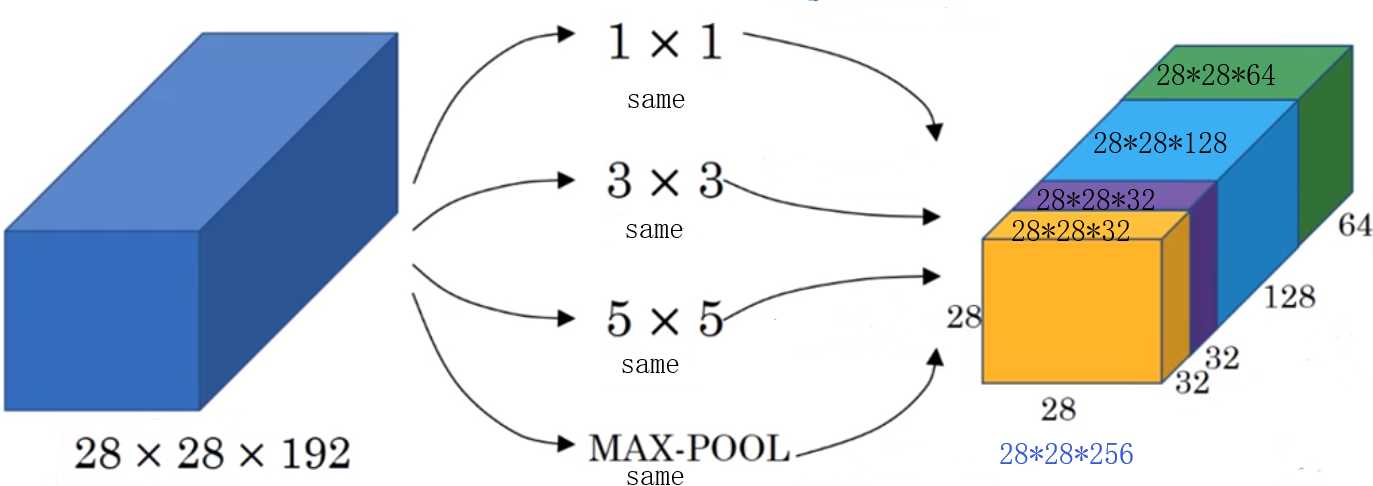

4、Inception网络:

(1)作用:决定过滤器的大小.

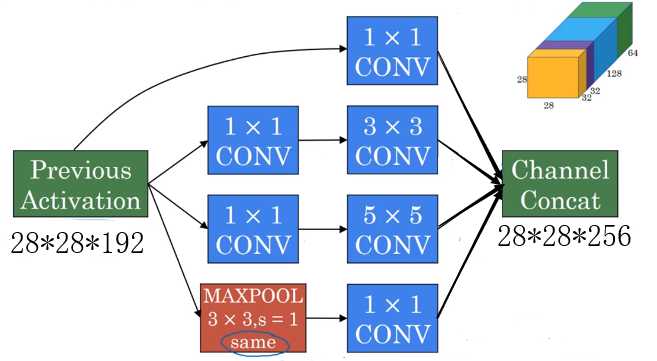

(2)Inception块:

将各个可能使用的过滤器合并,让系统自行学习并选择合适的过滤器.

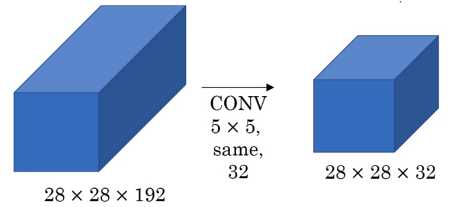

以28*28*32块为例,说明 computational cost 问题:

乘法计算次数:28*28*32*5*5*192 ≈ 120 Million

而使用了1*1卷积压缩后:中间的层成为“bottleneck layer”,即瓶颈层.

乘法计算次数:2*28*16*192 + 28*28*32*5*5*16 ≈ 2.4 Million + 10.0 Million = 12.4 Million

(3)Inception模块:

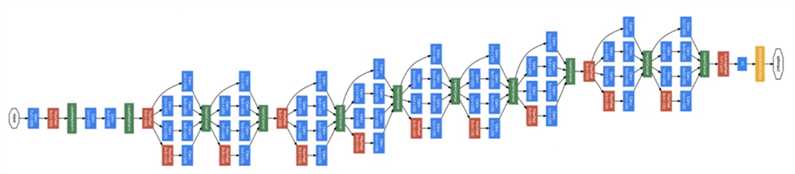

组成Inception网络:

标签:大小 sid 图片 经典 因此 code 问题 应用 过滤

原文地址:https://www.cnblogs.com/orangecyh/p/11868402.html