标签:mic 并且 image 参考 alpha http src mat blog

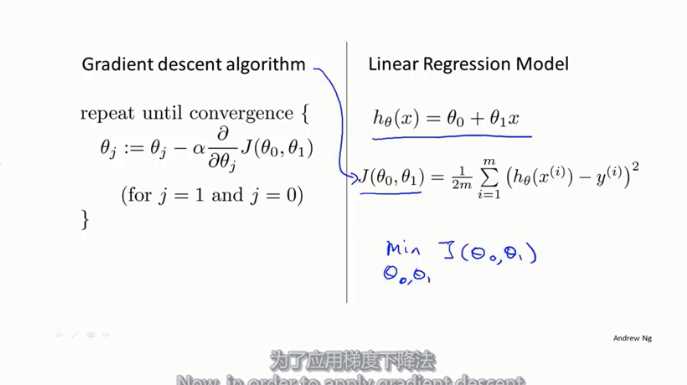

**机器学习的过程说白了就是让我们编写一个函数使得costfunction最小,并且此时的参数值就是最佳参数值。

定义

假设存在一个代价函数

fun:\(J\left(\theta_{0}, \theta_{1}\right)\)

通过不断地调整\(\theta_{0}\)和\(\theta_{1}\)是函数\(J\left(\theta_{0}, \theta_{1}\right)\)取得最小值

梯度下降就是使J不断通过导数下降的一种算法

\(\theta_{j}:=\theta_{j}-\alpha \frac{\partial}{\partial \theta_{j}} J\left(\theta_{0}, \theta_{1}\right)\)

\(a\)是学习率,也就是梯度下降的效率

给出梯度下降的参数更新公式,\(\theta_0\)和\(\theta_1\)要同时更新

说白了就是将梯度下降算法应用到代价函数中,求使代价函数最小的\(\theta_0\)和\(\theta_1\),这个就是多元微积分里面的求偏导数,因为是两个未知数,同时求两个未知数

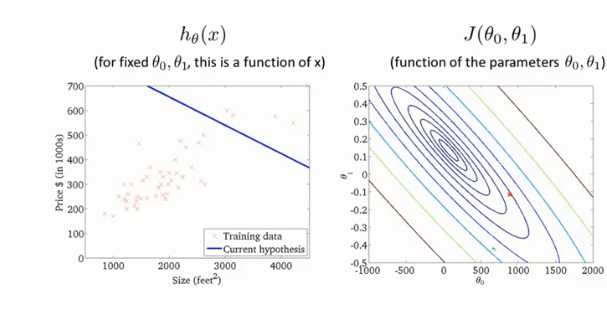

假设函数和代价函数的关系

标签:mic 并且 image 参考 alpha http src mat blog

原文地址:https://www.cnblogs.com/gaowenxingxing/p/12232070.html