标签:scala 内存 new inf ima 文件中 strong hdf pac

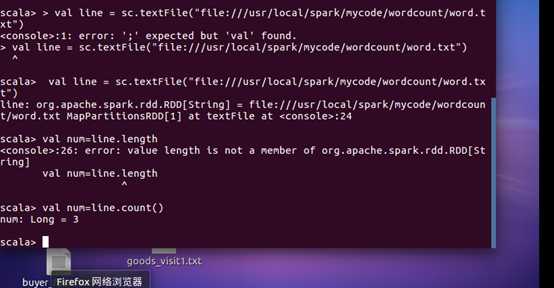

1.在 spark-shell 中读取 Linux 系统本地文件“/home/hadoop/test.txt”,然后统计出文 件的行数;

2.在 spark-shell 中读取 HDFS 系统文件“/user/hadoop/test.txt”(如果该文件不存在, 请先创建),然后,统计出文件的行数;

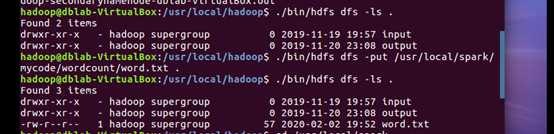

(1) 将文件上传到hdfs上

(2) 启动spark,并实现统计文件行数

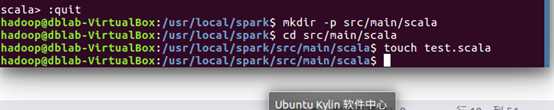

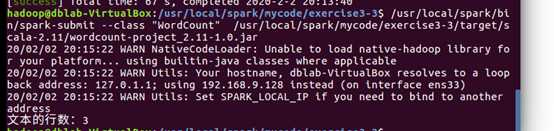

3.编写独立应用程序,读取 HDFS 系统文件“/user/hadoop/test.txt”(如果该文件不存在, 请先创建),然后,统计出文件的行数;通过 sbt 工具将整个应用程序编译打包成 JAR 包, 并将生成的 JAR 包通过 spark-submit 提交到 Spark 中运行命令

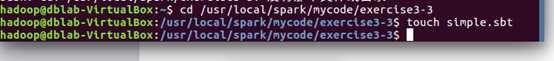

(1) 创建文件夹以及scala文件

(2) 编写程序

import org.apache.spark.SparkContext

import org.apache.spark.SparkContext._

import org.apache.spark.SparkConf

object WordCount {

def main(args: Array[String]) {

val inputFile = "hdfs://localhost:9000/user/hadoop/word.txt"

val conf = new SparkConf().setAppName("WordCount")

val sc = new SparkContext(conf)

val textFile = sc.textFile(inputFile)

val num=textFile.count()

println("文本的行数:%s".format(num))

}

}

(3) 新建sbt文件

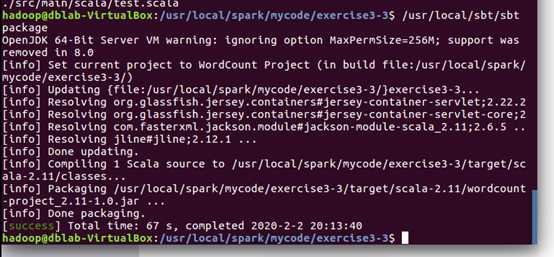

(4) 将程序打包成JAR

(5)通过 spark-submit 运行程序,将生成的 jar 包通过 spark-submit 提交到 Spark 中运行

标签:scala 内存 new inf ima 文件中 strong hdf pac

原文地址:https://www.cnblogs.com/zhang12345/p/12260775.html