标签:通过 文档 有意思 agent 今天 采集 其他 default learning

前两天大概研究完3DBall示例,里面的初始化中运用了如下代码:

public class Ball3DAgent : Agent

{

[Header("Specific to Ball3D")]

public GameObject ball;

Rigidbody m_BallRb;

IFloatProperties m_ResetParams;

public override void InitializeAgent()

{

m_BallRb = ball.GetComponent<Rigidbody>();

m_ResetParams = Academy.Instance.FloatProperties;

SetResetParameters();

}

public void SetBall()

{

m_BallRb.mass = m_ResetParams.GetPropertyWithDefault("mass", 1.0f);

var scale = m_ResetParams.GetPropertyWithDefault("scale", 1.0f);

ball.transform.localScale = new Vector3(scale, scale, scale);

}

public void SetResetParameters()

{

SetBall();

}

}

这里面的m_ResetParams参数初始化让我没明白到底是干啥用的,今天翻官方文档才发现这里参数的意义,简单来讲其实这里是为了训练出可以适应环境改变的Agent(按官方文档题目翻译过来是,训练广义强化训练学习代理),官方文档中对应的是这一篇《Training Generalized Reinforcement Learning Agents》。

下面的补充其实主要就是对这一点进行补充,同时把官方的这篇文章翻译一遍,再加一些自己的拙见和理解。

在训练agent中的一个问题就是在相同的环境中,agent会趋向于适应这种环境。如此以来,训练出的模型就不能泛化到环境中的任何调整或者变化,说白了就是只要环境值有任何改变,训练出的模型就可能失效了。这就类似于在监督学习中使用相同的数据集对模型进行训练和测试。在使用不同的对象或属性随机实例化环境的情况下,这就有问题了。

为了使agent在不同的环境中具有鲁棒性和可泛化性,应该针对环境的多种变换对agent进行训练。当agent使用这种方式进行训练后,它能更好的(具有更高的性能)适应环境在未来不可见的变化。

为了可以使得环境多样化,ml-agents使用了Reset Parameters。Reset Parameters就是Academy单例中的FloatProperties,即Academy.Instance.FloatProperties,它只用在重置环境时使用。Ml-Agents还包含了不同的采样方法并为每个Reset Parameter创建了新的采样方法(这里不太懂是啥意思= =)。在3DBall的环境示例中,Reset Parameter(重置参数)则为gravity、ball_mass以及ball_scale。

首先,我们需要提供一种方法来修改环境,即设置一组Reset Parameters并随时间改变它们。这种规定可以是确定性的或是随机的进行。

这是通过为每个Reset Parameter分配一个sample-type(如统一采样器)来完成的,该采样器类型决定了如何对Reset Parameter进行采样。如果没有给sampler-type提供Reset Parameter,则参数会在训练的过程中始终保持默认值并且不会改变。所有管理Reset Parameter采样器都由Sampler Manager来处理,该管理器也可以在需要的时候处理重置参数的新值生成。(应该就是训练好的模型拿到Unity中,我就算任意改变小球的质量、比例、重力加速度,都可以使得模型不失效,一会儿我们可以试试,先继续往后看)

为了安装Sampler Manager,我们新建一个.YAML配置文件,这个配置文件指定了我们希望如何为每个Reset Parameters生成新样本。在这个文件中,我们还指定了采集器以及resampling-interval(重新采集间隔数,即模拟多少步后将重置参数重新采样)。下面来看看3D Ball的采样器配置文件(路径在ml-agent源文件下ml-agents\config\3dball_generalize.yaml)。

resampling-interval: 5000

mass:

sampler-type: "uniform"

min_value: 0.5

max_value: 10

gravity:

sampler-type: "multirange_uniform"

intervals: [[7, 10], [15, 20]]

scale:

sampler-type: "uniform"

min_value: 0.75

max_value: 3

对以上参数进行解释:

resampling-interval:指定了在使用新的Reset Parameters样本重置环境之前,agent在特定环境配置下要训练的步数。Reset Parameters:Reset Parameters的名称集合,例如mass、gravity、scale。这些名称应该和Academy内部环境中被训练的agent的名称匹配(就是指在源代码中SetBall()方法中,设置重置参数时第一个string参数,需要和这里的配置文件名称相匹配)。如果环境中不存在文件中指定的参数,那么该参数将会被忽略。

sampler-type:指定用于Reset Parameter的采样器类型。这是Sampler Factory中存在的字符串。sampler-type-sub-arguments:根据sampler-type指定子参数。在上面的配置文件中,sampler-type-sub-arguments就相当于字符串为为gravity的Reset Parameter下的采样器类型multirange_uniform下的intervals。键名应该与采样器中相应参数的名称匹配。(见下文)The Sampler Manager会通过Sample Factory为每一个Reset Parameter分配一个采样器,采样器工厂维护了字符串键到采样器对象的字典映射。

以下是该工具包中包含的采样器类型的列表:

uniform:均匀采样器

通用的采样器类型定义了两个float类型的端点,在[min_value,max_value)范围内进行均匀采样。

min_value,max_valuegussian:高斯采样器

mean,st_devmultirange_uniform:多量程均匀采集器

interval_1_min, interval_1_max], [interval_2_min, interval_2_max], ...]intervals如果你想定义一个你自己的采样器类型,你必须首先继承Sampler基类(在sampler_class文件中)并保留接口。一旦指定了所需方法的类,还必须在采样器工厂(Sampler Factory)中注册它。这一步可以通过订阅Sampler Factory中的register_sampler方法来完成。命令如下:

SamplerFactory.register_sampler(*custom_sampler_string_key*, *custom_sampler_object*)

如下所示,假设实现了一个新的采样器类型CustomSampler,并且我们在Sampler Factory中使用字符串customsampler注册了CustomSampler类。

class CustomSampler(Sampler):

def __init__(self, argA, argB, argC):

self.possible_vals = [argA, argB, argC]

def sample_all(self):

return np.random.choice(self.possible_vals)

然后,我们需要新建一个YAML文件,如下,我们用上面新建的采样器类型用于Reset Parameter质量。

mass:

sampler-type: "custom-sampler"

argB: 1

argA: 2

argC: 3

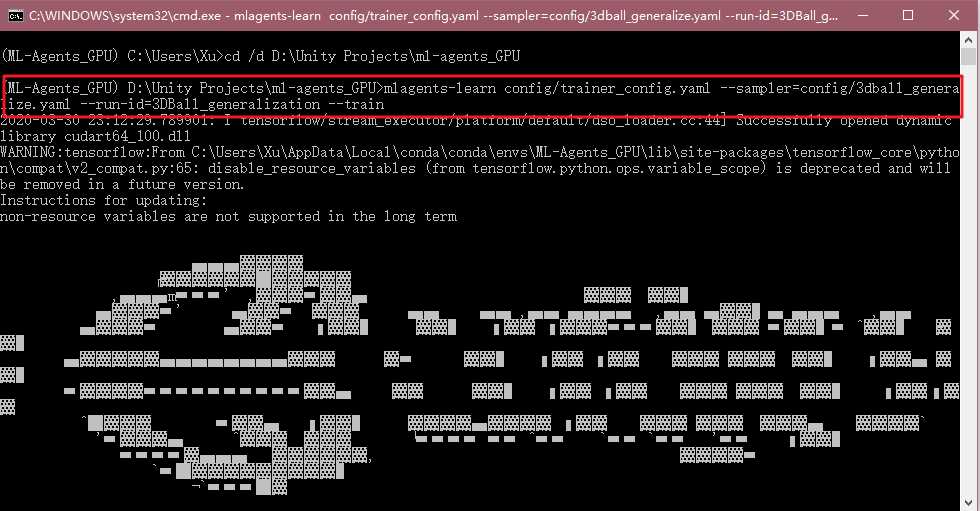

在采样器YAML文件定义好后,我们就可以启动mlagents-learn并使用--sampler标志来指定配置的采样器文件进行训练了。例如,我们想用带有config/3dball_generalize.yaml采样设置的Reset Parameters来训练具有泛化能力的3D Ball agent,那在训练时输入以下命令:

mlagents-learn config/trainer_config.yaml --sampler=config/3dball_generalize.yaml --run-id=3DBall_generalization --train

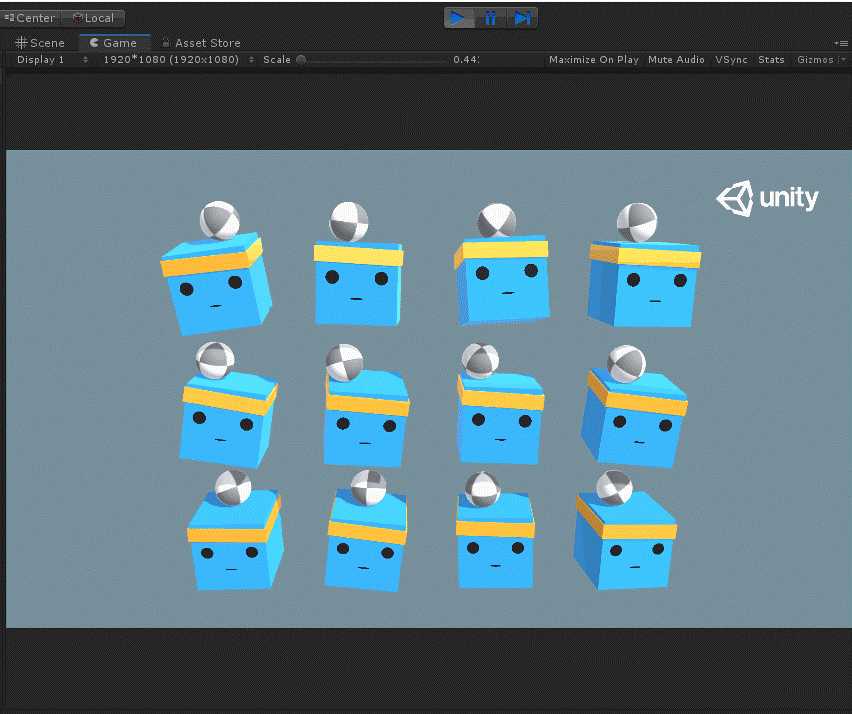

然后进行训练。会发现小球的大小并不是一成不变的,会在训练的过程中变大或者变小。

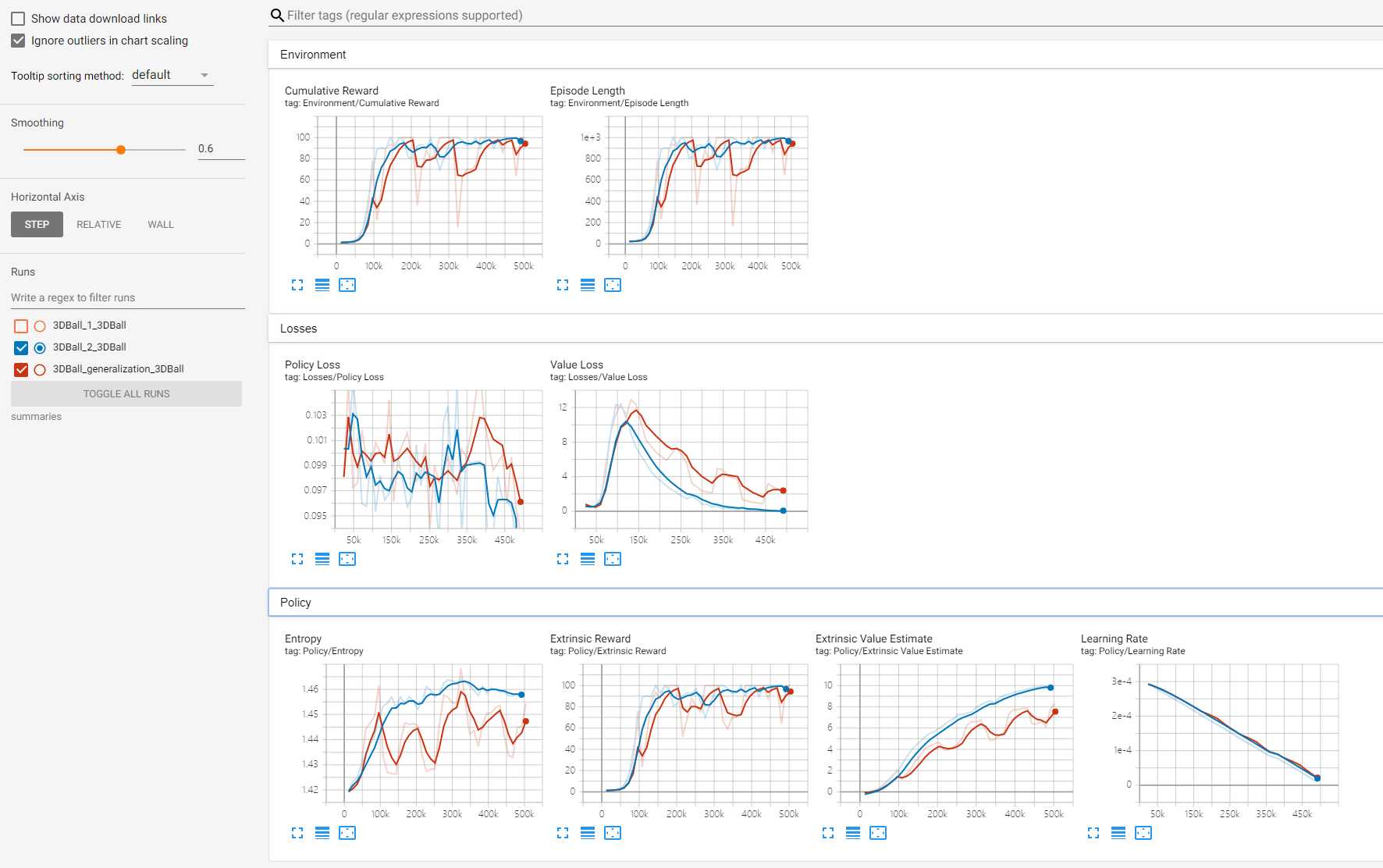

同时可以观察到小球的质量也会随机改变,这还挺有意思的。附上tensorboard。

图中红色的线是此次加入泛化参数的训练过程,蓝色的是之前正常的训练过程,可以明显看到红色的线相交于蓝色的线有明显的凹凸,这些凹凸基本就是在改变了小球的比例、质量或者重力加速度之后改变的。

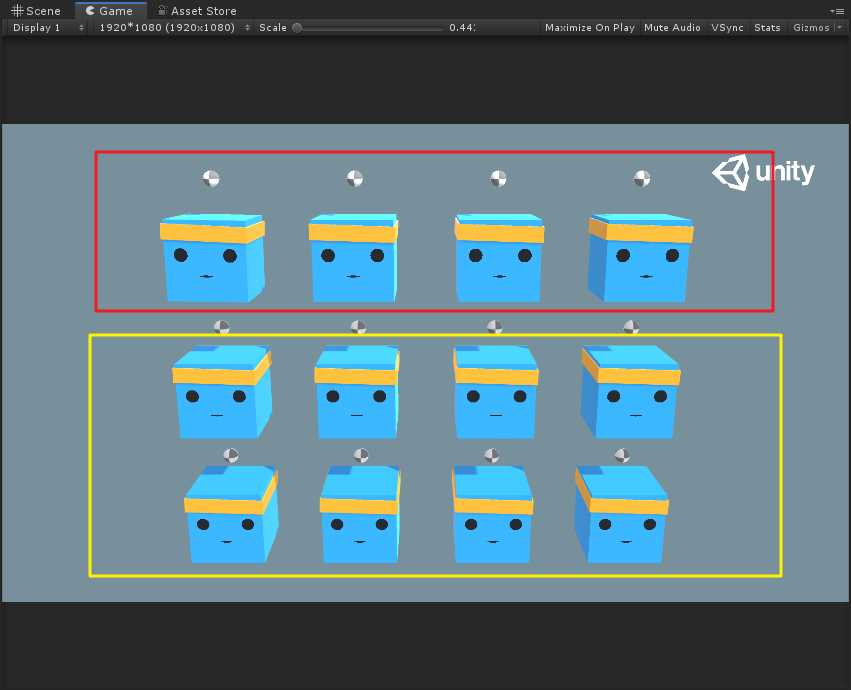

现在我们可以将训练好的模型导入Unity中,试一下。

我们把红色框里的agent运用刚才泛化训练后的模型,下面黄色框是没有泛化训练的模型,然后运行,我们通过统一调整小球的比例大小,来看有什么现象。

可以看到,下面两排没有泛化的模型很快就都掉下平台了,而最上层经过泛化的模型因为可以适应变化而长时间还能保持平衡。通过例子来实践一下,就立马明白了这里为什么一开始要对Academy.Instance.FloatProperties进行赋值,就是为了让训练出的模型具有更好的鲁棒性,来适应复杂多变的环境。在3D Ball里你去改变小球的比例、质量或是重力加速度,应该都可以使得小球处于较长时间的平衡。

总结来说,如果环境中有某些变量,那么就可以引用Reset Parameters来对这些变量随机取值进行训练,使得我们训练之后的结果可以很快适应环境的变化。

写文不易~因此做以下申明:

1.博客中标注原创的文章,版权归原作者 煦阳(本博博主) 所有;

2.未经原作者允许不得转载本文内容,否则将视为侵权;

3.转载或者引用本文内容请注明来源及原作者;

4.对于不遵守此声明或者其他违法使用本文内容者,本人依法保留追究权等。

标签:通过 文档 有意思 agent 今天 采集 其他 default learning

原文地址:https://www.cnblogs.com/gentlesunshine/p/12602404.html