标签:挂载 world inux -name log 创建 mod serve 场景

参考连接:<https://docs.ceph.com/docs/master/install/ceph-deploy/quick-cephfs/>;

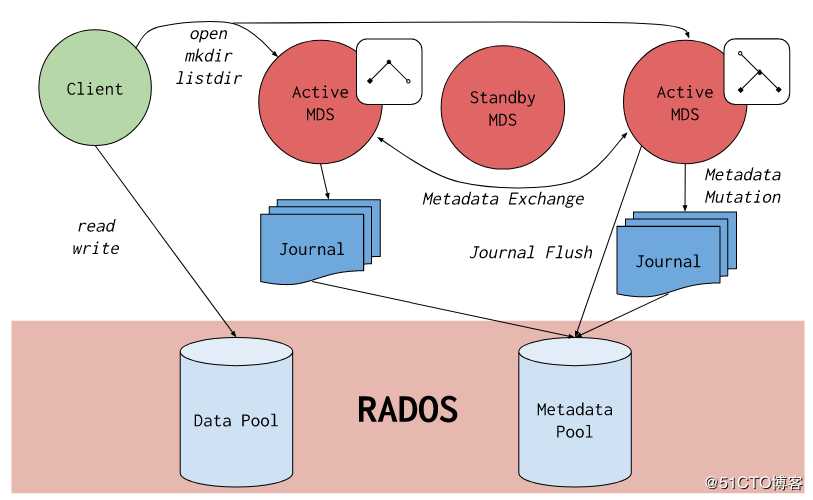

? Ceph File System (CephFS) 是与 POSIX 标准兼容的文件系统, 能够提供对 Ceph 存储集群上的文件访问.Jewel 版本 (10.2.0) 是第一个包含稳定 CephFS 的 Ceph 版本.

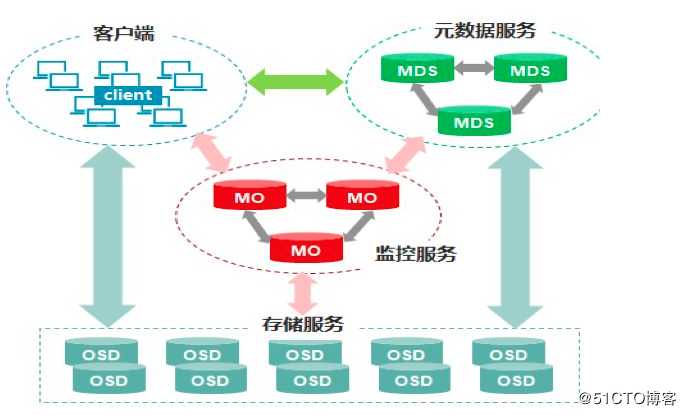

? CephFS 需要至少一个元数据服务器 (Metadata Server - MDS) daemon (ceph-mds) 运行, MDS daemon 管理着与存储在 CephFS 上的文件相关的元数据, 并且协调着对 Ceph 存储系统的访问。

底层是核心集群所依赖的, 包括:

? CephFS 库层包括 CephFS 库 libcephfs, 工作在 librados 的顶层, 代表着 Ceph 文件系统.最上层是能够访问 Ceph 文件系统的两类客户端.

? 要使用 CephFS, 至少就需要一个 metadata server 进程。可以手动创建一个 MDS, 也可以使用 ceph-deploy 或者 ceph-ansible 来部署 MDS。

1)安装MDS

登陆到cephuser的工作目录

# 可以指定多个hostname组成集群

[cephuser@cephmanager01 cephcluster]$ ceph-deploy mds create cephmanager01 cephmanager02 cephmanager03

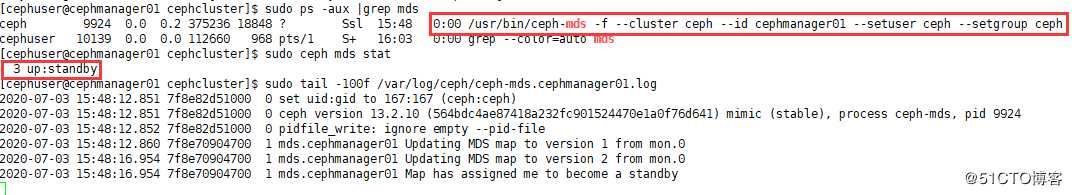

# 各个节点确认进程是否依据启动

[cephuser@cephmanager01 cephcluster]$ sudo ps -aux |grep mds

# 查看mds状态

[cephuser@cephmanager01 cephcluster]$ sudo ceph mds stat

# 确认个节点日志是否有错

[cephuser@cephmanager01 cephcluster]$ sudo tail -100f /var/log/ceph/ceph-mds.cephmanager01.log

注意:由于没有文件系统,所有三个mds均是standy状态

1)CephFS 需要两个 Pools - cephfs-data 和 cephfs-metadata, 分别存储文件数据和文件元数据

[cephuser@cephmanager01 cephcluster]$ sudo ceph osd pool create cephfs-data 16 16

[cephuser@cephmanager01 cephcluster]$ sudo ceph osd pool create cephfs-metadata 16 16

#查看pool信息,确实是否创建成功

[cephuser@cephmanager01 cephcluster]$ sudo ceph osd lspools? 注:一般 metadata pool 可以从相对较少的 PGs 启动, 之后可以根据需要增加 PGs. 因为 metadata pool 存储着 CephFS 文件的元数据, 为了保证安全, 最好有较多的副本数. 为了能有较低的延迟, 可以考虑将 metadata 存储在 SSDs 上.

2)创建一个 CephFS, 名字为 cephfs:

[cephuser@cephmanager01 cephcluster]$ sudo ceph fs new cephfs cephfs-metadata cephfs-data

#查看确认

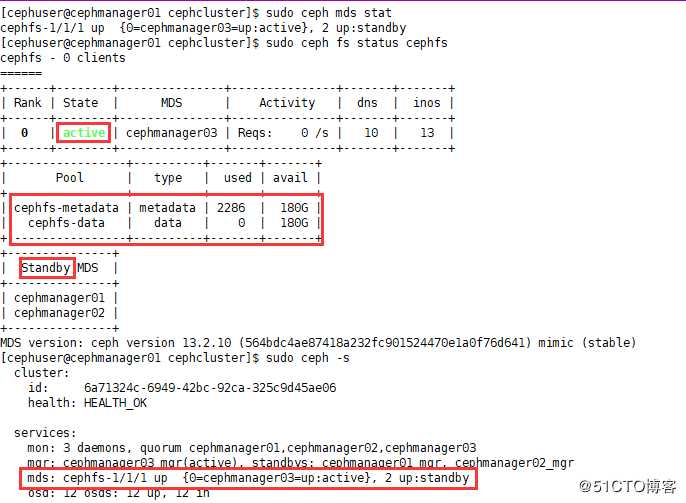

[cephuser@cephmanager01 cephcluster]$ sudo ceph fs ls3)验证至少有一个 MDS 已经进入 Active 状态

[cephuser@cephmanager01 cephcluster]$ sudo ceph fs status cephfs

[cephuser@cephmanager01 cephcluster]$ sudo ceph -s

1)创建一个用户,用于访问CephFS

[cephuser@cephmanager01 cephcluster]$ sudo ceph auth get-or-create client.cephfs mon ‘allow r‘ mds ‘allow rw‘ osd ‘allow rw pool=cephfs-data, allow rw pool=cephfs-metadata‘2) 验证key是否生效

[cephuser@cephmanager01 cephcluster]$ sudo ceph auth get client.cephfs确保在Linux内核2.6.34和以后的版本中

1)创建挂载点

[root@localhost ~]# mkdir /cephfs2) 挂载目录

# 如果有多个mon,可以列出多个,以","隔开

[root@localhost ~]# mount -t ceph 192.168.10.51:6789:/ /cephfs/ -o name=cephfs,secret=AQDB7f5eZ9bpDxAA65iULAt2OARmKJXwwLc8GQ==备注:centos7及以上版本支持目录类型ceph

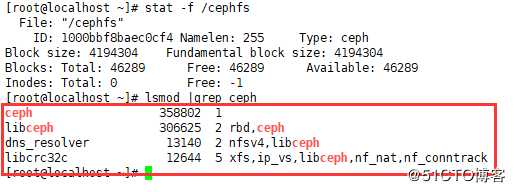

3) 验证是否挂载成功

[root@localhost ~]# df -h

#挂载空间的大小登陆所有ceph剩余空间的大小,可以通过ceph df确认

[root@localhost ~]# stat -f /cephfs4)查看加载内核情况

[root@localhost ~]# lsmod |grep ceph

5) 设置自动挂载

[root@localhost ~]# echo "ceph 192.168.10.51:6789:/ /cephfs ceph name=cephfs,secretfile=/etc/ecph/cephfskey,_netdev,noatime 0 0" >> /etc/fstab采用内核的形式挂载性能相对较高,对于内核不满足要求的,可以采用FUSE

1)创建挂载点

[root@localhost ceph]# mkdir /ceph-fuse2)安装ceph-common和ceph-fuse

[root@localhost ~]# yum install -y ceph-common

[root@localhost ~]# yum install -y ceph-fuse3)将服务器端集群的ceph.conf和拷贝到客户端(这样就把客户端和集群关联起来了)

[root@cephmanager01 cephcluster]# scp ceph.conf root@192.168.10.57:/etc/ceph/4)编辑认证文件

将服务器端ceph auth get client.cephfs的内容复制到客户端/etc/ceph/ceph.client.cephfs.keyring,并删掉exported keyring for client.cephfs

[root@localhost ceph]# vim /etc/ceph/ceph.client.cephfs.keyring

[client.cephfs]

key = AQDB7f5eZ9bpDxAA65iULAt2OARmKJXwwLc8GQ==

caps mds = "allow rw"

caps mon = "allow r"

caps osd = "allow rw pool=cephfs-data, allow rw pool=cephfs-metadata"

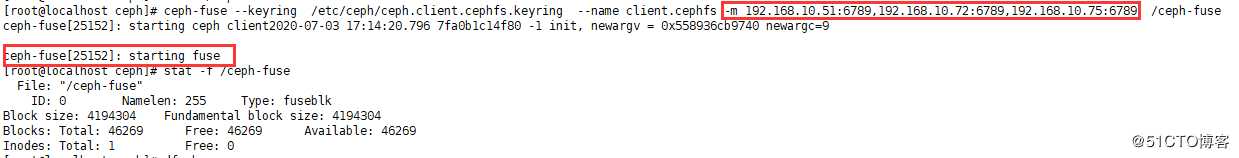

5) 使用 ceph-fuse 挂载 CephFS

# 指定了多个mon,认证应用认证文件(注意权限和ceph.conf一致)

[root@localhost ceph]# ceph-fuse --keyring /etc/ceph/ceph.client.cephfs.keyring --name client.cephfs -m 192.168.10.51:6789,192.168.10.72:6789,192.168.10.75:6789 /ceph-fuse6) 验证 CephFS 已经成功挂载

[root@localhost ceph]# stat -f /ceph-fuse

[root@localhost ceph]# df -h

7)写入文件进行测试

[root@localhost ceph-fuse]# echo "hello world" > /ceph-fuse/fuse.txt

[root@localhost ceph-fuse]# cat /ceph-fuse/fuse.txt8) 自动挂载

[root@localhost ceph-fuse]# echo "id=cephfs,keyring=/etc/ceph/ceph.client.cephfs.keyring /ceph-fuse fuse.ceph defaults 0 0 _netdev" >> /etc/fstab9) 卸载

[root@localhost ~]# fusermount -u /ceph-fuse/标签:挂载 world inux -name log 创建 mod serve 场景

原文地址:https://blog.51cto.com/14758677/2509006