标签:移除 meteor regular cnn oss custom 好的 ssi 作者

发表在 NAACL 2019

在这之前,对于文本风格迁移后的效果没有一个很好的统一评价指标,因此,这篇文章做了一个总结,基于之前的一些工作提出从 style transfer intensity 、content preservation、 naturalness 这三个方面来考量,并在content preservation 上提出了一个新的方法 即使用 mask 来掩盖掉 style words ,另外提出了自己的 automated evaluation(Earth Mover‘s Distance、Word Mover‘s Distance),能够更好地对迁移后的效果做出评价。

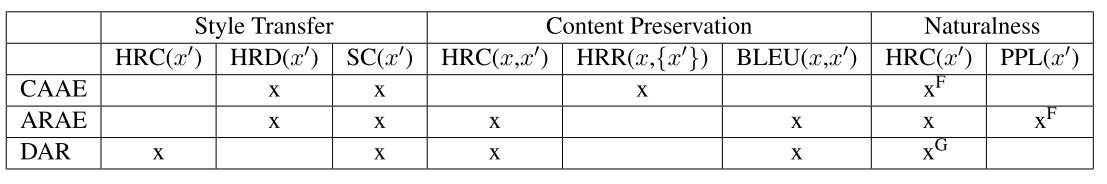

作者主要是对之前的三篇文章提出的模型评价指标进行了一个总结

其中,HRC 是 human raters 通过连续量化来评价的(如:1-5 范围评分);

? HRD 是在做 sentiment(positive/negative)任务时的评价指标

? HRR 是 human raters 用来评价输出 x‘ 与输入 x (most to lest similar)

? SC 是一个 style classifier

? BLEU 是机器翻译任务中常用的评价指标

? PPL 是评判句子的混乱度

Construction of Style Lexicon(词典(专用词汇))

在对内容失真度进行评价时,常常会去掉代表句子风格的词,那么在很多时候如何去确定具体的属性词时,会出现很多的分歧,特别是当人工来评价时,会带有主观的想法,因此,作者提出构建一个带标签样式的词典,来更好的区分属性词;另一方面,我们几乎不可能完全把属性词与内容词完全分开,所以要进行一个权衡,选择更高的准确率(precision)和更低的召回率(Recall)来降低移除内容词的风险

Human Evaluation

在这之前一般都是邀请相关的语言学专家只对输出的句子 x‘ 来进行评判打分,但来自其他领域的现有研究表明,对两个相对的句子比较打分,比只对一个句子打分要更加可靠和精准,因此,作者用 relative scoring 来代替之前的 absolute scoring

Style Transfer Intensity

改变之前只对输出的结果打分,改成对输入和输出一起打分(同样也适合多情感风格任务)

Content Preservation

由于并不是所有的打分者都能很好的区分属性词,作者提出了一个新方法,根据之前构建的词典来 mask 掉属性词,让打分者只专注于内容部分

Naturalness

改变之前只对输出结果进行打分,而完全不考虑 x 的方法,让打分者来区分 x 和 x‘ ,如果打分者任务 x‘ 更好,则说明模型取得了一定的成功,因为它可以欺骗评估者

Automated Evaluation

Style Transfer Intensity

不仅计算有多少实现了从源语言到目标语言,还使用 Earth Mover‘s Distance 来计算从 x 分布到 x’ 分布的最小代价(主要是通过分类器(fastText & textcnn)来判别)

Content Preservation

两种方式:

评价标准:

Naturalness

对样本x 和 x‘, 训练一个 unigram 和 neural logistic regression 分类器,通过对抗分类器(判别器)需要将人为得输入和机器产生的输出区分开,如果输出的句子越自然,则越容易欺骗分类器。

计算每种类型的人工评价和分类器的一致性的比例

源代码:https://github.com/passeul/style-transfer-model-evaluation

Evaluating Style Transfer for Text 阅读

标签:移除 meteor regular cnn oss custom 好的 ssi 作者

原文地址:https://www.cnblogs.com/alivinfer/p/13368687.html