标签:注入 man 现在 book 隐私保护 除了 包括 组成 社交网站

https://mp.weixin.qq.com/s/4q5x-ztoZMvOEQW94gKnZABy 超神经

中国的一句老话「相由心生」,最近通过斯坦福的科学家用人脸识别技术得到了验证。

他们的研究中,提出了一个大胆的猜测:人的性取向和犯罪倾向,都可以通过人脸的面部识别分析出来。听起来很不可思议,当然,有人好奇,希望尽快得到实践应用,也有人大力抨击,认为这是一种极大地歧视。面部识别,最广泛的用途是在安防、监控、金融风控等领域,主要用作实人认证。而现在,面部识别在斯坦福大学课题组的带领下找到了新的方向,他们希望通过面部识别,研究人的性取向和犯罪倾向。

之所以研究性取向,也是因为社会的进步让边缘文化得到发展,进一步融合进主流文化并得到更多人的接纳。不同多数人的性别认知越来越被接受,不同的性取向也得到了社会的认同,甚至法律上的认同。

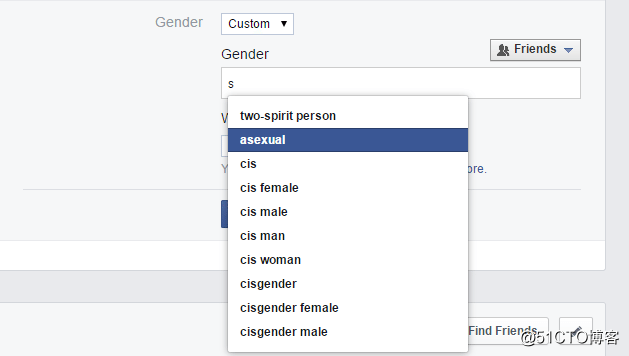

尤其是社交类型的软件,不仅有很多专为少数性向人群设计的 app,包括 Facebook 早在 2014 年就开始注重性别和性向类型的区分,将在用户的性别选项中,将原本的二项选择增添到了 58 项之多,包括 Androgyne (两性人), Male to Female(男变女), Transgender Female(跨性女), Two-spirit(两魂人等)。

Facebook 注册页面的性别选项曾高达 71 个(左图)

Google I/O 2019 注册页面的性别选项有 5 个和自定义(右图)

而现在的网站上,已经见不到这些选项,除了男性和女性之外,还有一个自定义选项,意味着你可以在填上任意的性别。

但如果有人告诉你,通过你的照片就会知道你有多大几率有可能变弯,你会是什么反应? 再如果,通过照片推论你有不小的犯罪几率呢?

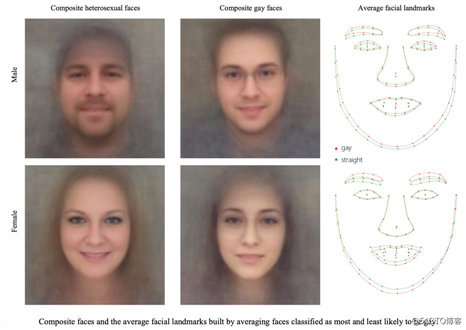

斯坦福大学的团队在 2017 年发布了一篇论文《Deep neural networks are more accurate than humans at detecting sexual orientation from facial images》(翻译:深度神经网络比人预测图像中人物的性取向更准确》),第一次将 AI ,面部图像,同性恋这三者关联了起来。

通过多张图像合成的性取向面孔图像和脸部特征

通过从社交网站摄取的面部照片,利用深度神经网络( DNN )学习了一些特征之后,再通过一些机器学习的方法,达到分辨性取向的目的。

他们最后的结果是 AI 模型的识别准确率要优于人类,机器算法可以通过面部的一些特征来分辨出人物的性取向。

在不到一年的时间,一位叫 John Leuner 的硕士生将这个研究复现和改进,他的论文《A Replication Study: Machine Learning Models Are Capable of Predicting Sexual Orientation From Facial Images》(翻译:《研究复现:机器学习模型可以预测部分人脸图像的性取向》,

基本上使用了类似的方法,但同时做出了一些改进,使用了不同的的数据集,增加了对人物图片的抗干扰能力等等。

斯坦福大学的方法用了两个模型,一个基于深度神经网络( DNN ),一个基于面部形态学( FM ),而 John 加入了模糊照片分类器的一个模型。

他的论文中,通过线上相亲网站的 20910 张照片组成的数据集,训练并确定了三个模型的预测能力。

由于模型使用了不同国家,种族的数据,所以适用性变得更好了。此外,针对模糊的照片也做了研究,对高度模糊的照片,AI 能从面部和背景的综合信息进行预测。

而且即使人物刻意化妆、戴眼镜、面部毛发遮挡、变换面部拍照角度时,测试发现模型预测的结果不会发生变化。 也就是说即使一个直男,扮成了女装大佬的样子, DNN 也能看出你其实是个直男。

不同装扮扮和角度的同一者测试照片

总体来说, Leuner 的研究,是对斯坦福那项研究的重复和改进,同样的都用数据证明了,面部信息能够被用来判断一个人的性取向问题 。

那么这样一项研究,AI 优于人类,在一些方面会促进人的认知和定位,或者帮助法律避免悲剧,那为什么会引起轩然大波呢?

一方面是涉及到同性恋这个敏感话题,在斯坦福论文发布在 arXiv 的时候,就引起了轩然大波,有同性恋群体更是不遗余力的抵抗,认为收到了来自技术的侵害。

在 2016 年,就有类似的一个研究触发了广泛的社会讨论。

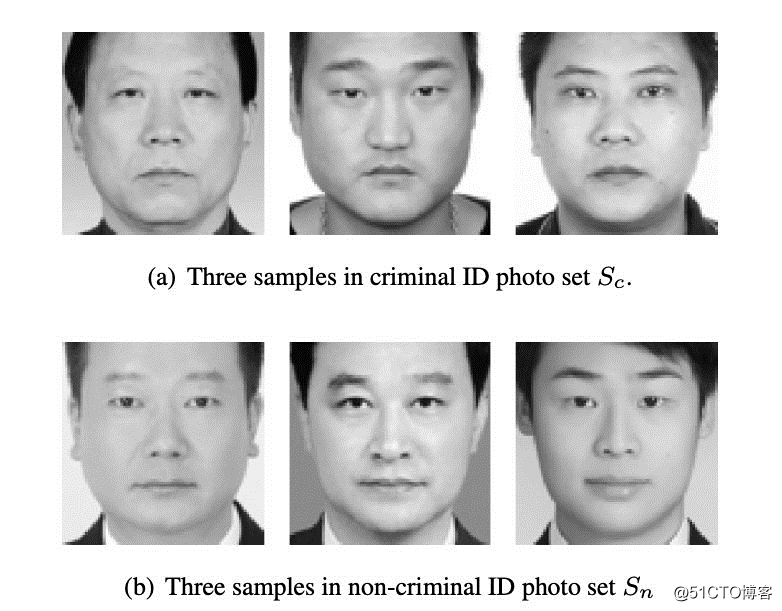

上海交通大学的两位研究者提交在 arXiv 上的一篇论文,《Automated Inference on Criminality using Face Images》,而研究的内容则是人脸识别判断罪犯。

研究中所用的几张样本照片,上排是犯案者

用面部信息,看出一个人的性取向,犯罪信息,就足以让人们感到担忧,假如继续再进一步,推广到预测情绪、智商甚至是政治立场,会不会最终导致严重的偏见和歧视?

比如在同性恋不合法的地区,一旦技术被用来执法,就会变成血腥的故事。而通过预知一个人的犯罪倾向,提前将其抓捕,也是科幻片里出现过的场景。

而另一个很多人质疑和诟病的地方,就是这类研究是不是以 AI 的方式行「伪科学」之实。

在一部分人眼里,利用面部判断人行为的方法,让他们和相面术联系了起来,不过他们的研究用了更多的数据作为支撑,让 AI 的预测看起来也更「科学」。

有趣的是,2017 年的那篇研究犯罪的论文,参考文献中赫然列入了一本面相的书《神相全编》。

所以不乏有人质疑,这些研究,就算是数据上有很高的准确率,真的就揭示了二者的联系吗?

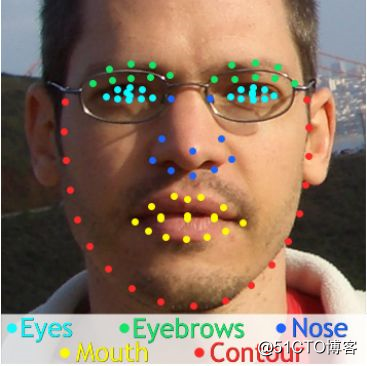

研究中所关注的一些特征

在斯坦福大学的研究论文发出的时候,就到了很多质疑的声音,怀疑他们数据偏少,研究的结论却过于笃定。而关于犯罪的预测,同样如此。

国际隐私保护组织的 Richard Tynan 博士这么说到,「作为一个个体,你不可能知道机器是怎么对你做出判定的。

在小数据集上,算法、人工智能和机器学习可能会建立起专断荒唐的相关性。这不是机器的错,但把复杂系统运用在不合适的地方是危险的。」

我们不妨大胆假设,也许人们潜意识里,并不是害怕 AI 发现了什么,而是害怕有人会拿着 AI 分析的结果大做文章。

AI 处理问题的方式,依靠更多数据提升了自身的说服力。但不要忘了,训练和设计 AI 的是本来就带着偏见的人类。

而 AI 通过数据得出来的也不过是一些数字,那么对于它的解读,也时常会被带着某种方式被加以利用。

普林斯顿大学信息技术做过的一项研究表明:机器学习和 AI 算法,会不经意强化和扩大了社会上流传的,或者用户潜意识中的既定偏见。比如在很多场景下,会把「医生」和「他」匹配在一起,而「护士」和「她」匹配在一起。

回到关于 AI 断定同性恋的研究,如果预测的事物换了一种,比如某种疾病,那么同样的方法和类似的结论,也许就有很多现在反对的人会称赞是漂亮的工作。

如果只是揭示了规律,本身没什么可怕的,但偏见和歹念被注入,技术越强,带来的毁灭也就越大。

斯坦福的研究者在回应质疑的时候,在推特上有这样一条回复:「如果你发现一项热门的科技中隐含着威胁,你会怎么做?是对此保密,还是研究它、让同行评议它、并发出警告呢?」

标签:注入 man 现在 book 隐私保护 除了 包括 组成 社交网站

原文地址:https://blog.51cto.com/14929242/2535565