标签:hbm 开发者 相互 tensor 工具 处理 服务 办公室 png

https://mp.weixin.qq.com/s/GU7XOQ93Hd4zBG2eKNLdng

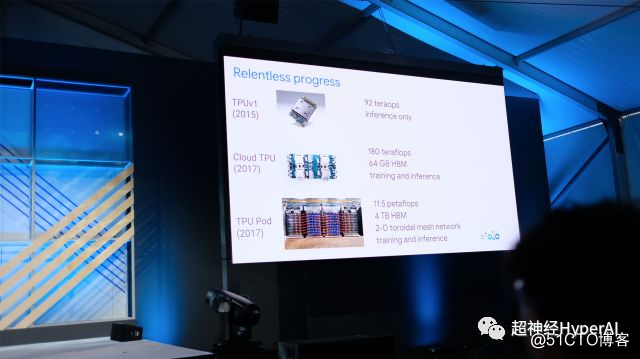

在 Google 2018 的开场中, Sundar Pichai 在简单的介绍了 Google 使用人工智能参与诊疗、处理音视频等能力之后,果不其然的将整场发布会的 C 位让给了 TPU —— 这个 Google 为深度学习打造的张量处理器已经成为 Google 在人工智能领域修出的最强一块肌肉。

TPUv3 相较去年发布但至今未能公开提供使用的 TPUv2 性能有较大提升,计算峰值是 2.0 版本的八倍。性能的提升也有相当的代价,提升的巨大发热量让工程师们不得不将散热器更换为黄铜导管。如你所想,Sundar Pichai 也承认了这一代 TPU 的冷却方案是液冷。

TPUv2 的算力峰值是 180Tflops,64GB HBM 高速缓存,比第一代 TPU 增加了训练能力。分会场 TPU 主题的演讲人 Zak Stone 展示了多个使用 Tensor2Tensor 的模型训练过程,性能的确极为喜人。超神经在会后对 Zak Stone 的提问中咨询了 TPU 对其他开发框架的适应能力,很遗憾但是在意料之中的是,TPU 仅能支持 TensorFlow 相关工具链,对以 Pytorch 为首的其他开发框架均不提供支持。Zak 还提到开源项目 Tensor2Tensor 的进展十分快速(Very faaaast)。

同一个分会场的 Google 工程师 Frank Chen 对超神经表示,3.0 版本的 TPU 的确在功耗上「略有增加」,同时在机房里 TPU Pod 之间相互通讯的 Pod 之间的通讯使用的是高度定制化的线缆,不是 Infinity Band 等光纤解决方案,充足供给的带宽和缓存提升了整个集群能力的同时,当然也对能耗带来了一定负担。当谈到是否今年年内可以对开发者提供 3.0 版本的使用权限时,他不自然的笑了一下说,希望如此。

嗨,谁家服务还没个 Delay 呢,不过等一下,3.0 不能立即使用的话,TPUv2 什么时候才能不用申请配额呢?Zak Stone 说,只要他回到办公室,所有正在等待 review 的申请的开发者就都会立刻收到邮件,得到可以使用服务的权限。

好吧,让我们期待着 Zak 跑步前进,尽快回到他的办公桌前。

标签:hbm 开发者 相互 tensor 工具 处理 服务 办公室 png

原文地址:https://blog.51cto.com/14929242/2536094