标签:靠谱 函数 老师 原则 完全 rap enc 独立 智商

回顾

在文章《朴素贝叶斯》中,小夕为大家介绍了朴素贝叶斯模型的基本知识,并且得出了朴素贝叶斯是利用联合概率P(x1,x2,x3...xn,y)来确定某个样本为某个类别的概率,进而利用最大后验概率(MAP)来决策类别。也就是说,朴素贝叶斯的假设函数如下:

其中,假设有c个类别,则i=1,2,...,c。(补充:argmax大家应该都熟悉了吧,意思就是返回使函数值最大的参数,这里的函数即P(X,yi),参数即yi。)

其中,根据朴素贝叶斯的条件独立性假设,联合概率被简化为

我们想啊,朴素贝叶斯也是个模型,神经网络也是个模型。然而神经网络的粉丝们就给神经网络画出了图,还画的辣么好看~而作为朴素贝叶斯粉丝的小夕当然也要给朴素贝叶斯模型画个图啊,把我家朴素贝叶斯描述的活灵活现,漂漂亮亮嗒~

画像

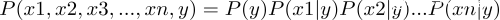

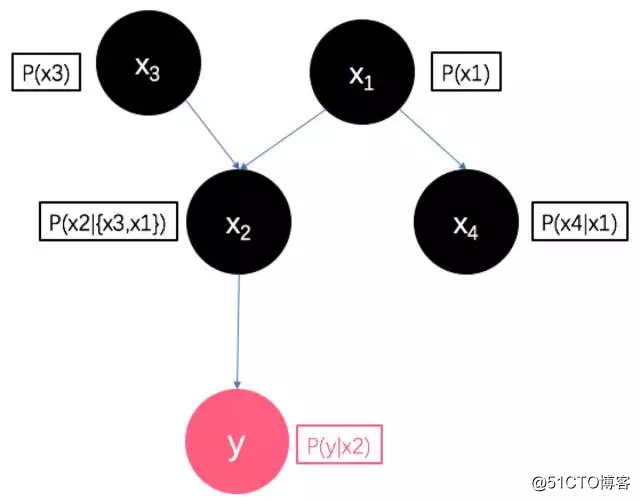

如图,小夕将每一个随机变量(即X中的每个维度xi和类别y)画成一个圈圈,这个圈圈就代表这个随机变量。

然后用一条有向边来表示随机变量之间的条件关系,比如P(x1|y),它表示“如果能观测到y,那么x1的概率分布函数就确定了(当然了,x1的概率分布函数就是x1取各个值时的概率,所组成的函数)”。简单来说就是给定(观测到)y的取值,就知道了x1的情况。所以用箭头表示这个关系:

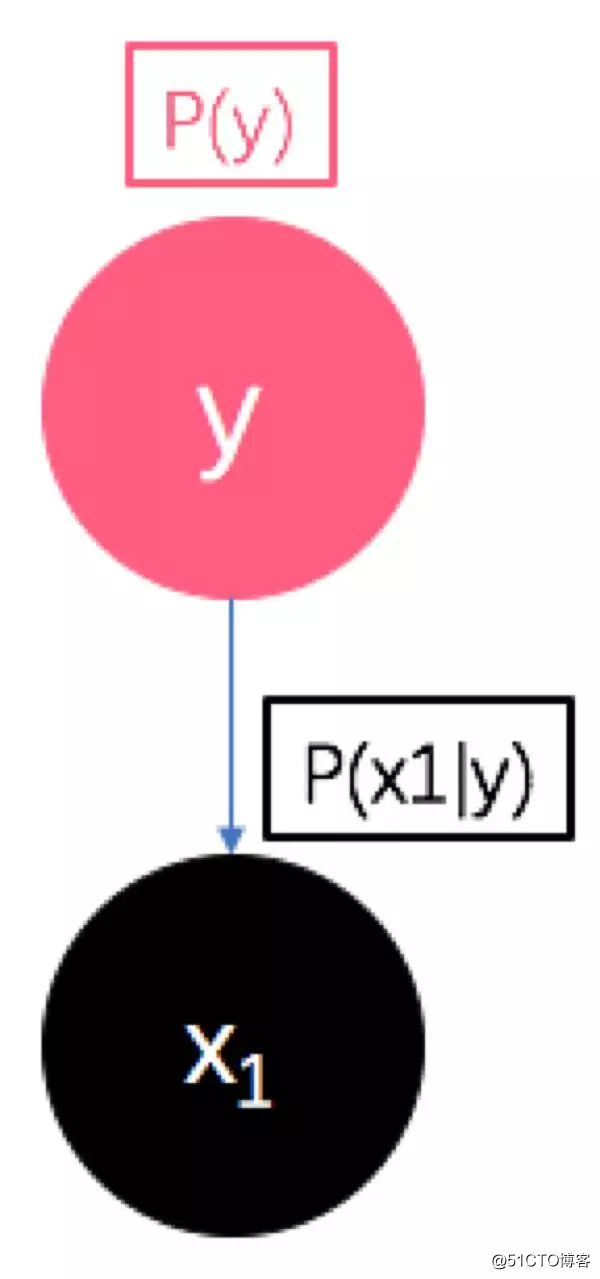

所以,朴素贝叶斯的假设函数(准确讲是假设函数的核心)即:

看~这个图是不是把公式

P(x1,x2,x3,...,xn,y) = P(y)·P(x1|y)·P(x2|y)...P(xn|y)

非常形象的画出来啦~

这个图,我们暂且就定义为有向图,反正根据小夕的说法,它描绘了“各个随机变量之间的条件依赖关系”(看起来像推理关系)。

想一想这个图还有没有隐含含义呢?

机智的宝宝肯定想到了朴素贝叶斯的条件独立性假设!没错!这个图还反映了“每个随机变量的独立性关系”(看起来像每个随机变量的爸爸妈妈是谁,子女是谁)。

看,有了独立性关系这个解释,是不是又把朴素贝叶斯的条件独立性假设包含进来啦。回顾一下,朴素贝叶斯假设样本的特征向量的各个维度之间是互相独立的(即x1,x2,...,xn之间是相互独立的),所以在这个图中,它们之间没有连线,表示相互独立。

贝叶斯网

想一想,小夕已经“吐槽”过了,朴素贝叶斯很朴素,因为它做了一个很不靠谱的输入变量xi之间相互独立的这个假设,因此小夕在《NB与LR的战争》中还建议大家去做一个将X的维度原地复制成两倍的实验,以验证这个独立性假设的不靠谱之处。

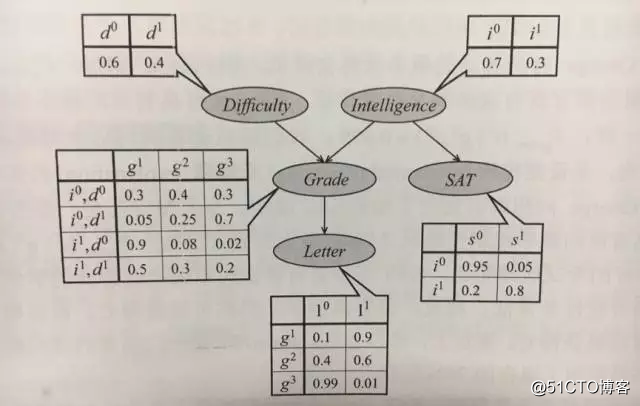

想象一下,假设我们有一个预测某教授会不会给一个学生写一封好的保研推荐信的机器学习任务。

在这个任务中,类别即两个:会,或者不会,给这个学生写推荐信。特征我们选取4个:学生的x1=智商,x2=学生在这个老师的课的考试分数,x3=这个老师的课的考试难度,x4=这个学生的SAT(美国版高考)成绩。

(该例子来自《probablistic graphicalmodel》Kolleretc.)

显然啊,x1和x3联合起来会很大程度上决定x2的值,x1会很大程度决定x4的值,而让老师去写推荐信的时候,老师只会看到你在他的课上考了多少分以及老师此刻的心情来决定是否给你写个好推荐信。然而用朴素贝叶斯建模的话,显然这些客观存在的依赖关系全都被忽略掉了,可想而知往往结果很糟糕。

那么,我们可不可以保留这些客观存在的依赖关系呢?

想想刚才小夕为朴素贝叶斯画的图~我们就按照这个画图规则把进化版的模型画出来吧!

(x1=学生智商, intelligence;

x2=老师课的分数, score;

x3=课程难度, difficulty;

x4=SAT分数, SAT;

y=是否写好推荐信, letter)

看!对不对呢~按照前面说的画图原则,这个图是不是将客观存在的信息都描绘进去啦~

看起来像这个样子的模型叫什么呢?就是“贝叶斯网”!

也就是说:在贝叶斯网中,我们会建模样本的特征向量X内各个维度之间的依赖关系,并且隐含的包含了各个随机变量(X的各个维度以及y)的独立性关系(之所以说隐含,是因为在贝叶斯网络中,好像无法像朴素贝叶斯一样一眼看出变量之间的独立性关系,比如观测到x2时,你能知道此时y和x1是否是相互独立的吗?)

将这个模型训练完成之后,它看起来的样子是这样的(跟前面小夕画的图完全对应的):

(直接抠的书上的图(//?//)\)

于是按照机器学习框架,一大波问题袭来了:

1、这个模型如何训练?

2、这个模型如何对新样本分类?

除了这些一般化问题之外,还有前面提到的看似更复杂的问题:

贝叶斯网中隐含的各个随机变量的独立性关系如何描述?

小夕会在以后的文章中为大家逐步解开谜团~

ps:当然啦,这种画法肯定不是小夕首先提出来的,有兴趣的同学可以去看这篇论文(好像也不是这个论文的作者第一次提出来的):

Charles Sutton, Andrew McCallum: An Introduction toConditional Random Fields for Relational Learning.

除了这篇论文外,参考资料还有《probablistic graphical model》Koller etc.这本书有中文版~据说翻译的不错。不过要小心1000多页的块头哦。

标签:靠谱 函数 老师 原则 完全 rap enc 独立 智商

原文地址:https://blog.51cto.com/15061930/2571222