标签:span 网络层 src isp rop 效果 alt 隐藏 结果

学习率α:

β1:经验值认0.9 (用于计算Momentum中的dw 加权平均值)

β2:经验值0.9999(用于计算RMSprop中的dw⊙dw 加权平均值)

hidden units:不同层中的隐藏单元????

Mini_batch_size:取决于你的先显存

e:分母常数项,防止分母为0,1e-8,就默认设置,一般不用改

layers:神经网络层数

learning decay rate:衰减率:

一般地,上述所有超参数中,红色学习率最重要,黄色、品红色次之。在应用Adam算法时,一般不用调试β1,β2,e,直接默认就行。那么超参数该如何调试呢?

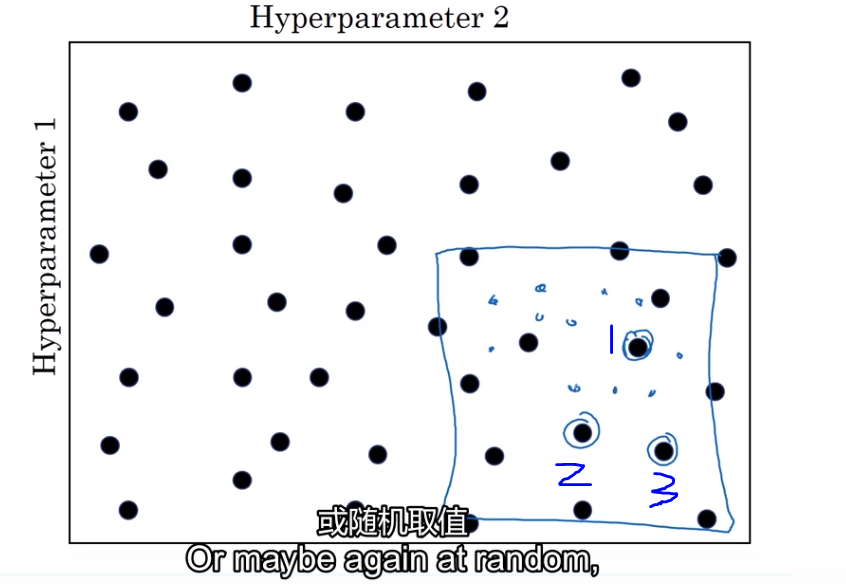

假设你现在有2个超参数,a、b,预设数值的时候,一般是:1、多次粗略随机取值,2、相应多次训练、验证效果,3、最后根据训练结果精确设置超参数取值。

如下图,加入咱们通过粗略随机取值,验证后,得出结论:位置1、2、3训练效果蛮好,这时候可以适当放大取值范围到蓝色框区域,接着去精细化取值,直到

找到一个相对较好的超参数。

标签:span 网络层 src isp rop 效果 alt 隐藏 结果

原文地址:https://www.cnblogs.com/winslam/p/14655105.html