标签:经典 exp rac sig float 机器学习 src 向量 网络

Logistic回归是机器学习中非常经典的一个方法,主要用于解决二分类问题,它是多分类问题softmax的基础,而softmax在深度学习中的网络后端做为常用的分类器,接下来我们将从原理和实现来阐述该算法的思想。

1.原理

a.问题描述

考虑二分类问题,利用回归的思想,拟合特征向量到类别标签的回归,常用Logistic回归。假设已知训练样本集\(D\)的\(n\)个样本 \(\left ( x_{i},t_{i} \right )_{i=1}^{n}\) ,其中\(t_{i}\in \left \{ 0,1 \right \}\) 为类别标签,\(x_{i} \in \mathbb{R}^{d}\) 为特征向量。

b.Logistic函数

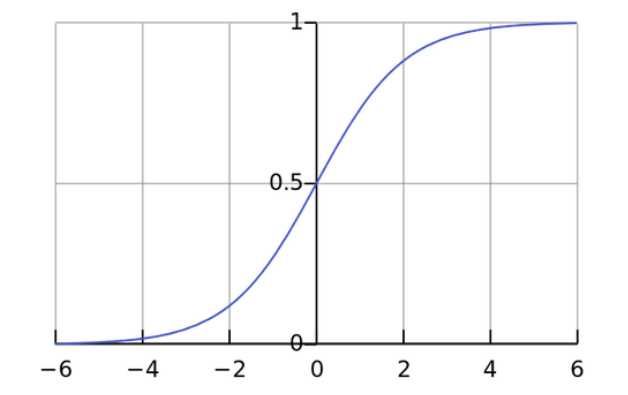

Logistic回归需要用到一个重要的logistic函数,又称为sigmod函数,logistic的重要作用就是通过它建立了特征和类别概率的拟合关系,其形式如下:

\(f\left ( x \right )=\frac{1}{1+e^{-x}}\)

对应的图如下所示:

Logistic函数具有以下两个重要的性质:

i: \(f(-x)=1-f(x)\)

ii: \({f}‘(x)=f(x)f(-x)=f(x)(1-f(x))\)

c.目标函数

根据logistic函数,logistic回归的回归函数为

\(f(x)=\frac{1}{1+exp(\mathbf{w^{\mathit{T}}}\mathbf{x})}\)

其中\(\mathbf{w}\) 为回归参数。

我们使用到极大似然估计法,因此需要构造关于样本 \(\left ( x_{i},t_{i} \right )\)的概率密度:

\(

P(x_{i},t_{i};\mathbf{w})=\left\{\begin{matrix}g(x_{i}),t_{i}=1\\

1-g(x_{i}),t_{i}=0\end{matrix}\right

\)

d.优化算法

2.实现

我们使用python实现Logistic回归。

标签:经典 exp rac sig float 机器学习 src 向量 网络

原文地址:http://www.cnblogs.com/cv-pr/p/7081861.html