标签:学习笔记 src flush 文件的 check space 操作 rpc 连接

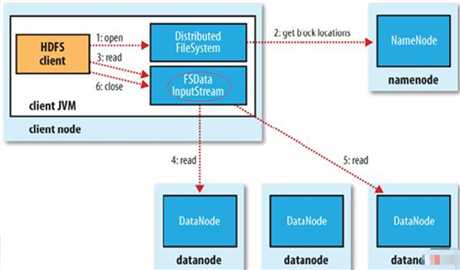

1 FileSystem通过RPC与NN通信,NN返回该文件的部分或全部block列表(含有block拷贝的DN地址)。

2 选取举栗客户端最近的DN建立连接,读取block,返回FSDataInputStream。

1 当读到block结尾时,FSDataInputStream关闭与当前DN的连接,并未读取下一个block寻找最近DN。

2 读取完一个block都会进行checksum验证,如果读取DN时出现错误,客户端会通知NN,然后再从下一个拥有该block拷贝的DN继续读。

3 如果block列表读完后,文件还未结束,FileSystem会继续从NN获取下一批block列表。

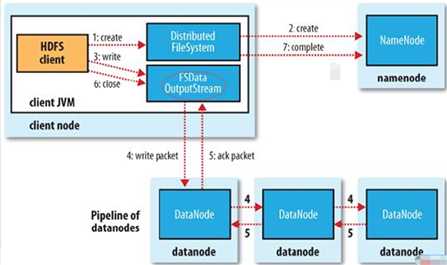

1 FileSystem向NN发出请求,在NN的namespace里面创建一个新的文件,但是并不关联任何块。

2 NN检查文件是否已经存在、操作权限。如果检查通过,NN记录新文件信息,并在某一个DN上创建数据块。

3 返回FSDataOutputStream,将Client引导至该数据块执行写入操作。

HDFS默认将每个数据块放置3份。FSDataOutputStream将数据首先写到第一节点,第一节点将数据包传送并写入第二节点,第二节点 --> 第三节点。

flush缓冲区的数据包,block完成复制份数后,NN返回成功消息。

标签:学习笔记 src flush 文件的 check space 操作 rpc 连接

原文地址:https://www.cnblogs.com/laowangc/p/8949850.html