标签:分布式 strong nta 上下文 项目总结 res 通过 img class

一、

词向量的表示方式:

(1)one-hot方式:

考虑一个词表V,里面的每一个词 wi都有一个编号 i∈{1,...,|V|},那么词 wi的one-hot表示就是一个维度为|V|的向量,其中第i个元素值非零,其余元素全为0。例如:

w2=[0,1,0,...,0]T

w3=[0,0,1,...,0]T

可以看到,这种表示不能反映词与词之间的语义关系,因为任意两个词的one-hot representation都是正交的;而且,这种表示的维度很高。

(2)distributed representation:

具有相似上下文的词,应该具有相似的语义。这个假说被称为distributional hypothesis。词的distributed representation(分布式表示)就是一种表示能够刻画语义之间的相似度并且维度较低的稠密向量表示,例如:

高兴=[0.2,1.6,?0.6,0.7,0.3]T

开心=[0.3,1.4,?0.5,0.9,0.2]T

这样,便可通过计算向量的余弦相似度,来反映出词的语义相似度。

二、文档向量的生成:

(1)word2vec模型生成词向量的distriputed representation 通过对句子取平均值的方式得到整个句子的向量。

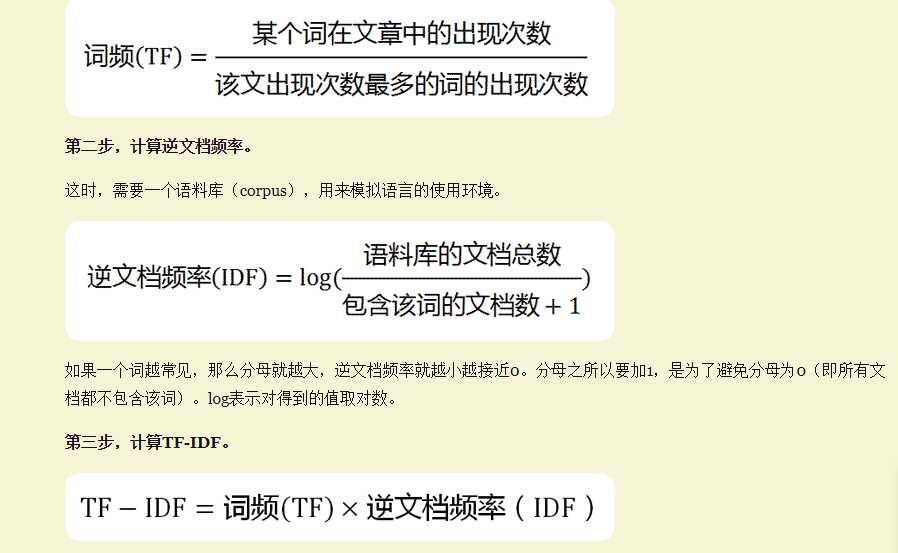

(2)TF-INF算法个词语在一篇文章中出现次数越多, 同时在所有文档中出现次数越少, 越能够代表该文章 加1,是为了避免分母为0

加1,是为了避免分母为0

标签:分布式 strong nta 上下文 项目总结 res 通过 img class

原文地址:https://www.cnblogs.com/zydxx/p/9867031.html