标签:apach 文件 apache shell 自动跳转 xxx detail 地址 info

折腾了好几天的问题,终于解决了。虽然这次遇到的问题没在网络上找到答案,不过,解决问题的过程或多或少受到了网上一些答案的启发。下面我将分享自己遇到的问题,并提供解决方法。

(一)、相关资料

http://hadoop.apache.org/docs/r1.0.4/cn/quickstart.html #官网指导

http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_shell.html #shell命令

https://blog.csdn.net/jsutdoit/article/details/82120336 #指导博客

https://blog.csdn.net/weixin_38070561/article/details/81289601 #使用python中的pyhdfs连接HDFS进行操作

(二)、遇到的问题

1、web端访问正常,但是查看文件和上传文件都不行,点击下载文件默认跳转到:localhost:50075/XX/XX/ 在浏览器地址栏将localhost替换成服务器IP可以正常下载。

在网上查看了很多资料,改hdfs-site.xml,进入/etc/hosts添加主机名。。。无论改成什么样的主机名都不行。

想着,既然自动跳转到localhost,那我就将localhost和服务器IP绑定。添加一行 XX.XX.XX.XX(XX代指IP) localhost.改完之后保存,重启Hadoop。

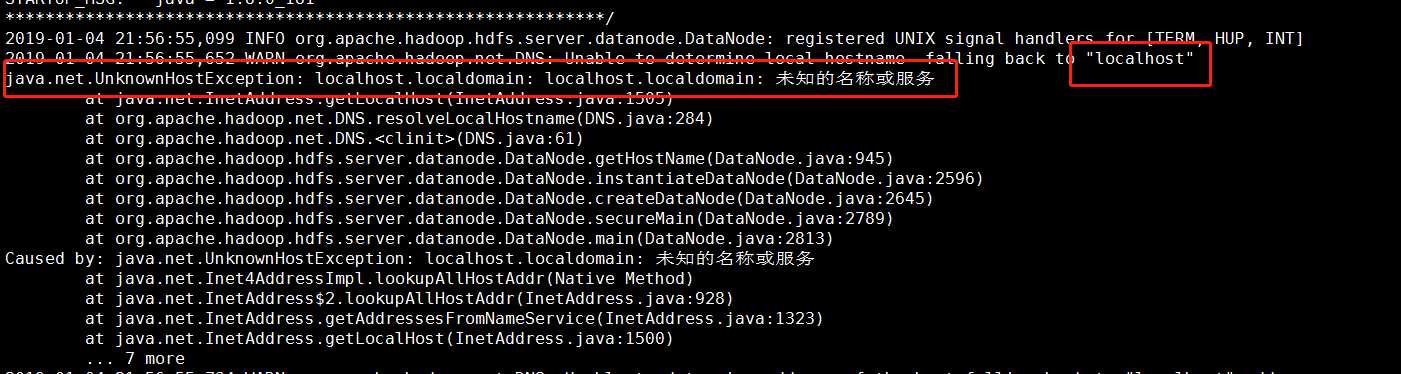

发现web端网页不能打开:http:XXX:50070打不开,查看日志文件,发现报错了。。。

根据日志文件可知是刚刚的主机名配置有问题。hadoop是取的这个“localhost.localdomain”,随即我将localhost换成localhost.localdomain。保存,重启Hadoop。

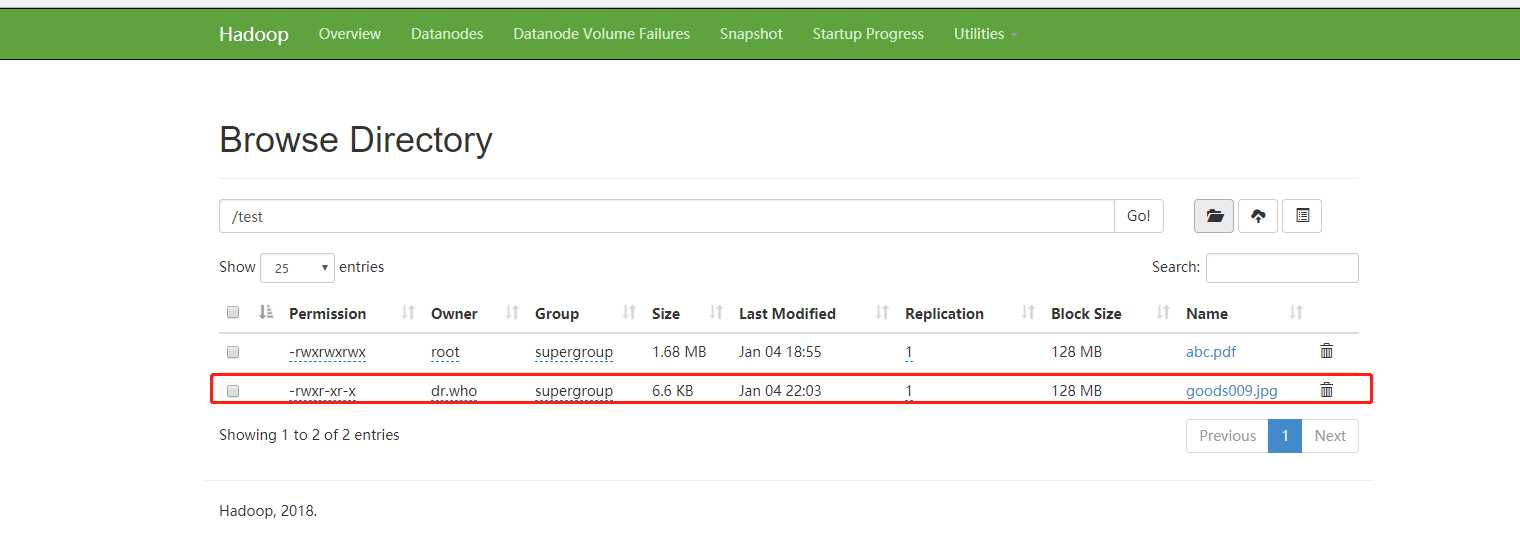

上传下载都没问题,大工告成。随后我用pyhdfs连接,也可以实现上传下载。啊。。。终于解开了心结。看似很小的一个问题,给我折腾了两天。唉~

标签:apach 文件 apache shell 自动跳转 xxx detail 地址 info

原文地址:https://www.cnblogs.com/tanghu/p/10222891.html