标签:保留 引入 net info nbsp href ref 方案 com

https://blog.csdn.net/cindy_1102/article/details/89010066

一、既然我们已经对消失梯度问题的本质和它在深度神经网络中的表现有了直观的认识,那么让我们关注一个简单而实用的启发式方法来解决这些问题。

为了解决梯度爆炸的问题,Thomas Mikolov首先引入了一个简单的启发式解决方案,当梯度爆炸时,将梯度裁剪为一个小数值。也就是说,当它们达到某个阈值时,就会被重新设置为一个小数值.

二、LSTM能保留信息,所以一定程度上能解决梯度消失

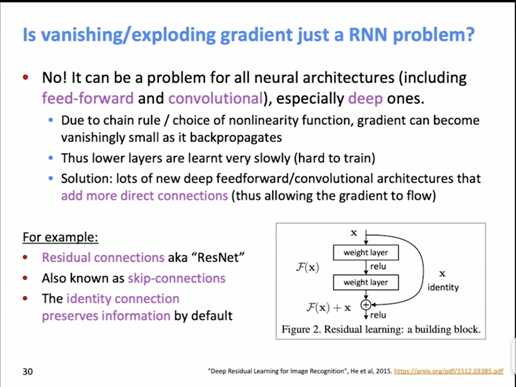

那梯度消失/爆炸问题仅是RNN才会出现的问题吗? 1、不是,它是所有神经网络共性的问题,包括前向和卷积神经网络,特别是深度神经网络。 原因: 1、由于链式法则或非线性激活函数,当梯度回传的时候,梯度会变得很小。 2、靠近输入层的网络学习的较为缓慢。 解决办法: 前向和卷积神经网络增加更多直接的链接,比如残差网络。

标签:保留 引入 net info nbsp href ref 方案 com

原文地址:https://www.cnblogs.com/TMatrix52/p/12967740.html