标签:style blog http color com width

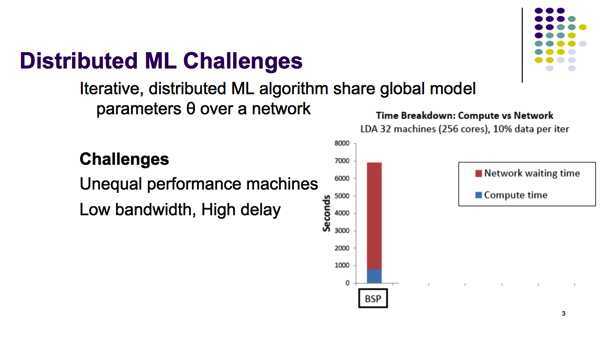

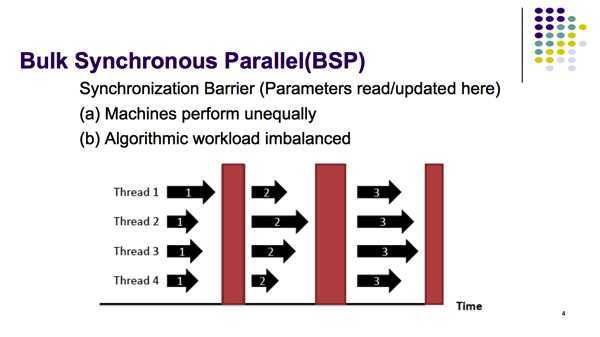

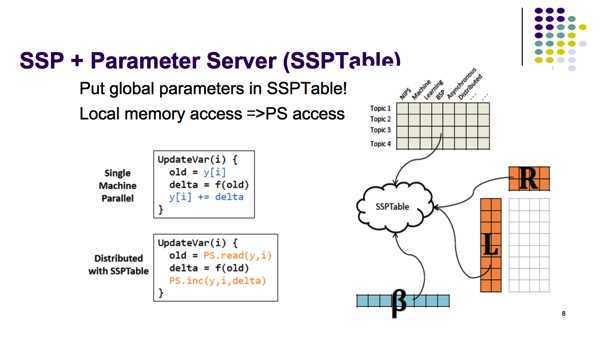

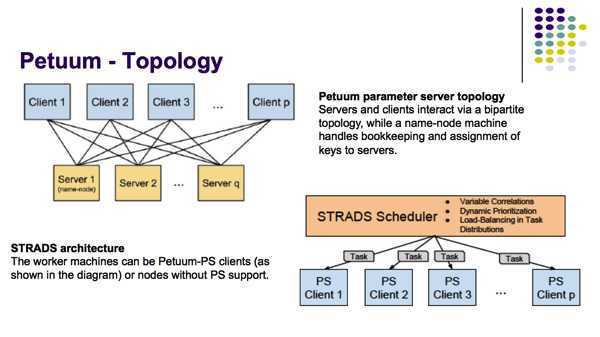

Petuum是一个分布式机器学习专用计算框架,本文介绍其架构,并基于文章 More Effective Distributed ML via a Stale Synchronous Parallel Parameter Server,NIPS 2013 重点探讨其核心内容SSP协议。

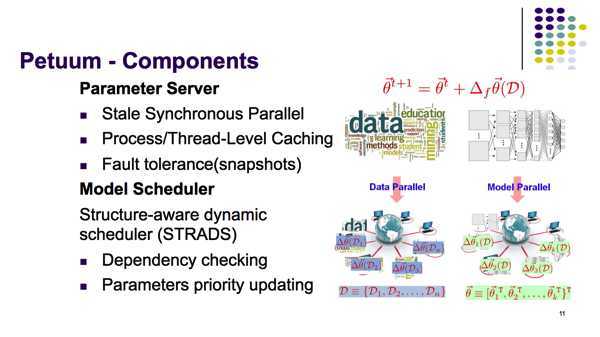

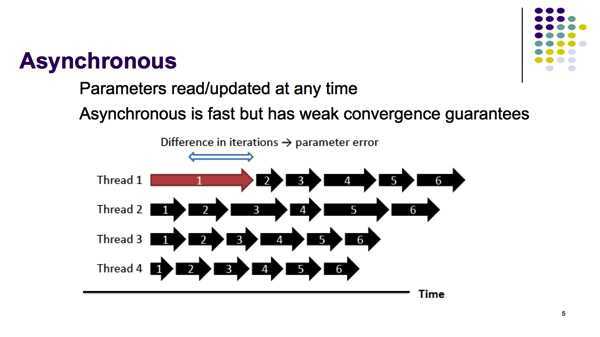

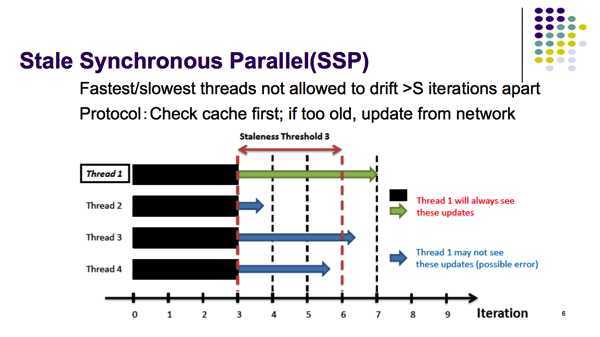

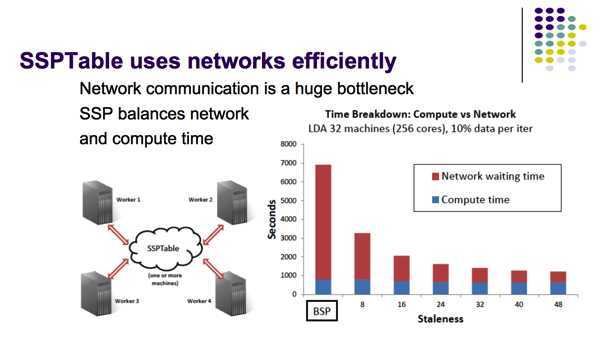

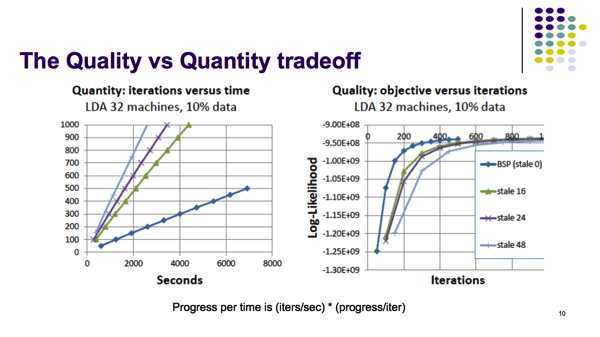

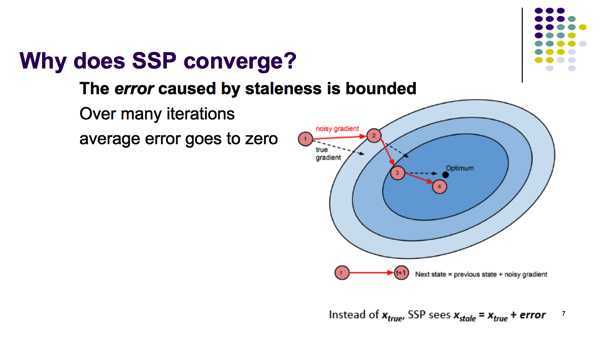

Parameter server提供了一个易于读写Global模型参数的接口,而SSP协议允许distributed workers读写本地缓存中stale版本的参数(而不是每次都花大量时间时间等待central storage传回最新参数)。更进一步,通过限制参数的stale程度,SSP模型提供了机器学习算法的正确性保证。

十分钟了解分布式计算:Petuum,布布扣,bubuko.com

标签:style blog http color com width

原文地址:http://www.cnblogs.com/wei-li/p/3786411.html