标签:排序 不同 hold com ble 生成 返回 csu 分配

基于BOW的图像检索

一,图像检索概述

矢量空间模型

K-means算法

Bag of features原理

二,python实现过程

代码

结果分析

一,图像检索概述

基于文本的图像检索方法始于上世纪70年代,它利用文本标注的方式对图像中的内容进行描述,从而为每幅图像形成描述这幅图像内容的关键词,比如图像中的物体、场景等,这种方式可以是人工标注方式,也可以通过图像识别技术进行半自动标注。在进行检索时,用户可以根据自己的兴趣提供查询关键字,检索系统根据用户提供的查询关键字找出那些标注有该查询关键字对应的图片,最后将查询的结果返回给用户。这种基于文本描述的图像检索方式由于易于实现,且在标注时有人工介入,所以其查准率也相对较高。在今天的一些中小规模图像搜索Web应用上仍有使用,但是这种基于文本描述的方式所带来的缺陷也是非常明显的:首先这种基于文本描述的方式需要人工介入标注过程,使得它只适用于小规模的图像数据,在大规模图像数据上要完成这一过程需要耗费大量的人力与财力,而且随时不断外来的图像在入库时离不开人工的干预;其次,”一图胜千言”,对于需要精确的查询,用户有时很难用简短的关键字来描述出自己真正想要获取的图像;再次,人工标注过程不可避免的会受到标注者的认知水平、言语使用以及主观判断等的影响,因此会造成文字描述图片的差异。

随着图像数据快速增长,针对基于文本的图像检索方法日益凸现的问题,在1992年美国国家科学基金会就图像数据库管理系统新发展方向达成一致共识,即表示索引图像信息的最有效方式应该是基于图像内容自身的。自此,基于内容的图像检索技术便逐步建立起来,并在近十多年里得到了迅速的发展。典型的基于内容的图像检索基本框架如上图1.1所示,它利用计算机对图像进行分析,建立图像特征矢量描述并存入图像特征库,当用户输入一张查询图像时,用相同的特征提取方法提取查询图像的特征得到查询向量,然后在某种相似性度量准则下计算查询向量到特征库中各个特征的相似性大小,最后按相似性大小进行排序并顺序输出对应的图片。基于内容的图像检索技术将图像内容的表达和相似性度量交给计算机进行自动的处理,克服了采用文本进行图像检索所面临的缺陷,并且充分发挥了计算机长于计算的优势,大大提高了检索的效率,从而为海量图像库的检索开启了新的大门。不过,其缺点也是存在的,主要表现为特征描述与高层语义之间存在着难以填补的语义鸿沟,并且这种语义鸿沟是不可消除的。

基于内容的图像检索技术在电子商务、皮革布料、版权保护、医疗诊断、公共安全、街景地图等工业领域具有广阔的应用前景。在电子商务方面,谷歌的Goggles、 阿里巴巴的拍立淘等闪拍购物应用允许用户抓拍上传至服务器端,在服务器端运行图片检索应用从而为用户找到相同或相似的衣服并提供购买店铺的链接;在皮革纺织工业中,皮革布料生产商可以将样板拍成图片,当衣服制造商需要某种纹理的皮革布料时,可以检索库中是否存在相同或相似的皮革布料,使得皮革布料样本的管理更加便捷;在版权保护方面,提供版权保护的服务商可以应用图像检索技术进行商标是否已经注册了的认证管理;在医疗诊断方面,医生通过检索医学影像库找到多个病人的相似部位,从而可以协助医生做病情的诊断……基于内容的图像检索技术已经深入到了许许多多的领域,为人们的生活生产提供了极大的便利。

矢量空间模型

最初的Bag of words,也叫做“词袋”,在信息检索中,Bag of words model假定对于一个文本,忽略其词序和语法,句法,将其仅仅看做是一个词集合,或者说是词的一个组合,文本中每个词的出现都是独立的,不依赖于其他词是否出现,或者说当这篇文章的作者在任意一个位置选择一个词汇都不受前面句子的影响而独立选择的。

现在Computer Vision中的Bag of words来表示图像的特征描述也是很流行的。大体思想是这样的,假设有5类图像,每一类中有10幅图像,这样首先对每一幅图像划分成patch(可以是刚性分割也可以是像SIFT基于关键点检测的),这样,每一个图像就由很多个patch表示,每一个patch用一个特征向量来表示,咱就假设用Sift表示的,一幅图像可能会有成百上千个patch,每一个patch特征向量的维数128。

接下来就要进行构建Bag of words模型了,假设Dictionary词典的Size为100,即有100个词。那么咱们可以用K-means算法对所有的patch进行聚类,k=100,我们知道,等k-means收敛时,我们也得到了每一个cluster最后的质心,那么这100个质心(维数128)就是词典里德100 个词了,词典构建完毕。

词典构建完了怎么用呢?是这样的,先初始化一个100个bin的初始值为0的直方图h。每一幅图像不是有很多patch么?我们就再次计算这些patch和和每一个质心的距离,看看每一个patch离哪一个质心最近,那么直方图h中相对应的bin就加1,然后计算完这幅图像所有的 patches之后,就得到了一个bin=100的直方图,然后进行归一化,用这个100维的向量来表示这幅图像。对所有图像计算完成之后,就可以进行分类聚类训练预测之类的了。

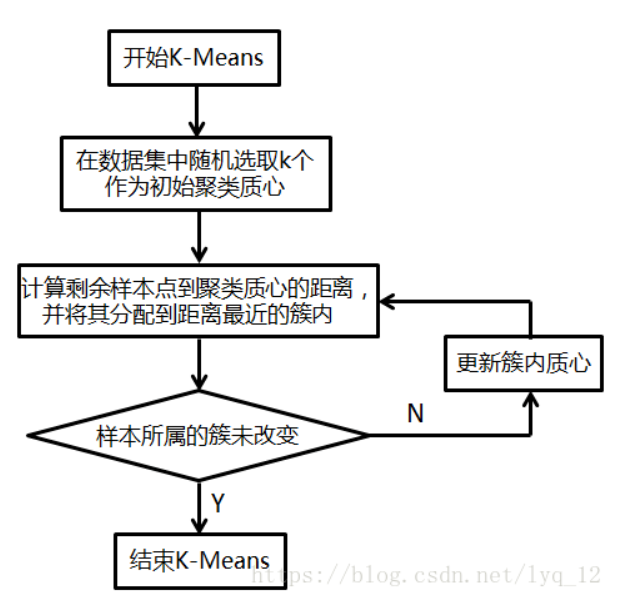

K-means算法

2.1、算法步骤

输入:样本集D,簇的数目k,最大迭代次数N;

输出:簇划分(k个簇,使平方误差最小);

算法步骤:

(1)为每个聚类选择一个初始聚类中心;

(2)将样本集按照最小距离原则分配到最邻近聚类;

(3)使用每个聚类的样本均值更新聚类中心;

(4)重复步骤(2)、(3),直到聚类中心不再发生变化;

(5)输出最终的聚类中心和k个簇划分;

Bag of features原理

一、(BOF)图像检索算法原理

BoW(Bag-of-Features)算法是由Csurka等在2004年提出并应用于图像处理领域的,该算法广泛应用于目标识别和图像检索。算法主要思想借鉴了文本检索的思想。在检索文本的过程中,文本由一系列的基本单元组成,这个单元通常是单词;同理,一副图像也可以看成是由一系列的基本单元组成,这些图像中的基本单元称为视觉单词(visual words)。

首先,我们用surf算法生成图像库中每幅图的特征点及描述符,再用k-means算法对图像库中的特征点进行训练,生成类心。生成每幅图像的BOF,具体方法为:判断图像的每个特征点与哪个类心最近,最近则放入该类心,最后将生成一列频数表,即初步的无权BOF。通过tf-idf对频数表加上权重,生成最终的bof。(因为每个类心对图像的影响不同。比如超市里条形码中的第一位总是6,它对辨别产品毫无作用,因此权重要减小)。对query进来的图像也进行3.4步操作,生成一列query图的BOF。将query的Bof向量与图像库中每幅图的Bof向量求夹角,夹角最小的即为匹配对象。

图像可以视为一种文档对象,图像中不同的局部区域或其特征可看做构成图像的词汇,其中相近的区域或其特征可以视作为一个词。这样,就能够把文本检索及分类的方法用到图像分类及检索中去。

1、局部特征提取:通过分割、密集或随机采集、关键点或稳定区域、显著区域等方式使图像形成不同的patches,并获得各patches处的特征。其中,SIFT特征较为流行。

2、构建视觉词典,由聚类中心代表的视觉词汇形成视觉词典。

3、生成码书,即构造Bag-of-Features特征,也即局部特征投影过程。

4、SVM训练BOF特征得分类模型,对待测图像BOF特征预测。

python实现过程

import pickle

from PCV.imagesearch import vocabulary

from PCV.tools.imtools import get_imlist

from PCV.localdescriptors import sift

from PCV.imagesearch import imagesearch

from PCV.geometry import homography

from sqlite3 import dbapi2 as sqlite

#获取图像列表

imlist = get_imlist(‘./datasets/‘)

nbr_images = len(imlist)

#获取特征列表

featlist = [imlist[i][:-3]+‘sift‘ for i in range(nbr_images)]

#提取文件夹下图像的sift特征

for i in range(nbr_images):

sift.process_image(imlist[i], featlist[i])

#生成词汇

voc = vocabulary.Vocabulary(‘ukbenchtest‘)

voc.train(featlist, 888, 10) # 使用k-means算法在featurelist里边训练处一个词汇

# 注意这里使用了下采样的操作加快训练速度

# 将描述子投影到词汇上,以便创建直方图

#保存词汇

# saving vocabulary

with open(‘./BOW/vocabulary.pkl‘, ‘wb‘) as f:

pickle.dump(voc, f)

print (‘vocabulary is:‘, voc.name, voc.nbr_words)

import pickle

from PCV.imagesearch import vocabulary

from PCV.tools.imtools import get_imlist

from PCV.localdescriptors import sift

from PCV.imagesearch import imagesearch

from PCV.geometry import homography

from sqlite3 import dbapi2 as sqlite # 使用sqlite作为数据库

视觉词典

#获取图像列表

imlist = get_imlist(‘./datasets/‘)

nbr_images = len(imlist)

#获取特征列表

featlist = [imlist[i][:-3]+‘sift‘ for i in range(nbr_images)]

# load vocabulary

#载入词汇

with open(‘./BOW/vocabulary.pkl‘, ‘rb‘) as f:

voc = pickle.load(f)

#创建索引

indx = imagesearch.Indexer(‘testImaAdd.db‘,voc) # 在Indexer这个类中创建表、索引,将图像数据写入数据库

indx.create_tables() # 创建表

# go through all images, project features on vocabulary and insert

#遍历所有的图像,并将它们的特征投影到词汇上

for i in range(nbr_images)[:888]:

print(featlist[i])

locs,descr = sift.read_features_from_file(featlist[i])

indx.add_to_index(imlist[i],descr) # 使用add_to_index获取带有特征描述子的图像,投影到词汇上

# 将图像的单词直方图编码存储

# commit to database

#提交到数据库

indx.db_commit()

con = sqlite.connect(‘testImaAdd.db‘)

print (con.execute(‘select count (filename) from imlist‘).fetchone())

print (con.execute(‘select * from imlist‘).fetchone())

图像检索

# -*- coding: utf-8 -*-

#使用视觉单词表示图像时不包含图像特征的位置信息

import pickle

from PCV.localdescriptors import sift

from PCV.imagesearch import imagesearch

from PCV.geometry import homography

from PCV.tools.imtools import get_imlist

# load image list and vocabulary

#载入图像列表

imlist = get_imlist(‘./datasets/‘)

nbr_images = len(imlist)

#载入特征列表

featlist = [imlist[i][:-3]+‘sift‘ for i in range(nbr_images)]

#载入词汇

with open(‘./BOW/vocabulary.pkl‘, ‘rb‘) as f:

voc = pickle.load(f)

src = imagesearch.Searcher(‘testImaAdd.db‘,voc)# Searcher类读入图像的单词直方图执行查询

# index of query image and number of results to return

#查询图像索引和查询返回的图像数

q_ind = 4

nbr_results = 2

# regular query

# 常规查询(按欧式距离对结果排序)

res_reg = [w[1] for w in src.query(imlist[q_ind])[:nbr_results]] # 查询的结果

print (‘top matches (regular):‘, res_reg)

# load image features for query image

#载入查询图像特征进行匹配

q_locs,q_descr = sift.read_features_from_file(featlist[q_ind])

fp = homography.make_homog(q_locs[:,:2].T)

# RANSAC model for homography fitting

#用单应性进行拟合建立RANSAC模型

model = homography.RansacModel()

rank = {}

# load image features for result

#载入候选图像的特征

for ndx in res_reg[1:]:

try:

locs, descr = sift.read_features_from_file(featlist[ndx])

except:

continue

# locs,descr = sift.read_features_from_file(featlist[ndx]) # because ‘ndx‘ is a rowid of the DB that starts at 1

# get matches

matches = sift.match(q_descr,descr)

ind = matches.nonzero()[0]

ind2 = matches[ind]

tp = homography.make_homog(locs[:,:2].T)

# compute homography, count inliers. if not enough matches return empty list

# 计算单应性矩阵

try:

H,inliers = homography.H_from_ransac(fp[:,ind],tp[:,ind2],model,match_theshold=4)

except:

inliers = []

# store inlier count

rank[ndx] = len(inliers)

# sort dictionary to get the most inliers first

# 对字典进行排序,可以得到重排之后的查询结果

sorted_rank = sorted(rank.items(), key=lambda t: t[1], reverse=True)

res_geom = [res_reg[0]]+[s[0] for s in sorted_rank]

print (‘top matches (homography):‘, res_geom)

# 显示查询结果

imagesearch.plot_results(src,res_reg[:6]) #常规查询

imagesearch.plot_results(src,res_geom[:6]) #重排后的结果

结果分析:

维度的情况下,一般来说,随着维度的增加,检索的结果随着维度的增加效果越好,因为维度越大,其中所包含的信息就越多,但是当维度过于大的时候,就可能使得检索结果更差,因为此时计算量大,容易过拟合,而维度太小,就使得视觉单词无法覆盖所有可能出现的情况,使得检索效果不好。

??同时,使用的图片对本次实验也有影响,一些图片背景比较复杂,就会导致特征点提取的时候提取到一些无关的特征点,所以可能使得实验检索的效果不好,因为这些特征点可能会导致匹配出现问题。

标签:排序 不同 hold com ble 生成 返回 csu 分配

原文地址:https://www.cnblogs.com/BigSamllKing/p/14856333.html